IBM ã®Project Bob(以é™Bobã¨ç•¥ã—ã¾ã™ï¼‰ã€çš†ã•ã‚“ã‚‚ã†è©¦ã—ã¾ã—ãŸã‹ï¼Ÿ

Project Bobã®ã‚¦ã‚§ã‚¤ãƒ†ã‚£ãƒ³ã‚°ãƒªã‚¹ãƒˆ

ã€å‚考】å‰å›žã®ãƒ•ã‚¡ãƒ¼ã‚¹ãƒˆã‚¿ãƒƒãƒä½“験記

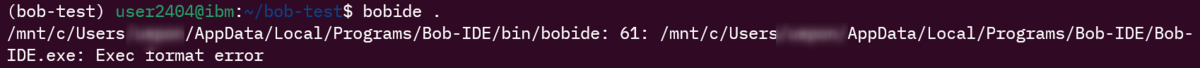

watsonx Code Assistantã®åŸºç›¤æŠ€è¡“ã¨ã—ã¦ã‚‚注目ã•ã‚Œã¦ã„ã‚‹Bobã§ã™ãŒã€ä»Šå›žã¯é›£ã—ã‚ã®ã‚¿ã‚¹ã‚¯ã«æŒ‘戦ã—よã†ã¨æ€ã„ã€WSL(Ubuntu) 上ã‹ã‚‰Bobã‚’èµ·å‹•ã—よã†ã¨ã—ãŸã¨ã“ã‚……(ã¡ãªã¿ã«Bobã®èµ·å‹•ã‚³ãƒžãƒ³ãƒ‰ã¯bobideã§ã™ï¼‰

$ bobide . /mnt/c/Users/xxxxx/AppData/Local/Programs/Bob-IDE/bin/bobide: 61: /mnt/c/Users/xxxxx/AppData/Local/Programs/Bob-IDE/Bob-IDE.exe: Exec format error

ã„ããªã‚Šã‚¨ãƒ©ãƒ¼ã€‚

エラーメッセージを見るã¨ã€bobide スクリプトã®61行目㧠Bob-IDE.exe を実行ã—よã†ã¨ã—ã¦å¤±æ•—ã—ã¦ã„るよã†ã§ã™ã€‚

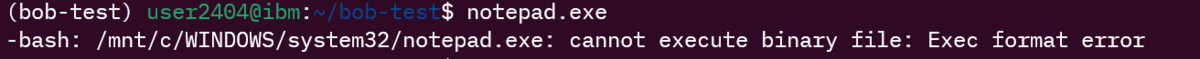

「インストール失敗ã—ãŸï¼Ÿãƒ‘スãŒãŠã‹ã—ã„?ã€ã¨æ€ã£ã¦ã€åˆ‡ã‚Šåˆ†ã‘ã®ãŸã‚ã« notepad.exe ã‚’å©ã„ã¦ã¿ãŸã‚“ã§ã™ãŒâ€¦â€¦

$ notepad.exe -bash: /mnt/c/WINDOWS/system32/notepad.exe: cannot execute binary file: Exec format error

ã“れも似ãŸã‚ˆã†ãªã‚¨ãƒ©ãƒ¼ã€‚ã¤ã¾ã‚Š Bob-IDE ã®å•é¡Œã§ã¯ãªãã€WSL ã‹ã‚‰ Windows ã® exe ãŒä¸€åˆ‡èµ·å‹•ã§ããªã„状態ã§ã™ã€‚

続ãã‚’èªã‚€