近年、クラウドサービスの選択肢はますます多様化しており、さまざまなクラウドが活用されています。

世界のクラウドプロバイダーのシェア上位3社を見ると、AWSが29%、Microsoft Azureが20%、Google Cloudが13%となっており※、

Microsoft AzureやGoogle Cloud Platformも成長を続けていますが、依然としてAWSがトップの座を維持しています。

(※2025年第3四半期データ Cloud Market Growth Rate Rises Again in Q3; Biggest Ever Sequential Increase | Synergy Research Group)

実際、当チームでもクラウド案件の多くは引き続きAWSが中心です。

そこで本記事では、LifeKeeperによる可用性対応の観点から、AWSでよく採用される代表的な構成パターンについて紹介します。

AWS環境で高可用性設計を検討されている方の参考になれば幸いです。

AWS OSごとの基本構成

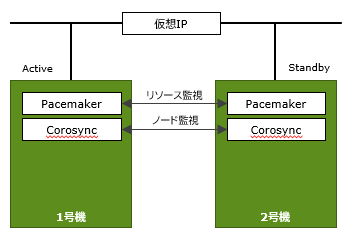

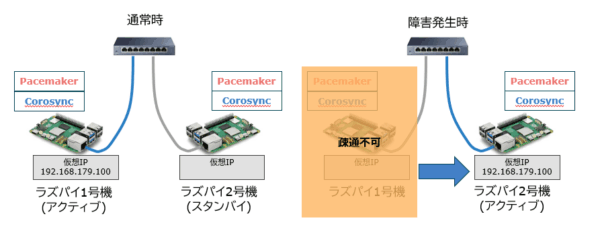

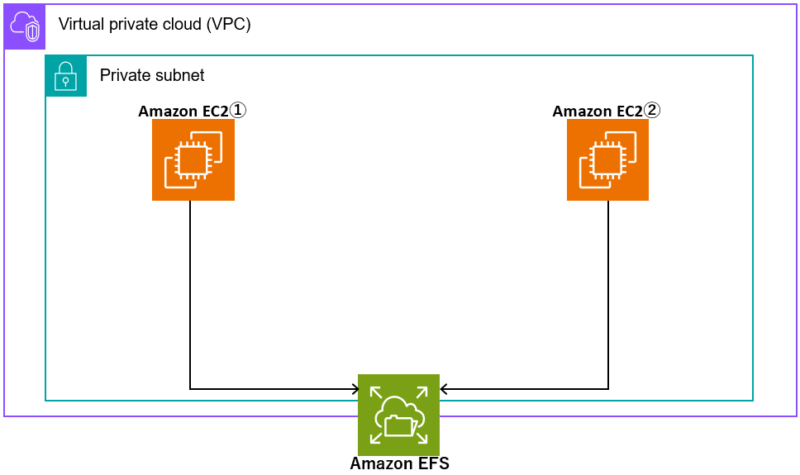

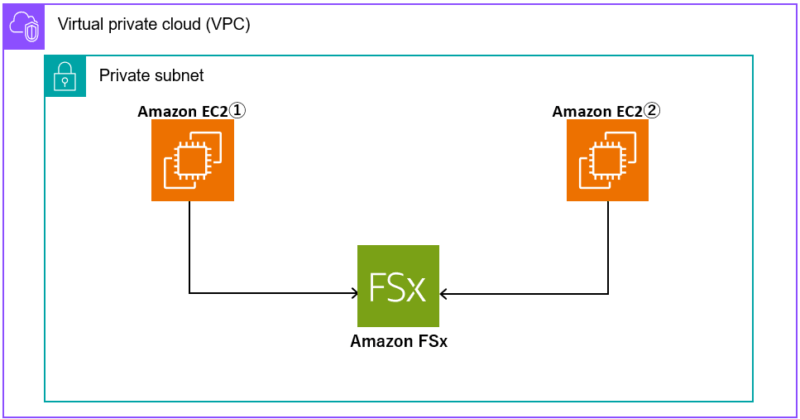

Amazon EC2で冗長化構成をとる場合のOSごとの基本構成は以下の通りです。(稼働系、待機系ノード間でデータ共有を行う場合を想定。)

基本的に他のクラウドやオンプレミスの仮想環境と大きく変わりません。

Windows環境の場合はWindows標準機能のWSFCを使用することでコストを抑えた高可用性を確保することができます。

| Linux | Windows | |

| LifeKeeper+DataKeeperの組み合わせ | LifeKeeper+DataKeeperの組み合わせ | WSFC+DataKeeperの組み合わせ |

|

|

|

※DataKeeperによるデータレプリケーションは必須ではなく、LifeKeeperのみの構成も可能です。

※図では省略しておりますが、可用性の観点から、各クラスターノードを別々のアベイラビリティゾーン(AZ)に配置することで、物理的な障害発生時にもシステム停止リスクを最小限に抑えることが可能です。

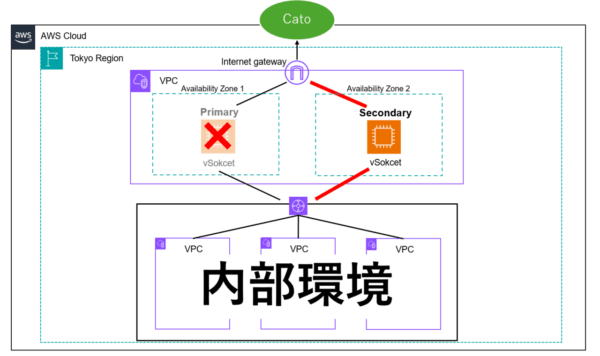

ルートテーブルシナリオ(仮想IPとルートテーブルによる制御)

この構成はクラスターを同じVPC内のクライアントから接続される際によく用いられます。

クライアント(クラスタノードと通信するマシン)は仮想IPに向けて通信することでActiveノードに到達できます。

AWS環境でAZを跨ぐとサブネットも跨いでしまうので、オンプレミスのように仮想IPだけではクライアントは正しくActiveノードへ到達できません。

そこで、VPCのCIDR外の仮想IPをルートテーブルに登録し、転送先のActive/StandbyノードのENIをクラスターの切り替え時にLifeKeeperからAWS CLIを介して書き換えることで、クライアントは常にActiveノードに到達できます。

②ルートテーブルにはあらかじめ仮想IPのTaegetとして稼働系のENI(図では10.0.2.4)を指定しておくことで、

クライアントからの通信は稼働系へ到達します。

③フェイルオーバー時には、LifeKeeperから自動的にAWS CLIが実行され、ルートテーブルの仮想IPのターゲットが待機系ENIに書き換えられます。以降はクライアントからの通信は待機系に到達します。

この構成で利用必須となるRecovery Kit: Recovery Kit for EC2、Recovery Kit for IP Address

※注意:AWSの仕様上、クライアントはクラスタと同じVPCに存在している必要があります。

仮想IPはVPCのCIDR外で割り当てる必要があります。

・Linux

AWS EC2リソースの作成(ルートテーブルシナリオ) – LifeKeeper for Linux LIVE – 10.0

Recovery Kit for EC2™ 管理ガイド – LifeKeeper for Linux LIVE – 10.0

・Windows

Recovery Kit for Amazon EC2™ 管理ガイド – LifeKeeper for Windows LIVE – 10.0

ルートテーブルシナリオにAWS Transit Gatewayを組み合わせた制御

ルートテーブルシナリオにAWS Transit Gatewayを組み合わせることで、VPC外(オンプレミスや別VPC)からもクライアント通信に対応できます。

例えば、JP1等の統合運用管理ツール、HULFTなどのファイル転送ソフトでクライアントがVPC外にいる場合、この構成が有効です。

この構成で利用必須となるRecovery Kit: Recovery Kit for EC2、Recovery Kit for IP Address

※注意:Transit Gateway向きのルートテーブル設定を行っておく必要があります。

・Linux

AWS Direct Connect クイックスタートガイド – LifeKeeper for Linux LIVE – 10.0

Recovery Kit for EC2™ 管理ガイド – LifeKeeper for Linux LIVE – 10.0

・Windows

AWS Direct Connect クイックスタートガイド – LifeKeeper for Windows LIVE – 10.0

Recovery Kit for Amazon EC2™ 管理ガイド – LifeKeeper for Windows LIVE – 10.0

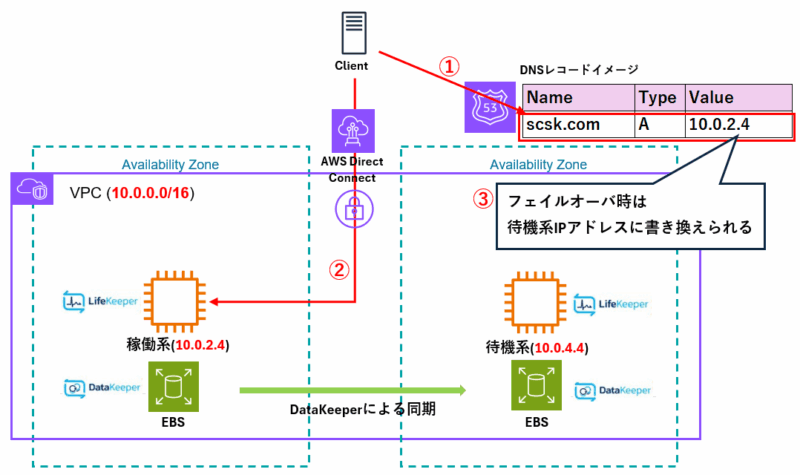

Route53のAレコード書き換えによる制御

Transit Gatewayが使えない場合などに、DNSサービスのRoute53での名前解決を利用する構成です。

クライアントはRoute53により名前解決された実IPに向けて通信することで、Activeノードへ到達できます。

名前解決した実IPアドレスで稼働系ノードにアクセスします。

②Route53のAレコードには、稼働系ノードのIPアドレス(図では10.0.2.4)を指定しておくことで、クライアントからの通信は稼働系へ到達します。

③フェイルオーバ時には、LifeKeeperからAWS CLIを実行し、Route53のAレコードを待機系ノードのIPアドレス(図では10.0.4.4)へ書き換えることで、以降のクライアントからの通信は待機系に到達します。

この構成で利用必須となるRecovery Kit: Recovery Kit for Amazon Route 53™、Recovery Kit for IP Address

※注意:クライアントはホスト名(FQDN)でアクセスできることが前提になります。

LifeKeeper(Recovery Kit for Amazon Route 53™)に登録するホストゾーン名がパブリックホストゾーン、プライベートホストゾーンで複数存在している場合、Recovery Kit for Amazon Route 53™によるリソース作成は現状不可となりますのでご注意ください。

(参考:同名のホストゾーンは使えない!? Amazon Route 53リソース作成時の注意点 – TechHarmony)

⇒上記問題発覚後、サイオステクノロジー社に改善提案を出したところ、今後改善予定で動いているとのこと。(2025年12月時点リリース時期未定)

・Linux

AWS Route53 シナリオ – LifeKeeper for Linux LIVE – 10.0

Recovery Kit for Amazon Route 53™ 管理ガイド – LifeKeeper for Linux LIVE – 10.0

AWS Route 53リソースの作成 – LifeKeeper for Linux LIVE – 10.0

・Windows

Recovery Kit for Amazon Route 53™ 管理ガイド – LifeKeeper for Windows LIVE – 10.0

NLBのヘルスチェックによる制御

NLB(Network Load Balancer)のヘルスチェックを利用した構成です。

セキュリティ要件により、前述のようなAWS CLIによる構成変更が実施できない、インターネットに接続していない環境でクライアントからDNS名でアクセスしたい場合にはこの構成をご検討下さい。

クライアントからはNLBのDNS名でアクセスし (AWS内部のRoute 53経由で解決)、NLBのヘルスチェックとLB Health Check Kitを組み合わせて、ヘルスプローブを受け取ったノードにトラフィックを転送することで接続先の切り替えを実現します。

(DNS 名はAWS内部のRoute 53経由でNLBのサブネットのIPアドレスに変換されます)

②NLBには、プロトコルとポートに対してどのターゲットグループへ転送するかが登録されています。このとき、どのノードがヘルスプローブに応答するかを確認します。

③アクティブノードではNLBのヘルスプローブに応答します。LifeKeeperによってヘルスプローブに応答するLB Health Checkリソースは常にひとつのインスタンスでのみアクティブになっているため、NLBのヘルスプローブに応答するのはアクティブノードだけです。つまり、NLBは常にアクティブノードだけにトラフィックを転送します。

④NLBは、Clientからの接続要求を、アクティブノードに転送します。そのため最終的に接続要求は、宛先アドレスがNLBのアドレスからアクティブノードの実IPアドレス に書き換えられて、アクティブノードに到達します。

この構成で利用必須となるRecovery Kit: LB Health Check Kit、Recovery Kit for IP Address

・Linux

AWS – Network Load Balancerの使用 – LifeKeeper for Linux LIVE – 10.0

AWS Network Load Balancerシナリオ – LifeKeeper for Linux LIVE – 10.0

・Windows

AWSでロードバランサーを使用した構成 – LifeKeeper for Windows LIVE – 10.0

さいごに

今回は代表的な構成についてご紹介しましたが、

その他にもクロスリージョン構成やAWS Outpostsで共有ディスクを冗長化させるなど様々な構成にも対応しています。

・AWS Elastic IPシナリオ構成:AWS Elastic IPシナリオ – LifeKeeper for Linux LIVE – 10.0

・クロスリージョン構成:[Linux][Windows] AWSのクロスリージョン環境において仮想IPで通信できる構成をサポート – SIOS LifeKeeper/DataKeeper User Portal

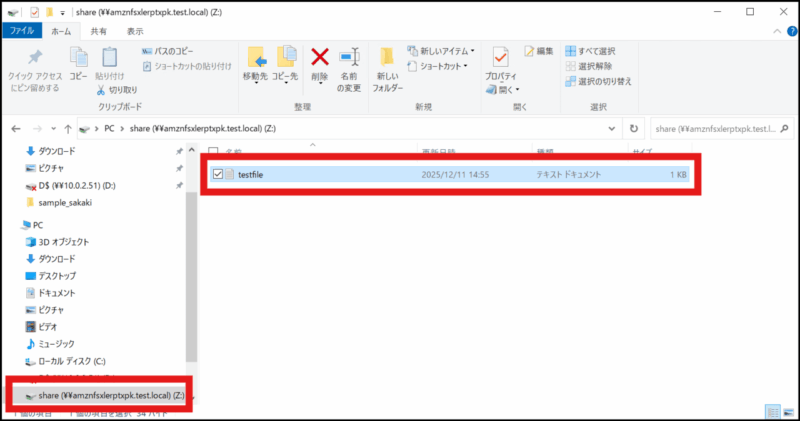

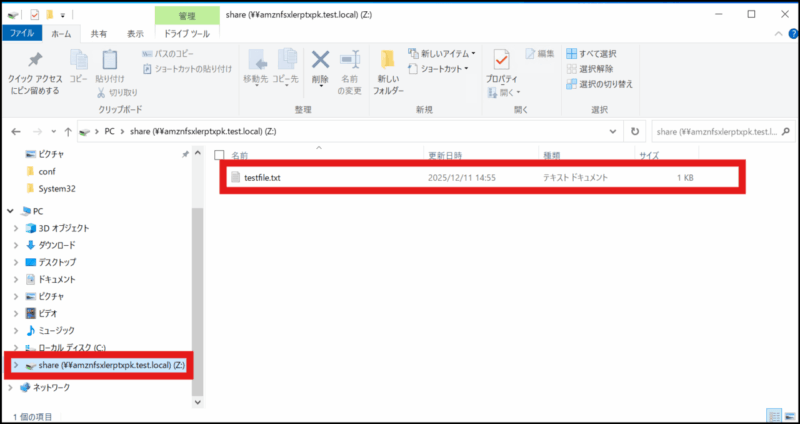

・Amazon FSx for NetApp ONTAP利用構成:Amazon FSx for NetApp ONTAPのサポート開始について | ビジネス継続とITについて考える

・AWS Outposts ラック利用構成:AWS Outposts ラックでの可用性を高めるHAクラスター構成|ユースケース|サイオステクノロジー株式会社

この記事で紹介されていない構成につきましては弊社やサイオステクノロジー社にお問い合わせ頂くことを推奨いたします

本記事がAWS環境における冗長化の参考になりましたら幸いです!

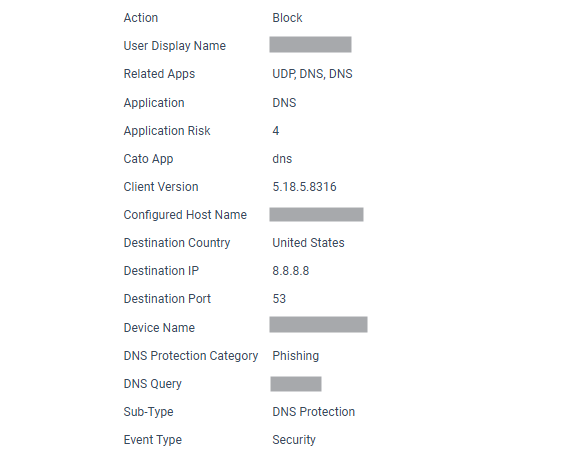

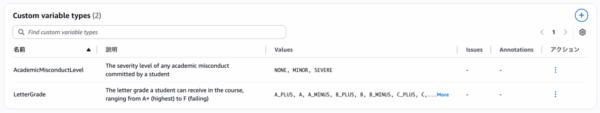

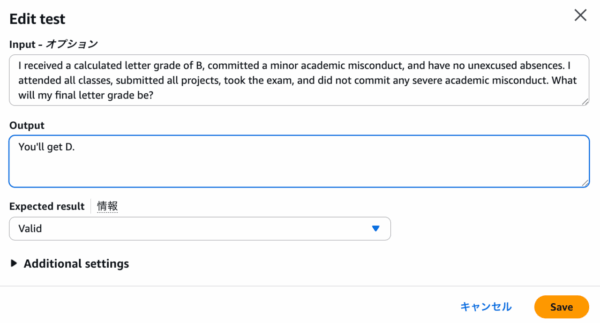

こんにちは、高坂です。

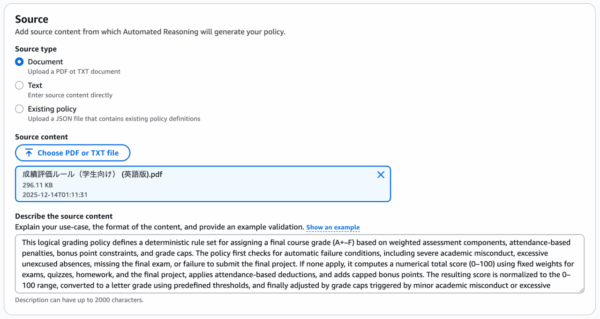

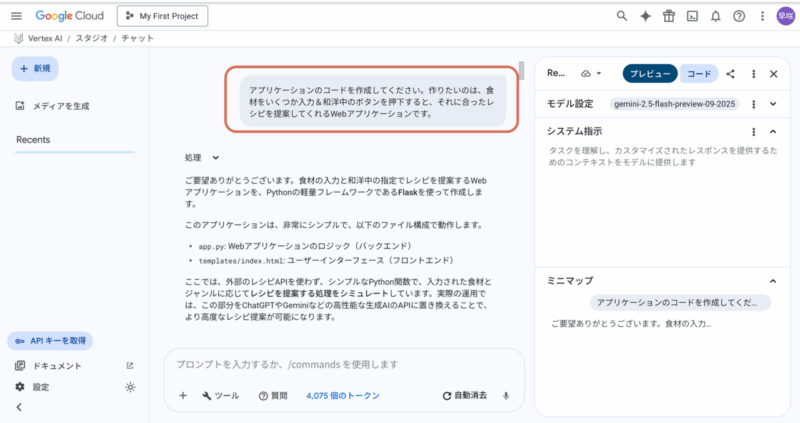

前回の記事では、Prisma Cloudのアラート解決状況をバブルチャートで可視化する試みについてご紹介しました。

バブルチャートでの可視化は、「どの領域で」「どれくらいの量と重要度のアラートが」「どの程度放置されているか」を直感的に把握する上で非常に有効でした。しかし、2次元のグラフであるバブルチャートでは、主に扱える変数が限られるという制約がありました。例えば、「アラートの種類」と「重要度」という2つの軸で状況を見ることはできても、そこに3つ目以上の要因を加えて、より多角的に分析することは困難でした。

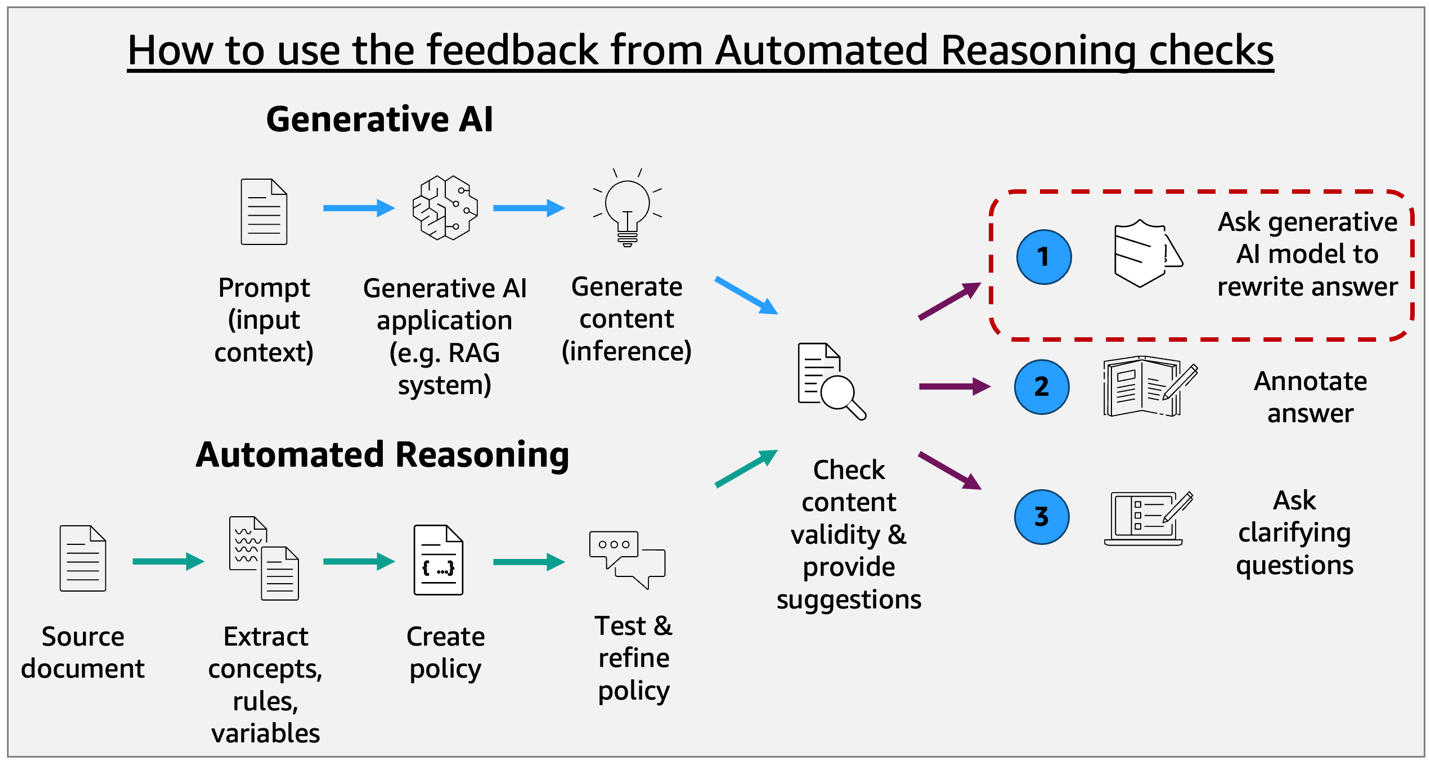

そこで今回は、機械学習の手法の一つである「決定木」を使い、アラートの対応条件を分析する方法を試しました。決定木を用いることで、Policy Type(種類)、Policy Severity(重要度)、そしてAlert Time(発生時期)といった複数の変数を同時に扱い、「チームの対応ルールがいつ、どのように変化したか」を解明することを目指します。

決定木とは

決定木は、機械学習のアルゴリズムの一種で、その名の通り、データを分類するためのルールを木のような構造(ツリー構造)で表現する手法です。

詳しい仕組みは以下の記事がわかりやすいです。

決定木を用いる最大のメリットは、その結果の分かりやすさにあります。他の高度な機械学習モデルが、時に「ブラックボックス」として振る舞うことがあるのに対し、決定木は人間が読んで解釈できる「if-then」形式のルールを出力します。

分析の前提と注意点

ただし、この決定木が万能というわけではないことを注釈しておきます。

決定木は、分析対象のデータ、今回の場合だとチームのアラート対応状況に、何らかの一貫したパターンや傾向(=暗黙のルール)が存在することを前提としています。

今回の決定木での分析を行えば、必ずしも明確な結果が保証されるわけではないということはご了承ください。

もし、チームの対応方針が定まっておらず完全に場当たり的であったり、担当者ごとに判断基準が大きく異なっていたりする場合、決定木は明確で解釈しやすいルールを見つけ出せない可能性があります。結果として、非常に複雑で、ビジネス的な意味を見出しにくいツリーが出力されるかもしれません。

可視化の準備:分析シナリオと仮想データの作成

今回の分析では「Policy Type」、「Policy Severity」、「Alert Time」、「Alert Status」のデータを使用していきます。

決定木がどのようなルールを見つけ出すのかを具体的に見ていくために、今回は「とある組織で行われたアラート対応」という仮想的なシナリオを用意し、それに基づいてダミーデータを用意しました。

このシナリオには、明確なアラート対応と「改善前」と「改善後」のフェーズが存在します。

【Phase 1】 対応ルール導入前(〜2025年7月31日まで)

この組織のセキュリティ運用チームは、日々大量に発生するアラートへの対応に追われ、疲弊していました。明確なトリアージ基準はなく、対応は一部のベテラン担当者の経験と勘に頼っている状況でした。

この時期の暗黙的な対応ルールは、非常にシンプルでした。

Criticalアラートだけは絶対に対応する: これだけは経営層からも厳しく言われていたため、何があっても必ず解決していました。- それ以外(

High以下)は、ほぼ手付かず: チームのリソースが足りず、ほとんどのアラートは未解決(Open)のまま放置されていました。

【Phase 2】 新ルール導入の時代(2025年8月1日以降)

2025年8月1日、チームに経験豊富な新しいマネージャーが着任し、アラート対応プロセスを抜本的に見直しました。アラートの重要度とタイプに基づいた、明確なトリアージルールを導入したのです。

新しいルールは以下の通りです。

CriticalとHighは、最優先で必ず解決する。MediumとLowは、タイプによって対応を分ける。configタイプ: 新しく導入された自動修復スクリプトの対象となり、ほぼ自動で解決されるようになりました。- それ以外のタイプ(

iam,network,anomaly): 手動での調査が必要なため優先度が低く、多くが未解決のままとなりました。

データ構成のマトリクス

上記のシナリオを、ダミーデータ生成のための具体的な構成表にまとめます。

| 期間 | 条件 | Policy Severity |

Policy Type |

Alert Status の確率分布 |

|---|---|---|---|---|

| Phase 1(〜2025/7/31) | Severityがcritical |

critical |

すべて | resolved: 95%

|

Severityがcriticalでない |

high, medium, low, informational |

すべて | open: 90%

|

|

| Phase 2(2025/8/1〜) | Severityがhigh以上 |

critical, high |

すべて | resolved: 98%

|

Severityがmedium以下 |

medium, low, informational |

config |

resolved: 90%

|

|

Severityがmedium以下 |

medium, low, informational |

iam, network, anomaly |

open: 85%

|

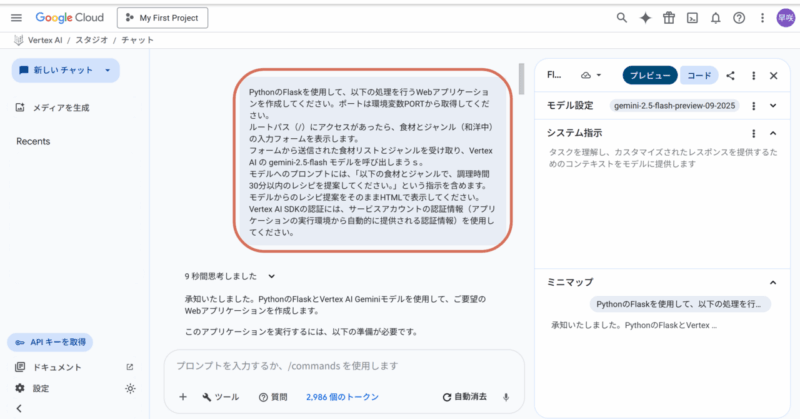

Pythonによる実装

今回の可視化分析には、前回同様Pythonを使用しました。

主な利用ライブラリは、データの加工にはpandas、モデルの学習にはscikit-learnを利用しました。

処理の概要

ここではコードの全ての詳細には触れませんが、実装の主要なステップと、特に工夫したポイントをご紹介します。

Step1: データの前処理

まず、pandasを使って生のアラートデータをモデルが学習できる形式に変換します。 今回の分析の鍵であるAlert Timeは、そのままでは機械学習モデルが扱えません。そこで、各アラートの発生日時を、分析期間の開始日からの経過日数(days_since_start)という数値に変換しました。これにより、決定木は「開始から何日目以降」といった時間的な分岐点を見つけ出せるようになります。 また、Policy TypeやPolicy Severityといったカテゴリカルなデータも、モデルが理解できる数値形式(ダミー変数)に変換しています。

Step2: モデルの学習

次に、scikit-learnのDecisionTreeClassifierを使って、準備したデータから決定木モデルを学習させます。 この際、前章で触れたポリシーの重要度を分析に反映させるために、重要度ごとに重みづけを実装しています。fitメソッドを呼び出す際に、criticalやhighのアラートに計算した「重み」を渡すことで、実際のセキュリティー運用を考慮した分析を目指しています。

Step3: 2つのアウトプット生成

学習が完了したら、その結果出力します。

今回の実装では通常の決定木とは別で、決定木の結果を生成AIに解釈してもらうためのルールテキストをJSONで生成します。

決定木の分析もAIにさせてみようという試みで、決定木の生成されたテキストを実際に生成AIに入力してみるところまでしてみようと思います。

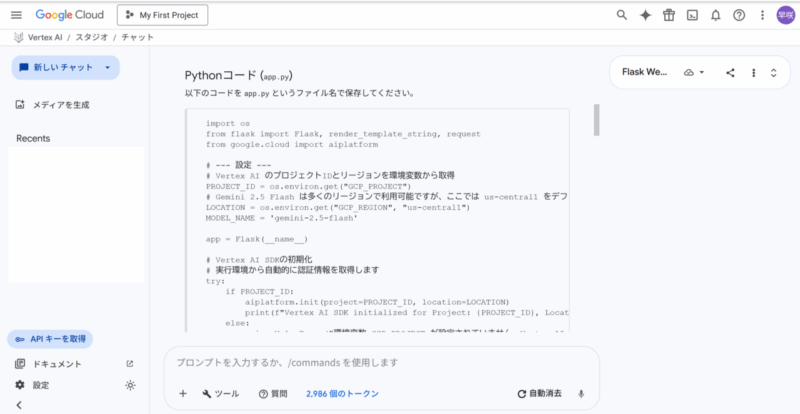

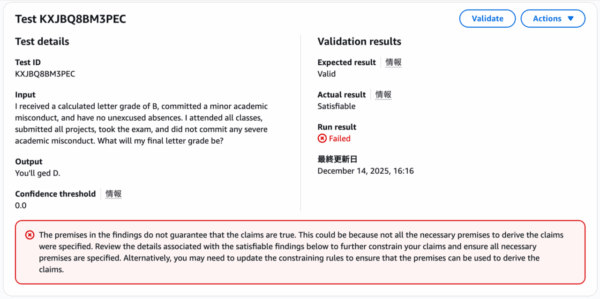

結果の表示

以下結果です。

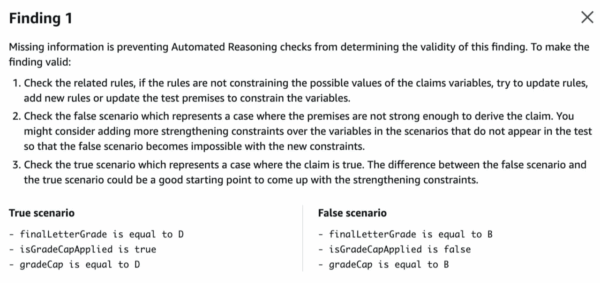

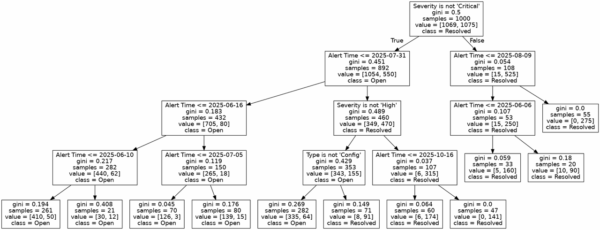

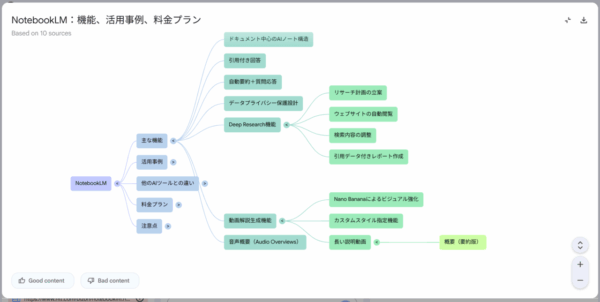

決定木

前述のダミーデータで決定木をさせると、以下の結果が得られました。

画像なので文字が見にくくて申し訳ないのですが、見方はざっくり以下です。

- 分岐条件: ノードの一番上に書かれているテキスト(例:Severity is not ‘Critical’)は、データを分割するための質問(分岐条件)です。

- 分岐の方向: この条件を満たす場合(真 / True)は左下のノードへ、満たさない場合(偽 / False)は右下のノードへとデータが振り分けられます。

samples: そのノードに到達したアラートの総数を示しています。value:samplesの内訳です。class_namesが['Open', 'Resolved']の順であるため、例えばvalue = [315, 35]は、Openが315件、Resolvedが35件含まれていることを意味します。class: そのノードで最も多数派となったクラスを示します。つまり、そのノードに分類されたアラートが、最終的にどちらに予測されるかを表しています。ツリーの末端(葉ノード)では、これが最終的な結論となります。

以上を踏まえると、決定木の結果はざっくり以下の様に分析できます。

まず最初に、ポリシー重要度が”Critical”(Severity is not ‘Critical’がFalse)だとほとんどのアラートが”Resolved”となっていることがわかります。

ポリシー重要度が”Critical”じゃないアラートについては、次にAlert Timeで条件分岐が起こっています。

“Critical”以外のアラートでは、2025/7/31以前は”Open”,以降は”Resolved”となっております。

さらに2025/7/31のアラートについては、”High”アラートは”Resolved”で、”High”(とCritical)以外のアラートについては”Config”タイプのものは”Resolved”となっております。

どうでしょう、最初にご紹介したシナリオを再現できているのではないでしょうか。

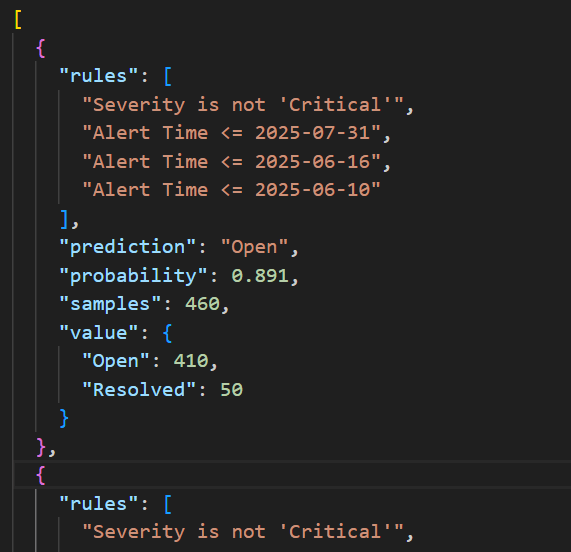

ルールテキスト

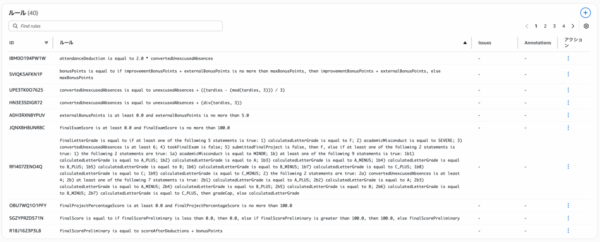

ルールテキストは以下の様に出力されます。

これをChatGPTのような生成AIに入力し、「結果を要約して」とお願いすると以下の結果を得ました。

以下は、提示された決定木の分析結果の要約です。

1. 「Severity(重大度)」で最初に分岐

「Critical(重大)」かどうかで大きく傾向が分かれる。2. Severityが「Critical」でない場合

【2025-07-31以前のアラート】

ほとんどが「Open」状態(解決されていない)。

「Alert Time」が細かく過去日付に分岐されるが、どの分岐も「Open」割合が高い(約70~98%)。

【2025-07-31以降のアラート】

「Severity」が「High」でない(それ以外):

「Type」が「Config」かどうかで差が出る。

「Config」タイプは、ほぼ「Resolved」。

それ以外は「Open」割合が高い。

「Severity」が「High」:

「Alert Time(警告発生日)」が新しいほど「Resolved」(解決済み)率が極めて高い(約97~100%)。3. Severityが「Critical」の場合

時期に関係なく「Resolved」が多い傾向。

2025-08-09以降は100%解決済み。

それより前でも90%以上が解決済み。

要点まとめ

Severityが高い(Critical / High)、かつアラートの発生日が新しければ「Resolved」(解決済み)が多い。

Severityが低く、発生日が古いほど「Open」(未解決)が多い。

Configタイプは比較的解決されやすい。

アラート発生直後や重大度の高いものは、解決対応が迅速に実施されている傾向。

この結果から、「重大なアラートほど早急に解決されるが、古い・低重大度のアラートは未解決が多い」

と言えるでしょう。運用上は、低重大度のアラートや古い未解決案件のフォローアップが課題となりそうです。

まとめ

今回は機械学習の手法の一つである「決定木」を使い、アラートの対応条件を分析する方法を試しました。

決定木分析の結果、「Severity(重大度)」「Type(アラート種別)」「Alert Time(発生日)」という三つの変数が分析結果に現れました。前回作成したバブルチャートでは主に一度に二要素までの関係しか視覚化できませんでしたが、決定木による分析により、3変数以上の要因の組み合わせの分析が可能になり、データの奥行きや傾向把握の可能性が広がったかと思います。

また、今回は決定木分析の結果をテキストに出力することで、結果の解釈と要約の部分で生成AIの活用の可能性を示せたかと思います。

今回紹介した手法は一例であり、データの性質や分析目的によっては、さらに多様な可視化や分析手法が存在します。今後もPrisma Cloudから取得できるデータのさらなる活用方法について、試行錯誤し結果を発信していければと考えております。

また、当社では、Prisma Cloudを利用して複数クラウド環境の設定状況を自動でチェックし、設定ミスやコンプライアンス違反、異常行動などのリスクを診断するCSPMソリューションを販売しております。ご興味のある方はお気軽にお問い合わせください。リンクはこちら↓

本記事は TechHarmony Advent Calendar 2025 12/25付の記事です。 本記事は TechHarmony Advent Calendar 2025 12/25付の記事です。 |

クリスマスマーケットでプレッツェルにハマりました

皆さんどうもこんにちは。いとさんです。

メリークリスマス!……と言いたいところですが、実は今日12月25日は、世界で初めて「Webサイト」が公開された記念すべき日でもあるそうです。

1990年の12月25日、イギリスの計算機科学者ティム・バーナーズ=リーが、世界で初めてのWebブラウザとサーバ間の通信に成功しました。 つまり、今こうして皆さんがブログを読めている環境の「誕生日」とも言える日なんです。ネットの歴史が動いたのがクリスマス当日だったというのは、なんだかロマンチックですよね。

さて今回はタイトルにもありますように

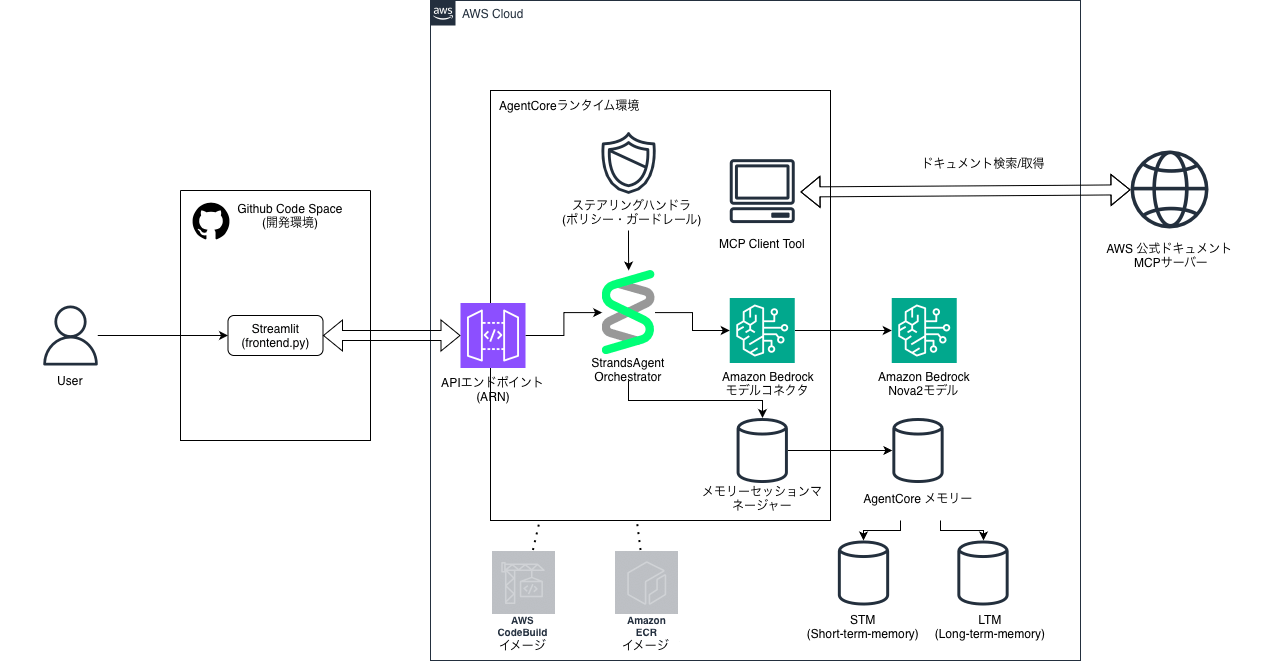

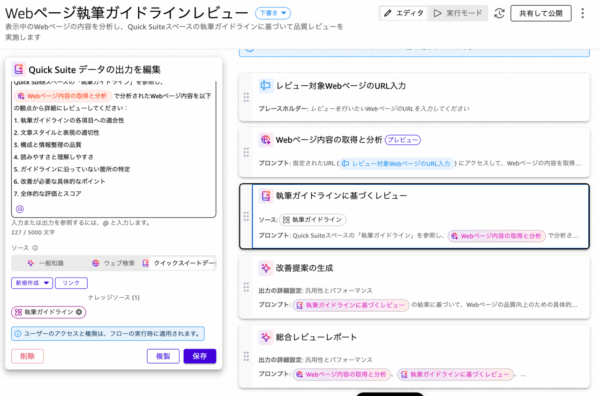

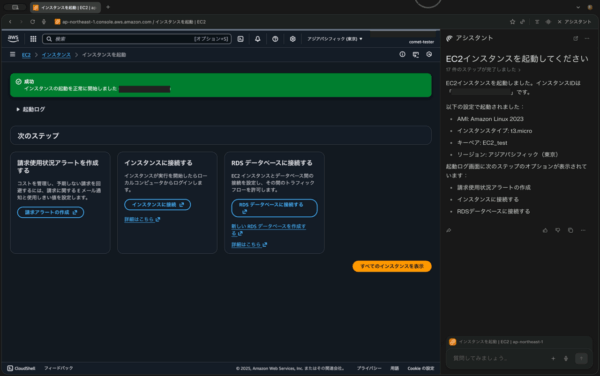

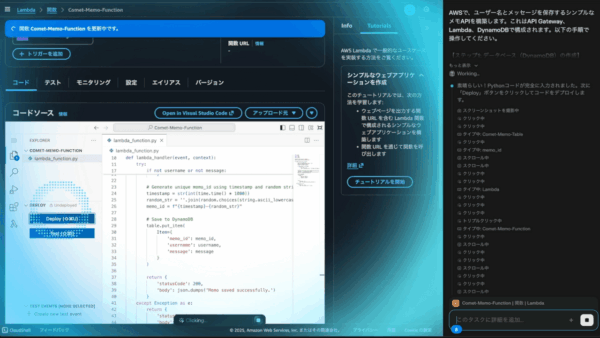

Amazon Bedrock AgentCore & Strands Agentsを使用したAWS構築支援エージェントの構築方法についてご紹介したいと思います!

AWS環境運用支援エージェント構築手順

🎯 エージェントの目標

AWS公式ドキュメントを使用した、開発・運用チーム向けのAWS運用支援エージェントを構築します。

チャットボットとの違いとして、自ら考え、道具を使い、経験を蓄積する「AIエージェント」としての機能を備えています。

チャットボットと「AIエージェント」の違いとは?

一般的なチャットボットは、あらかじめ学習した知識の範囲内でユーザーの問いに「反応」するだけですが、今回構築するAIエージェントには決定的な3つの違いがあります。

-

「知識」ではなく「道具」を使いこなす (Tools)

通常のチャットボットは古い知識で答えることがありますが、このエージェントは MCPClientというツールを使い、外部にある「最新のAWS公式ドキュメント」へ自らアクセスして情報を取得します。 -

「会話」ではなく「経験」を記憶する (Memory)

ブラウザを閉じれば忘れてしまうチャットボットと違い、AgentCore Memory を通じて「過去のトラブル対応事例」などを長期記憶(LTM)として蓄積します。これにより、使えば使うほど使用する環境に詳しい状態へと成長します。 -

「思考」の方向を制御できる安全性 (Steering)

自由奔放なAIとは異なり、LLMSteeringHandler によって「破壊的な操作の提案を禁止する」といった運用のガードレールを思考プロセスそのものに組み込んでいます。

このように、最新の公式情報(MCP)と経験(LTM)を、安全なルール(ステアリング)の上で統合して提供できるのが「AWS運用支援エージェント」なのです。

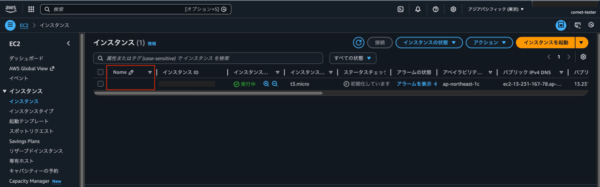

構成図

⚠️構築前提条件

- AWSアカウントを所有していること。

- GitHubアカウントを所有していること。

- AWSリージョンはバージニア北部 (

us-east-1) を利用します。(StrandsAgent使用可能リージョンのため) -

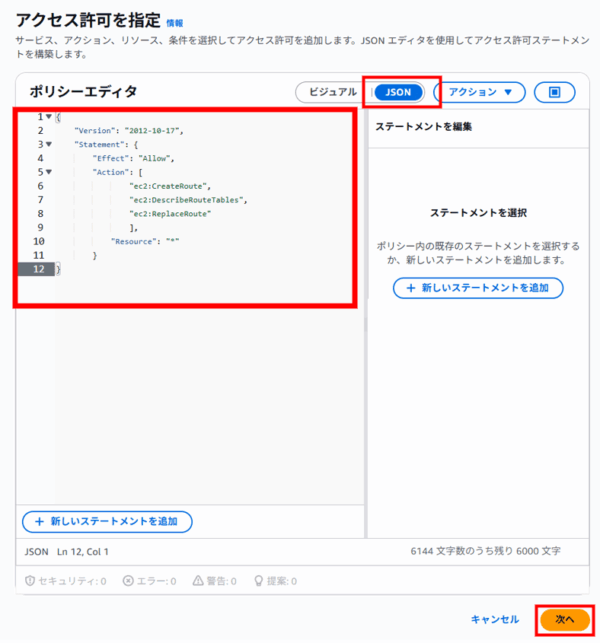

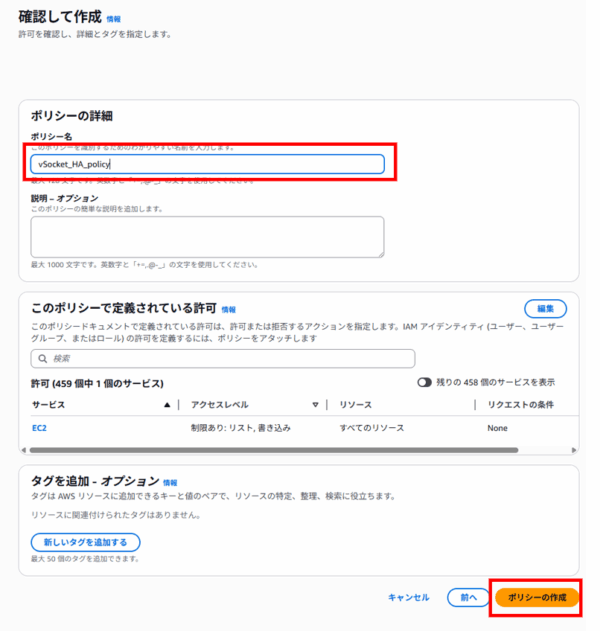

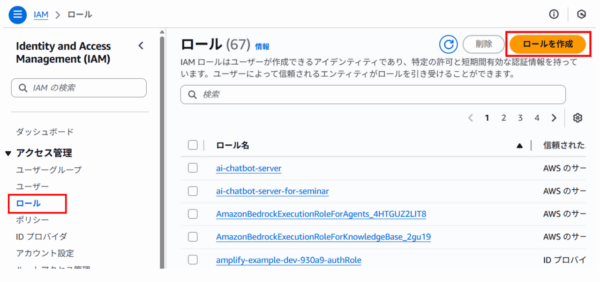

Administrator Access相当、もしくは以下のポリシーを適用したIAMユーザーで作業すること。

{ "Version": "2012-10-17", "Statement": [ { "Sid": "BedrockAccess", "Effect": "Allow", "Action": [ "bedrock:InvokeModel", "bedrock:ListFoundationModels", "bedrock:ListCustomModels" ], "Resource": "*" }, { "Sid": "AgentCoreFullAccess", "Effect": "Allow", "Action": "bedrock-agentcore:*", "Resource": "*" }, { "Sid": "S3AndECRForDeployment", "Effect": "Allow", "Action": [ "s3:CreateBucket", "s3:PutObject", "s3:GetObject", "s3:DeleteObject", "s3:ListBucket", "ecr:GetAuthorizationToken", "ecr:CreateRepository", "ecr:DeleteRepository", "ecr:BatchCheckLayerAvailability", "ecr:PutImage" ], "Resource": "*" }, { "Sid": "CodeBuildAndIAMManagement", "Effect": "Allow", "Action": [ "codebuild:*", "iam:CreateServiceLinkedRole", "iam:CreateRole", "iam:PutRolePolicy", "iam:DeleteRole", "iam:DeleteRolePolicy" ], "Resource": "*" }, { "Sid": "CloudWatchAndBoto3Access", "Effect": "Allow", "Action": [ "logs:*", "cloudwatch:*" ], "Resource": "*" } ] }

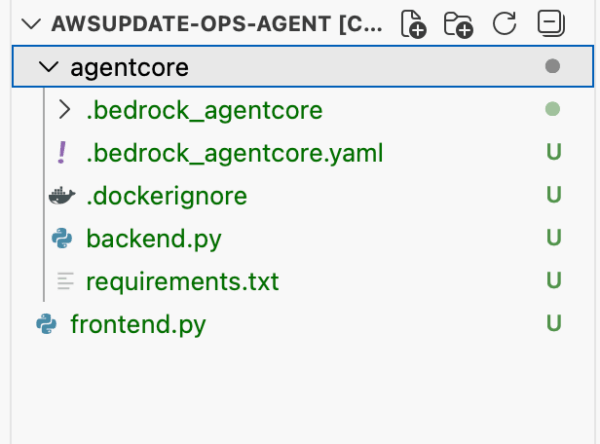

ステップ 1: 環境準備(CodeSpaceの利用)

まず、開発環境としてGitHub CodeSpacesをセットアップします。

- GitHubリポジトリの作成

GitHubで新しいプライベートリポジトリを作成します(例:aws-ops-agent)。 - CodeSpacesの起動

作成したリポジトリの画面左上「<> Code」ボタンから「Codespaces」タブを開き、「Create codespace on main」を選択して起動します。ターミナルが自動的に開きます。 -

AWS CLIのインストールと認証

ターミナルで以下のコマンドを実行し、AWS CLIをインストールします。# ダウンロード curl "https://awscli.amazonaws.com/awscli-exe-linux-x86_64.zip" -o "awscliv2.zip" # 解凍 unzip awscliv2.zip # インストール sudo ./aws/install

AWSアカウントへの認証を設定します(ブラウザでの検証コード入力が必要です)

aws login --remote

デフォルトリージョンが

us-east-1でいいか聞かれたら Enter を押します。

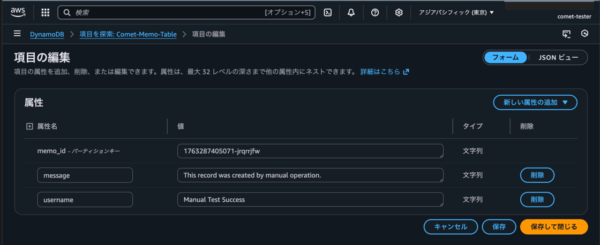

ステップ 2: AgentCoreメモリの作成(短期・エピソード記憶の準備)

エージェントが会話履歴と社内ナレッジを記憶するためのAgentCore Memoryを作成します。

- AgentCoreサービスへアクセス

AWSマネジメントコンソールで「AgentCore」を検索してアクセスします。

左メニューから「メモリー」>「メモリを作成」をクリックします。 - メモリ設定

すべてデフォルトのまま「メモリを作成」をクリックします。 -

エピソード記憶の有効化 (LTM)

作成したメモリの詳細画面を開き、「編集」をクリックします。

組み込み戦略の「Episodes」にチェックを入れ、「変更を保存」します。

重要: 作成されたメモリの Memory ID と、エピソード記憶戦略の 戦略ID を控えておきます。(エージェント本体の作成の際に使用します)

ステップ 3: エージェント本体の作成(backend.py)

エージェントの処理ロジックと、必要なツール、記憶、ステアリングを設定したAPIサーバーのコードを作成します。

-

ディレクトリとファイルの作成

以下のコードをコピーし、memory_XXXXX-XXXXXXXXXX(Memory ID) とepisodic_builtin_XXXXX-XXXXXXXXXX(戦略ID) のプレースホルダーを、ステップ2で控えた実際のIDに置き換えて貼り付けます。

mkdir agentcore cd agentcore touch backend.py -

# 必要なライブラリをインポート from strands import Agent from strands.tools.mcp import MCPClient from strands.models import BedrockModel from strands.experimental.steering import LLMSteeringHandler # ステアリング用 from bedrock_agentcore.runtime import BedrockAgentCoreApp from mcp.client.streamable_http import streamablehttp_client from bedrock_agentcore.memory.integrations.strands.config import AgentCoreMemoryConfig, RetrievalConfig from bedrock_agentcore.memory.integrations.strands.session_manager import AgentCoreMemorySessionManager # 1. モデル設定 model = BedrockModel( model_id="us.amazon.nova-2-lite-v1:0", max_tokens=4096 ) # 2. メモリー設定(STM/LTM) memory_config = AgentCoreMemoryConfig( memory_id="memory_XXXXX-XXXXXXXXXX", # ここをあなたのMemory IDに置き換える session_id="aws_ops_handson", actor_id="ops_engineer", retrieval_config={ # エピソード記憶(LTM)の検索設定 "/strategies/episodic_builtin_XXXXX-XXXXXXXXXX/actors/ops_engineer/sessions/aws_ops_handson": RetrievalConfig() # ここをあなたの戦略IDに置き換える } ) session_manager = AgentCoreMemorySessionManager( agentcore_memory_config=memory_config ) # 3. ツール設定 (MCPClient) mcp_client = MCPClient( lambda: streamablehttp_client( "https://knowledge-mcp.global.api.aws" ) ) # 4. ステアリング設定(ポリシーの強制) # 例: 破壊的な操作の推奨を禁止し、公式ドキュメント参照を強制 handler = LLMSteeringHandler( system_prompt="設定変更やリソース削除につながる操作は絶対に推奨しないでください。また、回答には必ず公式ドキュメントの参照URLを含めるようにしてください。" ) # AgentCoreランタイム用のAPIサーバーを作成 app = BedrockAgentCoreApp() # エージェント呼び出し関数を、APIサーバーのエントリーポイントに設定 @app.entrypoint async def invoke_agent(payload, context): # リクエストごとにエージェントを作成し、設定を適用 agent = Agent( model=model, tools=[mcp_client], # MCPClientをツールとして組み込む session_manager=session_manager, # 記憶(STM/LTM)を組み込む hooks=[handler] # ステアリング(ポリシー)を組み込む ) # エージェントをストリーミング呼び出し stream = agent.stream_async( payload.get("prompt") ) # ストリーミングレスポンスをフロントに返却 async for event in stream: yield event # APIサーバーを起動 app.run() -

touch requirements.txtrequirements.txtに以下をコピー&ペーストします。strands-agents strands-agents-tools strands-agents[otel] bedrock-agentcore bedrock-agentcore[strands-agents]依存関係のファイル(requirements.txt)の目的

ファイルを作成する具体的な理由

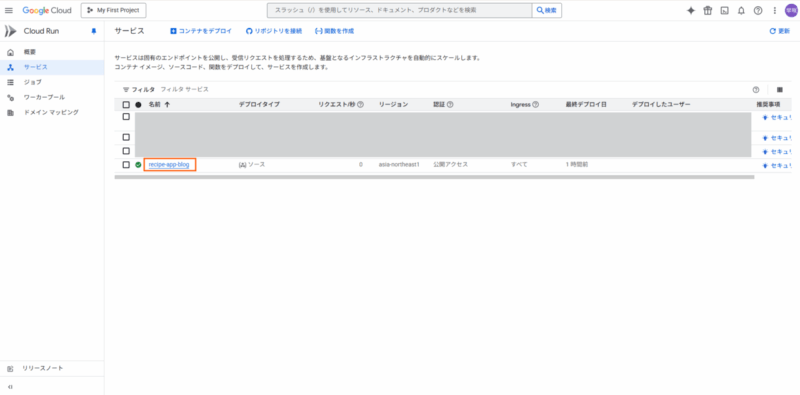

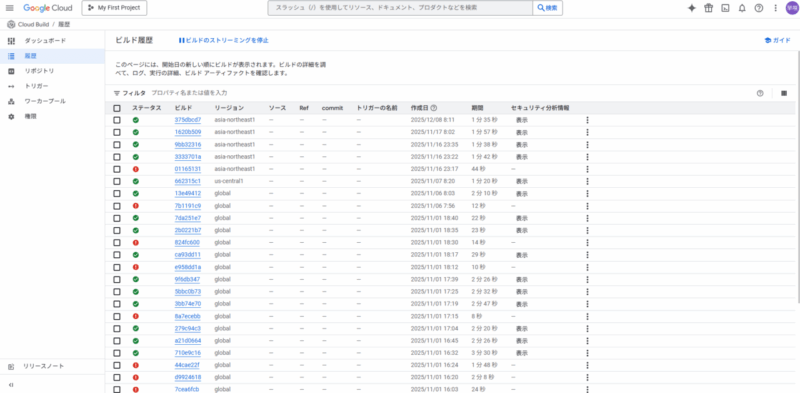

ステップ 4: AgentCoreランタイムへのデプロイ

作成したエージェントコードをAWS上で動作するAPIサーバーとしてデプロイします。

-

AgentCoreスターターキットのインストール

pip install bedrock-agentcore-starter-toolkit==0.2.2Amazon Bedrock AgentCore スターターキットとは

Amazon Bedrock AgentCore スターターキットは、AWS上で高性能なAIエージェントを「安全に」「速く」「大規模に」構築・運用するために必要なすべてが詰まった、開発者向けの公式ツールセット(CLIおよびライブラリ)です。

これを使用することで、インフラの知識が少なくても、数行のコードでプロ仕様のエージェントをクラウド上に公開できます。スターターキットに含まれる主な内容

このキットは主に以下の3つの要素で構成されています。要素 内容と役割

AgentCore CLI agentcore launch コマンドなどで、AWS上のサーバー(Runtime)やメモリ、セキュリティ設定を自動で構築・デプロイします。Strands Agents SDK エージェントの「脳」を動かすためのオープンソースSDK。Claude 3.5やNovaなどのLLMを使い、ツール呼び出しや推論を制御します。

サンプルテンプレート backend.py や requirements.txt の雛形。これを書き換えるだけで、自分の用途に合わせたエージェントがすぐに作れます。通常と使用した場合での比較

「通常(すべて自前)の開発」と「AgentCoreスターターキット + Strands」を使用した場合の比較解説します。

一言でいうと、通常の開発は「材料集めとキッチン作りから始める料理」ですが、スターターキットは「最新設備の整った厨房で、レシピ通りに作る料理」のような違いがあります。① 開発スピードと手間の比較

通常の開発では、AIの「脳」を作る前に「箱(インフラ)」を作る作業が膨大です。項目 通常の開発(自前) スターターキット使用 環境構築 Docker、サーバー、権限設定を個別に構築。 agentcore launch 一発で最適環境が完成。 ライブラリ管理 各ツールの互換性を自分で検証・修正。 公式SDKが最初から最適化されている。 デプロイ 数日~数週間(インフラ知識が必要)。 数分~数時間(Pythonの知識だけでOK)。 ② 運用性能と安全性の比較

個人開発外で使う場合、この「運用面」の差がリスクの違いになります項目 通常の開発(自前) スターターキット使用 実行時間制限 Lambda等だと15分で強制終了。 最大8時間の長時間処理が可能。 セッション分離 ユーザー間のデータ混入対策を自前実装。 セッションごとに完全隔離された安全な環境。 監視(デバッグ) ログを自前で集計・解析。 思考プロセスが自動で可視化される。 認証管理 APIキーの管理を暗号化して自作。 AgentCore Identity でセキュアに一元管理。 ③ 機能(賢さ)の拡張性の比較

エージェントに「新しい道具(ツール)」を持たせたい時の柔軟性が違います。

・通常の開発: 新しいツールを増やすたびに、プロンプトを調整し、API接続コードを書き、例外処理を手動で追加します。

・スターターキット: 世界標準の MCP (Model Context Protocol) に対応。Notion、Slack、GitHubなどの公式プラグインを、コードをほぼ書かずに「差し込むだけ」でエージェントが使いこなせます。通常開発が向いている人:

・AWSを使わない、または完全に独自のサーバー構成にこだわりがある。

・AIの推論ロジック自体を一から研究・開発したい。スターターキットが向いている人:

・「動くもの」を最速で作って業務に導入したい。

・セキュリティやスケーラビリティ(大人数での利用)を重視する。

・最新のClaude 3.5やAmazon Novaなどの高性能モデルを、最高の環境で使いこなしたい。 -

設定ファイルの自動生成

以下のコマンドを実行し、設定プロセスを開始します。agentcore configure対話形式で質問されますが、以下以外はすべて Enter で OK です。

Entrypoint:backend.pyと入力。-

Existing memory resources found:ステップ2で作成したメモリーの番号(例:[1]など)を入力。

-

ランタイムのデプロイ

以下のコマンドで、ECR、CodeBuild、AgentCoreランタイムなどのAWSリソースが自動で作成され、デプロイが開始されます。

agentcore launchデプロイ完了まで数分かかります。完了後、Runtime ARN が出力されるので、これを控えておきます。

ステップ 5: 動作確認用フロントエンドの作成と実行

デプロイされたAPIサーバーをテストするための簡単なWebインターフェース(Streamlitを利用)を作成します。

-

元の階層に戻る

cd ../ -

frontend.pyの作成

frontend.py を作成し、以下のコードをコピー&ペーストします。

touch frontend.pyfrontend.pyの内容:# 必要なライブラリをインポート import os, boto3, json import streamlit as st # サイドバーを描画 with st.sidebar: # デプロイ後に得られたAgentCoreランタイムのARNを入力 agent_runtime_arn = st.text_input("AgentCoreランタイムのARN") # タイトルを描画 st.title("AWS環境運用支援エージェント") st.write("Strands AgentsがMCP(AWSドキュメント)とLTM(社内ナレッジ)を使って運用を支援します!") # チャットボックスを描画 if prompt := st.chat_input("質問を入力してください(例:IAMポリシーの最小権限原則のベストプラクティスを教えて)"): # ユーザーのプロンプトを表示 with st.chat_message("user"): st.markdown(prompt) # エージェントの回答を表示 with st.chat_message("assistant"): try: # AgentCoreランタイムを呼び出し agentcore = boto3.client('bedrock-agentcore') payload = json.dumps({"prompt": prompt}) response = agentcore.invoke_agent_runtime( agentRuntimeArn=agent_runtime_arn, payload=payload.encode() ) # ストリーミングレスポンスの処理 container = st.container() text_holder = container.empty() buffer = "" for line in response["response"].iter_lines(): if line and line.decode("utf-8").startswith("data: "): data = line.decode("utf-8")[6:] # 文字列コンテンツの場合は無視 if data.startswith('"') or data.startswith("'"): continue # 読み込んだ行をJSONに変換 event = json.loads(data) # ツール利用を検出 if "event" in event and "contentBlockStart" in event["event"]: if "toolUse" in event["event"]["contentBlockStart"].get("start", {}): # 現在のテキストを確定 if buffer: text_holder.markdown(buffer) buffer = "" # ツールステータスを表示 tool_name = event["event"]["contentBlockStart"]["start"]["toolUse"].get("name", "unknown") container.info(f"🔍 {tool_name} ツールを利用しています") text_holder = container.empty() # テキストコンテンツを検出 if "data" in event and isinstance(event["data"], str): buffer += event["data"] text_holder.markdown(buffer) elif "event" in event and "contentBlockDelta" in event["event"]: buffer += event["event"]["contentBlockDelta"]["delta"].get("text", "") text_holder.markdown(buffer) # 最後に残ったテキストを表示 text_holder.markdown(buffer) except Exception as e: st.error(f"エラーが発生しました: {e}") -

Streamlitの実行

StreamlitはPythonだけでデータ分析アプリやAIアプリのフロントエンド(画面)を爆速で構築できるオープンソースのフレームワークです。

今回はAIエージェントの仕様を簡単に確認・実行するために使用します。(本番実装向きではありません)pip install streamlit streamlit run frontend.pyCodeSpacesのポップアップに従ってブラウザでアプリを開くか、ターミナルに表示されたURLにアクセスします。

-

動作確認

アプリのサイドバーに、ステップ4で控えたRuntime ARNを貼り付けます。

以下の質問をして、MCPClientの利用(AWSドキュメント検索)とステアリングが効いているか確認します。

ちゃんと危険と記述してくれていますね。

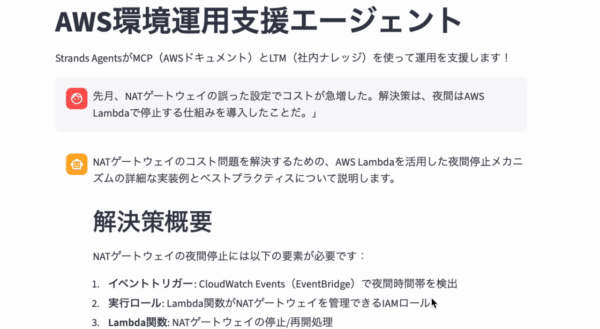

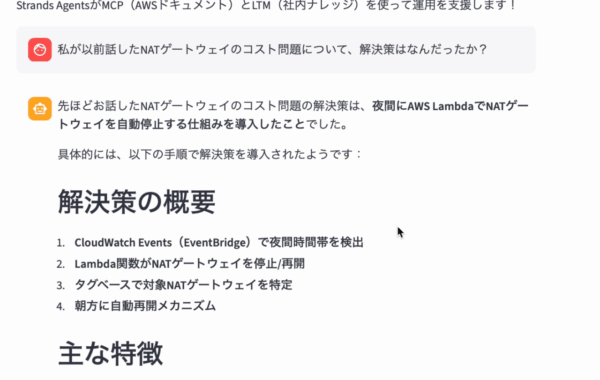

ステップ 6: エピソード記憶(LTM)へのナレッジの投入

デプロイ後、LTMに社内固有のナレッジを「記憶」させることで、提案されたLTMの役割(過去の障害対応検索)を実現します。

-

LTMにナレッジを投入

Streamlitのチャットで、具体的な過去の事例をエージェントに教え込みます。例: 「先月、NATゲートウェイの誤った設定でコストが急増した。解決策は、夜間はAWS Lambdaで停止する仕組みを導入したことだ。」

-

LTMの検索テスト

ナレッジ投入後、LTMが検索される質問をします。例: 「私が以前話したNATゲートウェイのコスト問題について、解決策はなんだったか?」

(LTMが有効になっていれば、過去のエピソードを踏まえた回答が得られるはずです。)

エピソード記憶がちゃんと実装できている事も確認できましたね。

これで、AWSの公式ドキュメントとナレッジの両方を活用し、ポリシーで制御された「AWS環境運用支援エージェント」が完成します。

所感・まとめ

開発経験はまだ浅いですが、メモリー機能を備えた簡易的なエージェントを構築することができました。

難しい言語での作業が少なく約1時間と短い時間で構築でき、今後の開発速度効率化にとても期待できました。

今後は環境操作などの機能を追加して、完全自動化を実現する「ローカル版Kiro」のような仕組みを作ってみたり、 これまではPythonで実装してきましたが、アップデートによりTypeScriptでも実装可能になったため、複数言語での開発にも挑戦してみたいなーって思います。

年末に向けてPCもお部屋も大掃除しなくてはです。

それでは皆さん良いお年を〜

本記事は TechHarmony Advent Calendar 2025 12/25付の記事です。 本記事は TechHarmony Advent Calendar 2025 12/25付の記事です。 |

こんにちは、SCSK木澤です。

12/1から続けてきた今年のアドベントカレンダーも、ついに今日でラストですね。

本日発信される記事で、合計25日間で33記事が発信されたかと思います。

年末の忙しいさなか、お読み頂いた皆様、発信いただいた寄稿者の方々ありがとうございました。

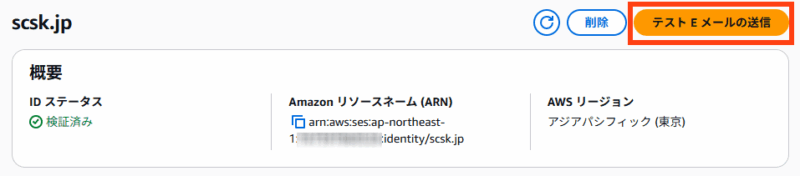

さて今年のアドベントカレンダー、私は他のテーマの検証が完了しませんでしたので、今年はAmazon SESの小ネタを発信したい思います。

メール誤送信事故の防止

私は10年ほど前まで、色々なお客様のシステム開発や保守を担当していました。

その中で、メール誤送信の事故を見かけたことがありました(大量ではないですが)

結構ありがちなのが、開発中のシステムやリリース後においては開発/検証環境など、本番環境以外からの誤送信で、テスト実施の際に不必要な宛先にメールが送信されてしまった、というケースです。

とはいえ、本番環境以外においてもシステムの動作検証・テストとして全くメールを出さない訳にもいかないことがあります。

そうした場合、メール中継をするMTA(postfix等)において、不必要な宛先への送信をブロックする設定を行うことが事故防止のため望ましく、そのような実装をよく行っていました。

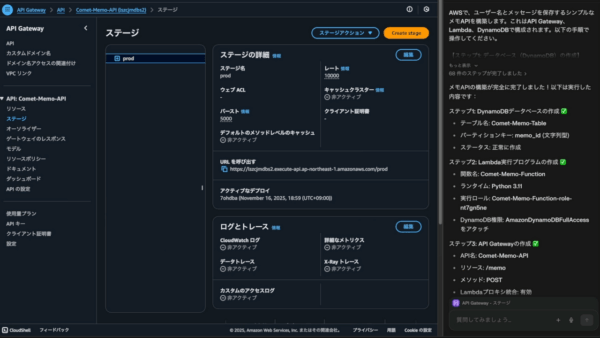

Amazon SESでの実装方法

AWSにおいてはAmazon SESを送信用のMTAとして用いることがベストプラクティスとなるかと思います。

Amazon SESにおいて送信の制限には、送信承認ポリシーによって行うことができます。

設定手順

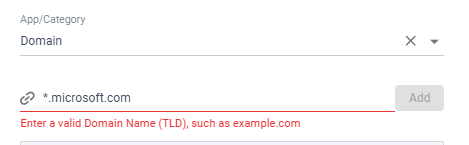

Amazon SESコンソール、設定内-IDをクリックし、検証済み(であることが前提ですが)IDの設定に入ります。

「承認」タブより承認ポリシーの作成に入ります。

今回はカスタムポリシーから作成しました。

ポリシードキュメントは以下のようにします(AWSアカウントはマスクしています)

この設定では、 [email protected] 宛のメールのみ送信を許可するように設定しています。

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "stmt1766585448102",

"Effect": "Deny",

"Principal": "*",

"Action": [

"ses:SendEmail",

"ses:SendRawEmail"

],

"Resource": "arn:aws:ses:ap-northeast-1:123456789012:identity/scsk.jp",

"Condition": {

"ForAnyValue:StringNotEquals": {

"ses:Recipients": "[email protected]"

}

}

}

]

}

本ポリシーを設定し、適用します。

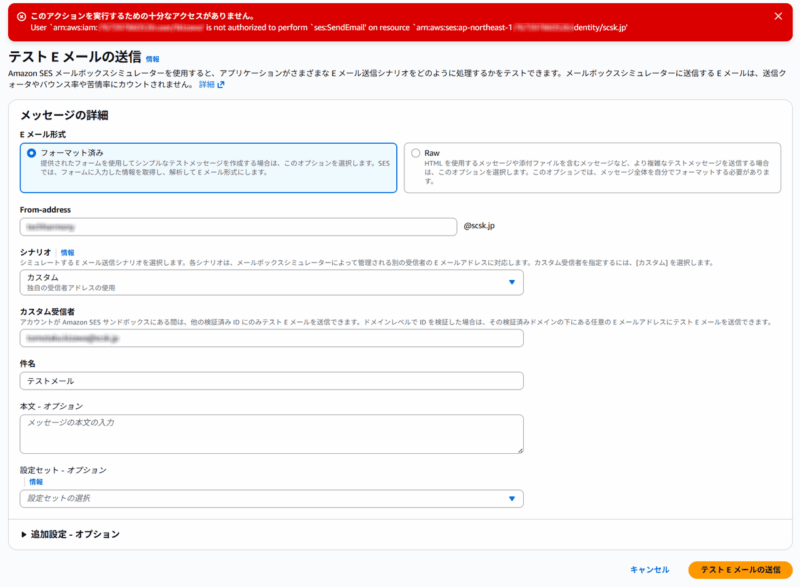

テスト

ID画面上の「テストEメールの送信」をクリックします。

許可されていない宛先を指定すると、下記のようにアクセス権がないというエラーが発生するはずです。

まとめ

今回はAmazon SESの小ネタをご紹介させていただきました。

開発/検証環境のメール環境においては、転ばぬ先の杖ということで必ず設定しておきましょう。

私は今年最後の投稿になるかもしれませんが、来年もTechHarmonyエンジニアブログ共、引き続きご愛顧の程よろしくお願いします。

皆様の2026年が良い年になりますように。今年もありがとうございました。

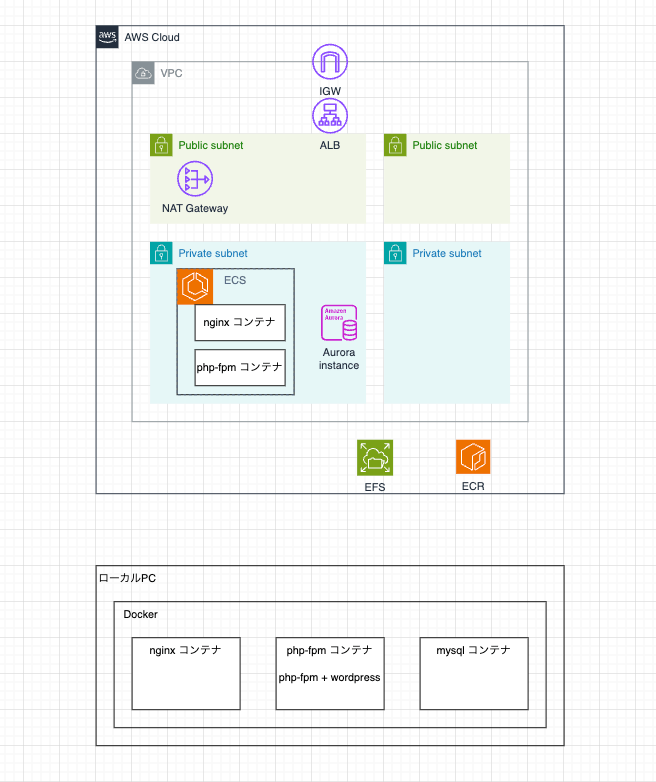

こんにちは。SCSKの末本です。

本記事では、AWSで構築しているシステムの保守運用をする中で発生した事象と、その解決策についてご紹介します。

発生した事象

今回のシステムは、Amazon Elastic Container Service(以下 ECS)を利用しており、1タスクで複数のコンテナを構成する環境です。

発生した事象は、AWS_ECS_TASK_PATCHING_RETIREMENT によって ECS のタスクが生まれ変わる際、クライアントからのアクセスに対して一時的に HTTP 503 エラーが返されたというものです。

AWS がメンテナンスやセキュリティアップデートを行うために、実行中のタスクを強制的に停止し、新しいタスクを起動するプロセス

なぜ 503エラー が発生したのか?

今回のシステム構成と、問題についてご説明します。

システム構成(1タスク内)

- tomcat コンテナ:

アプリケーションを実行するバックエンドとして動作するコンテナ - web(Apache)コンテナ:

フロントエンドとして動作し、ロードバランサーからのリクエストを受け取り、tomcat コンテナへ転送するコンテナ - log コンテナ:

ログ収集および転送を行うサイドカーコンテナ

AWSによる ECSパッチ適用時の流れ

AWS が ECSのパッチ適用をするため、ECSタスクの入替(新しいタスクを起動し、古いタスクを停止)が行われます。

この流れの中で、タスクがリクエストを受け付ける準備が整う前に、クライアントからアクセスされてしまうという問題が発生しました。

- 新しいタスクが起動を開始する。

- web(Apache)コンテナ、log コンテナが比較的早く起動する。

(この時点では、バックエンドの tomcat はまだアプリケーションレベルでの準備ができていない。) - ヘルスチェックを有効化したコンテナ(web・log)の状態をもって、タスク全体が早期に起動完了(RUNNING)と見なされる。

今回、tomcat コンテナにヘルスチェックが設定されていませんでした。

そのため tomcat のアプリケーション初期化時間にかかわらず、ヘルスチェックを有効化したコンテナ(web・Log)のヘルスステータスがすべて Healthy であることで、タスク全体が起動完了したと見なされました。ご参考:Amazon ECS タスクライフサイクル – Amazon Elastic Container Service

- タスクがターゲットグループに登録され、クライアントからアクセスが可能な状態になる。

- クライアントからのリクエストが web(Apache)に到達するが、バックエンドの tomcat コンテナはまだ起動途中。

結果として Apache はバックエンドに接続できず、クライアントに HTTP 503 Service Unavailable を返す。

今回の問題

今回の問題は、ロードバランサーのヘルスチェック(Apacheのポートをチェック)がOKでも、タスク内の コンテナ間の依存関係 が考慮されていなかったため、サービスが利用可能な状態になる前にアクセスされてしまったことです。

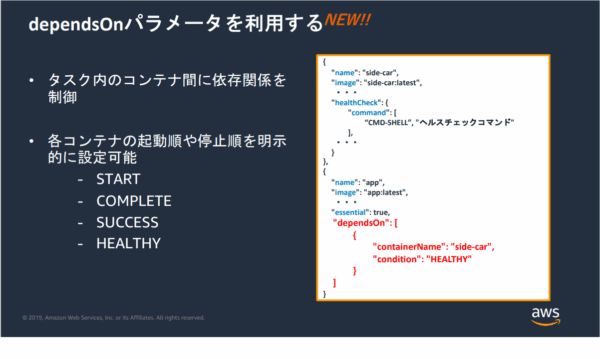

【回避策】ECSタスク定義の依存関係(dependsOn)の活用

この問題を解決するために、ECSタスク定義内の dependsOn プロパティとコンテナヘルスチェックを組み合わせて設定しました。

これにより、コンテナ間の起動順序と、次のコンテナが起動を開始するための 条件 を定義できます。

dependsOn パラメータの意味については以下の通りです。

| 設定値(条件) | 意味 |

|---|---|

| START | 依存するコンテナの起動開始後、実行 |

| COMPLETE | 依存コンテナの実行が完了(終了)後、実行 |

| SUCCESS | 依存コンテナの実行が正常終了後、実行(exit code:0) |

| HEALTHY | 依存コンテナに定義した healthcheck に合格後、実行 |

修正後のコンテナ依存関係の設計

- フロントエンド(web)が起動する前にバックエンド(tomcat)が完全に起動することで、リクエスト処理可能な状態とする。

- log コンテナがログファイルを正しく転送できるよう、各コンテナ起動後に log コンテナを起動させ、転送対象のファイルが存在しないというエラーの発生を防ぐ。

| コンテナ | 依存設定 | 設定値(条件) | 内容 |

|---|---|---|---|

| tomcat | (なし) | – | 依存関係なしのため、まず最初に起動する。 |

| web(Apache) | tomcat | HEALTHY | tomcat がアプリケーションレベルで完全に起動し、 サービス可能になるまで待機する。 |

| log | web(Apache) | HEALTHY | web コンテナのプロセス起動が確認されてから、 ログ転送を開始する。 |

設定内容

単に START(コンテナプロセスが起動)を待つだけでは、アプリケーションの初期化時間などを考慮できません。

この問題を解決するために、tomcat コンテナのタスク定義内に コンテナヘルスチェック を設定し、web(Apache)コンテナおよび log コンテナの dependsOn 設定で、HEALTHY 条件を指定しました。

// ECSタスク定義(コンテナ定義の抜粋イメージ)

"containerDefinitions": [

{

"name": "tomcat",

// ... 他の設定

// Tomcatがサービス可能であることを確認するコンテナヘルスチェック

"healthCheck": {

"command": [

"CMD-SHELL",

"curl -f http://localhost:8080/status || exit 1"

],

"interval": 30, // 30秒ごとにチェック

"retries": 3, // 3回失敗したらUNHEALTHY

"startPeriod": 10, // 起動直後の10秒間はヘルスチェックの失敗を無視(猶予期間)

"timeout": 6 // タイムアウトは6秒

}

},

{

"name": "web",

// ... 他の設定

// webコンテナはtomcatがHEALTHY(サービス可能)になるまで起動を待機

"dependsOn": [

{

"containerName": "tomcat",

"condition": "HEALTHY" // ここが重要!

}

]

},

{

"name": "log",

// ... 他の設定

// logコンテナはwebがHEALTHY(サービス可能)になるまで起動を待機

"dependsOn": [

{

"containerName": "web",

"condition": "HEALTHY" // ここが重要!

}

]

}

]

上記の設定により、今回の事象は解決し、ECSタスクのパッチ適用時に503エラーが出なくなりました。

今回の対応から学んだ3つの設計ポイント

1. ALBヘルスチェック ≠ サービス利用可能性

ロードバランサーのヘルスチェックは、外部から特定のポートが応答しているかを確認するもので、タスクへのトラフィックを流すかどうかを判断します。

しかしマルチコンテナタスクでは、「ポートが開いている」ことと「アプリケーションがリクエストを処理する準備ができている」ことは同義ではありません。

- ALBヘルスチェック:タスクへのトラフィック受付可否を判断

- コンテナヘルスチェック:タスク内のコンポーネントのサービス提供可否を判断

2. マルチコンテナ設計における依存関係の明示

ECSタスクの設計において、各コンテナの起動順序を意識して設計しなければ、今回のようなコンポーネント間の疎通エラーを招きます。

以下のように、役割に応じて依存関係を定義することが、システムの信頼性を高めると学びました。

- フロントエンドは、バックエンドの HEALTHY 状態を待つ。

- サイドカーコンテナは、メインコンテナの START または HEALTHY 状態に依存する。

3. startPeriod(起動猶予期間)の活用

Tomcat などの Javaアプリケーションは、プロセス起動からリクエスト処理可能になるまでに数十秒かかることがあります。

dependsOn パラメータで HEALTHY を使う場合、tomcat コンテナのヘルスチェック定義に startPeriod(起動猶予期間)を設定することで、コンテナが起動直後の不安定な状態で即座に失敗と見なされるのを防ぐことができます。

今回の対応で可用性を高めることができましたが、デメリットとして タスク全体の起動時間の増加 があげられます。

本システムでは、開発環境で検証した上で、起動時間の増加を許容する方針にしました。

まとめ

AWS ECSのタスク入れ替え時の503エラーは、一見するとシンプルなネットワークエラーに見えますが、その裏には「複数コンテナの非同期起動」という本質的な課題が隠れていました。

最後までお読みいただきありがとうございました!

]]>LifeKeeperの『困った』を『できた!』に変える!サポート事例から学ぶトラブルシューティング&再発防止策

こんにちは、SCSKの前田です。

いつも TechHarmony をご覧いただきありがとうございます。

LifeKeeperを導入し、システムの高可用性を実現する上で、アプリケーションリソースの保護は非常に重要な要素です。しかし、アプリケーションARKは、その特性ゆえに、設定のわずかな見落とし、予期せぬ通信障害、そしてバージョンアップによる仕様変更など、多岐にわたる要因で『困った』事態に直面することがありますよね。

本連載企画「LifeKeeper の『困った』を『できた!』に変える!サポート事例から学ぶトラブルシューティング&再発防止策」では、まさにそんな「なぜかアプリケーションが切り替わらない」「エラーが出て起動できない」といった、LifeKeeper運用の現場で実際に発生した問い合わせ事例を基に、トラブルの原因、究明プロセス、そして何よりも『再発防止策』に焦点を当てて深掘りしていきます。今回の第三弾では、アプリケーションARK特有の「落とし穴」に焦点を当て、その解決と再発防止の鍵を探ります。

はじめに

LifeKeeperの心臓部とも言えるアプリケーションリソースの保護は、システムの高可用性を実現する上で不可欠です。専用ARKから汎用ARKまで多岐にわたりますが、その複雑さゆえに設定ミスや連携アプリケーション側の要因で予期せぬトラブルが発生しがちです。 本記事では、LB Health Check、MySQL、IIS、そしてGeneric ARKを用いたJP1/Baseのリソース構築・運用で実際に発生したサポート事例を元に、アプリケーションARK特有の「落とし穴」を深掘りします。 通信障害、バージョン間の仕様変更、ホスト名の制約、スクリプトの依存性など、様々な角度から原因と対策を学ぶことで、アプリケーションの安定稼働と再発防止につなげるヒントを提供します。

その他の連載企画は以下のリンクからどうぞ!

【リソース起動・フェイルオーバー失敗の深層 #2】ファイルシステムの思わぬ落とし穴:エラーコードから原因を読み解く – TechHarmony

今回の「困った!」事例

ケース1:ロードバランサーとの連携トラブル – ヘルスプローブの落とし穴

lbhcリソース作成中にエラー(140251)が発生する、LB Health Checkリソース作成時のエラーについて

- 事象の概要: LifeKeeper for Windows環境でLB Health Checkリソース作成・起動時にエラーが発生し、リソース作成に失敗。ロードバランサーからの正常性プローブがLifeKeeper側で受け取れない状況に陥りました。

- 発生時の状況: LBHCリソース作成後のリソース起動でロードバランサーとの通信がタイムアウト(エラーコード140251)しました。Azure内部ロードバランサーからの通信は許可済みと認識されていたにも関わらず、プローブが到達しませんでした。また、LifeKeeperのホスト名に小文字が混在している環境でした。

- 原因究明のプロセス: 初期にはHC_TIMEOUTの調整やデバッグログ取得を試みましたが、デバッグログからも最終的にプローブを受け取れていない状況が判明。さらに、ホスト名に小文字が含まれることがLifeKeeper for Windowsの既知の不具合であり、リソース情報取得エラーの原因であることが明らかになりました。

- 判明した根本原因: 1. ロードバランサーからの正常性プローブがLifeKeeper側で受け取れていない通信経路上の問題、および 2. LifeKeeper for Windowsのホスト名が小文字混在であったことによるリソース情報取得エラーが複合的に発生していました。

ケース2:データベースARK特有の設定ミス – MySQLのパスワードとログパスの罠

MySQLリソース作成時のエラーについて

- 事象の概要: MySQLリソース作成時に「Invalid parameter value」エラーが発生し、さらにその後log-binのパスに関するエラーが発生。リソース作成が成功しませんでした。

- 発生時の状況: my.cnf内のMySQLユーザーパスワードに「$」が含まれており、ダブルクォーテーションで囲んでいましたがエラーが解消されませんでした。また、log-binパラメータがファイル名のみで指定されていました。既存システム(LifeKeeper v9.3.2)ではファイル名のみで動作していましたが、新システム(LifeKeeper v9.9.0)ではエラーとなりました。

- 原因究明のプロセス: サポートとのやり取りにより、パスワードの特殊文字(「$」)を正しく扱うためにはシングルクォーテーションで括る必要があること、およびlog-binのパスはLifeKeeper for Linux v9.6以降ではフルパス指定が必須になったことが判明しました。

- 判明した根本原因: 1. MySQLユーザーパスワードに特殊文字(「$」)が含まれる場合の記述ルール(シングルクォーテーションで括る)の不理解、および 2. LifeKeeper for Linuxのバージョンアップに伴うMySQL ARKの仕様変更(log-binのフルパス指定必須化)への追従不足が原因でした。

ケース3:WebサーバーARKの特性理解不足 – IISの拡張前処理スクリプト

IISリソース拡張前処理スクリプト実行時のエラーメッセージについて

- 事象の概要: IISリソース作成時の拡張前処理スクリプト実行中にエラーメッセージが発生しましたが、その後の拡張はエラーなく実行され、IISリソースの作成自体は完了しました。

- 発生時の状況: 既にボリュームリソースが拡張済みであったにも関わらず、IISリソースの拡張前処理スクリプト内で再度ボリューム拡張を試みていました。

- 原因究明のプロセス: サポートの確認により、このエラーは既にボリュームリソースが拡張されているため発生する、運用上問題のない情報メッセージであることが確認されました。

- 判明した根本原因: 拡張前処理スクリプトが、既に拡張済みのボリュームに対し再度拡張処理を行おうとしたため発生する、意図されたエラーメッセージであり、IISリソースの拡張自体には影響がありませんでした。

ケース4:Generic ARK利用時の注意点 – スクリプト依存とサポート範囲

Generic ARK リソース (JP1/Base)における quickCheck の仕組みについて

- 事象の概要: Generic ARK(JP1/Base)におけるquickCheckの動作について問い合わせ。ネットワークメンテナンスに伴う通信断の影響で、quickCheckが失敗しOSが再起動しました。

- 発生時の状況: quickCheckスクリプト内で名前解決を使用しており、通信断により名前解決ができずquickCheckが失敗したと推測されました。

- 原因究明のプロセス: 問い合わせたGeneric ARKがサポート対象外であることが判明し、お客様が作成したスクリプトの内容に依存するため、LifeKeeper製品としての詳細な案内はできませんでした。

- 判明した根本原因: サポート対象外のGeneric ARKを利用しており、スクリプトの内容(名前解決への依存)が起因する問題であったため、LifeKeeper製品としての根本原因は特定できず、スクリプト作成者による詳細確認が必要でした。

「再発させない!」ための対応策と学び

具体的な解決策:

- LB Health Checkリソース関連: ネットワークセキュリティグループ(NSG)やファイアウォールで、ILBのIPアドレスからのプローブ用ポートへの通信を確実に許可する。HC_TIMEOUTの設定値を環境に合わせて調整する。LifeKeeper for Windowsを導入するサーバーのホスト名は、すべて大文字で設定する。

- MySQLリソース関連: MySQLユーザーのパスワードに特殊文字(「$」など)を使用する場合は、必ず「’」(シングルクォーテーション)で文字列全体を括って設定する。my.cnf内のdatadir、log-bin、log-tcパラメータは、LifeKeeper for Linux v9.6以降では共有ディスク上の絶対パス(フルパス)で指定する。

- IISリソース関連: IISリソース作成時の拡張前処理スクリプト実行中に、既に拡張済みのボリュームに関するエラーメッセージが表示された場合、その後のIISリソース拡張が成功していれば、運用上問題ないメッセージとして認識する。

- Generic ARK関連: 利用するアプリケーションがLifeKeeperのサポート対象であることを事前に確認する。Generic ARKで利用するスクリプトは、作成者が動作内容(特に外部依存性)を詳細に把握し、デバッグログ出力やエラーハンドリングを適切に実装する。

再発防止策(チェックリスト形式):

- ARKのサポート範囲と互換性確認: 専用ARK利用時もGeneric ARK利用時も、対象アプリケーションとLifeKeeperのバージョンがサポートされているか、サポートマトリクスで事前に確認する。

- OS/LifeKeeperバージョンアップ時の仕様変更確認: OSやLifeKeeper本体のバージョンアップを行う際は、リリースノートやドキュメントを詳細に確認し、ARK固有の仕様変更(例: MySQL ARKのlog-binパス指定)がないか確認する。

- ARK固有の設定ファイル(例: my.cnf)の厳格な管理: アプリケーションARKが参照する設定ファイルは、LifeKeeperの要件(例: パスワードの記述ルール、パスの絶対指定)に沿って適切に設定・管理する。

- 通信経路とセキュリティ設定の徹底確認: ロードバランサーのヘルスプローブやアプリケーション間の通信など、LifeKeeperが監視・利用する通信経路について、ファイアウォールやネットワークセキュリティグループの設定を構築前に徹底的に確認し、必要なポートが解放されていることを保証する。

- 命名規則(ホスト名・ユーザー名など)の遵守: LifeKeeperが動作する環境では、ホスト名やユーザー名にLifeKeeperの制約(例: Windows版でのホスト名の大文字制約)がないか事前に確認し、命名規則を遵守する。

- Generic ARK利用時のスクリプト詳細把握: Generic ARKを利用する場合は、スクリプトの作成者が動作内容(特に外部依存性、名前解決など)を詳細に把握し、デバッグログ出力やエラーハンドリングを適切に実装する。

- LifeKeeperログの日常的な監視とエラーコード理解: LifeKeeperログに記録されるエラーメッセージやエラーコードの意味を正確に理解し、日常的に監視することで異常を早期に検知・対処できる体制を整える。

ベストプラクティス:

- 設計段階での詳細な要件定義: アプリケーションリソースを保護する際は、LifeKeeperの要件、アプリケーションの要件、ネットワークの要件を詳細に定義し、設計書に落とし込む。特に通信要件や設定ファイルのパス、パスワードポリシーは入念に検討する。

- 公式ドキュメントの積極的活用: 各ARKの管理ガイド、処理概要、リリースノート、動作環境リストなど、SIOSが提供する最新の公式ドキュメントを常に参照し、推奨設定や既知の制約を把握する。

- 検証環境での徹底的なテスト: OSアップデート、LifeKeeperバージョンアップ、アプリケーション設定変更など、システム構成に影響を与える変更は、必ず本番適用前に検証環境でLifeKeeperリソースを含むシステム全体の動作テストを実施する。

- 運用フローとチェックリストの確立: リソース作成、変更、OSアップデートなどの主要な運用タスクについて、具体的な手順と確認項目を記した運用フローとチェックリストを確立し、ヒューマンエラーを防止する。

- サポート活用と情報共有: 疑問点やエラー発生時には、積極的にSIOSサポートに問い合わせ、得られた知見はチーム内で共有しナレッジとして蓄積する。

まとめ

本記事では、LB Health Check、MySQL、IIS、Generic ARKといったアプリケーションリソースに関連する様々なトラブル事例を取り上げました。

これらの事例から、アプリケーションARKの安定稼働には、LifeKeeper本体やARKの仕様への深い理解に加え、連携するOSやアプリケーションの設定、そして基盤となるネットワーク通信環境の綿密な確認が不可欠であることが明らかになりました。

特に、OSやLifeKeeperのバージョンアップに伴う仕様変更への追従、設定ファイル記述ルールへの注意、そしてGeneric ARK利用時のスクリプト内容への詳細な把握が、トラブルを未然に防ぐ鍵となります。 日々の運用でこれらの点を意識し、公式ドキュメントの活用と検証を徹底することで、「困った!」を「できた!」に変え、より堅牢なクラスタ環境を構築・維持できるでしょう。

次回予告

次回の連載では、「クラスタの予期せぬ停止を防ぐ!ネットワーク構成のトラブルシューティング」と題し、LifeKeeper環境におけるネットワーク関連のトラブル事例とその解決策、安定稼働のためのベストプラクティスを深掘りします。どうぞご期待ください!

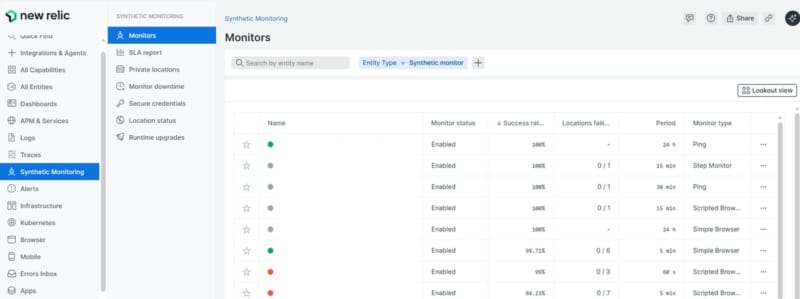

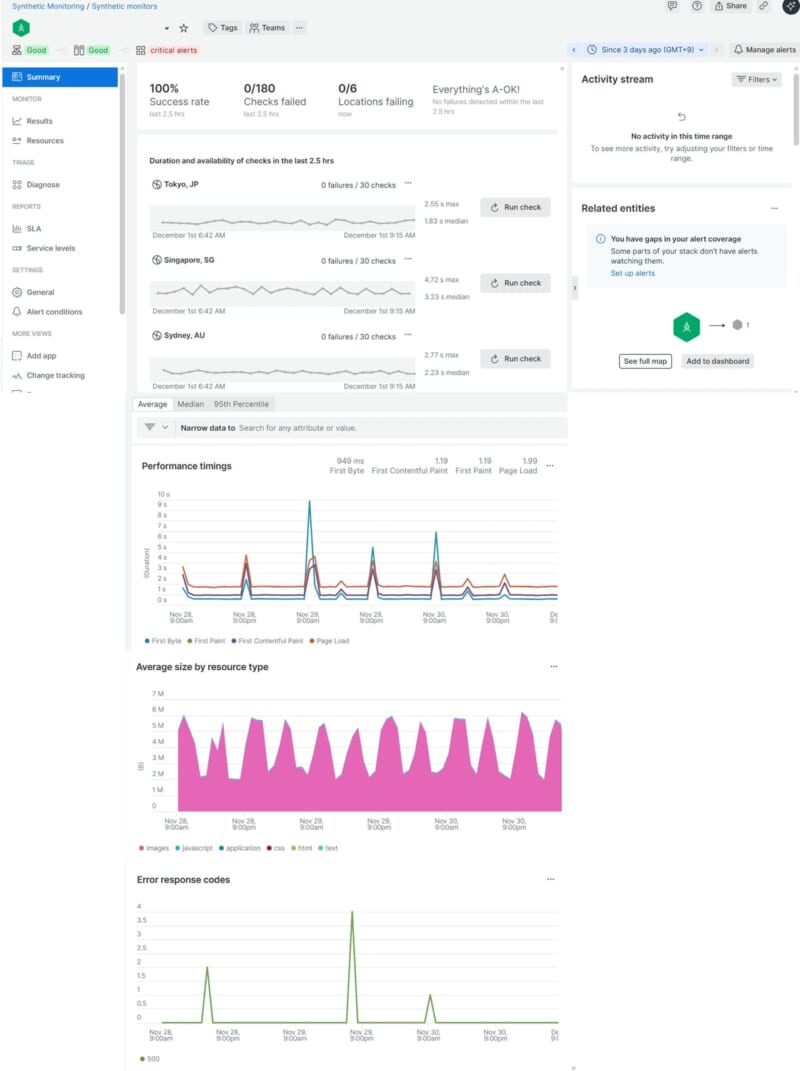

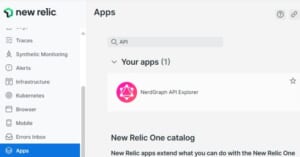

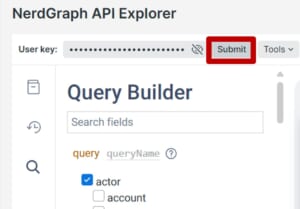

]]>こんにちは。SCSKの井上です。

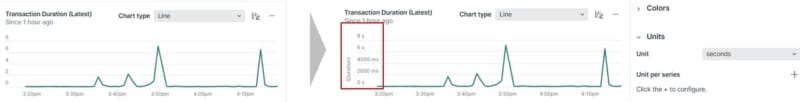

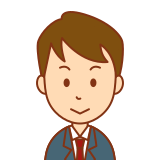

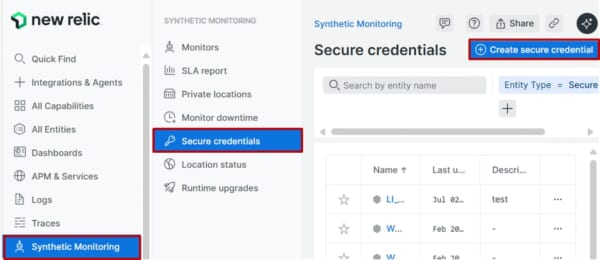

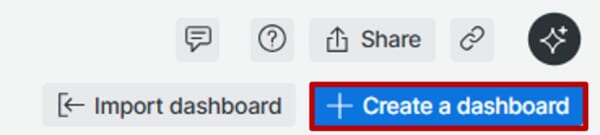

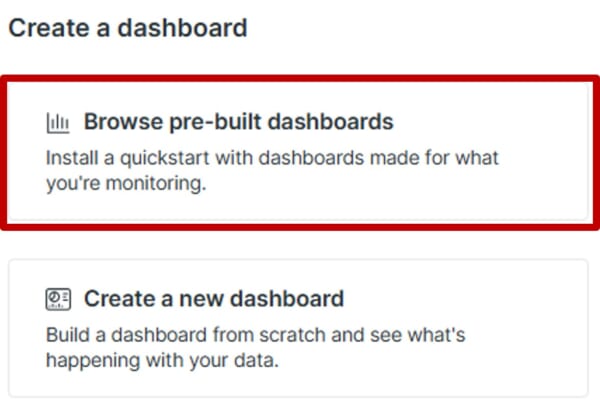

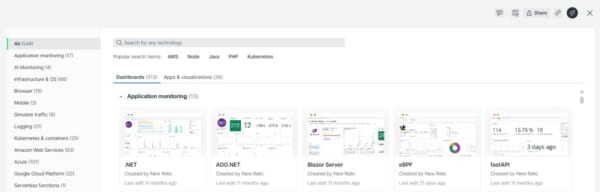

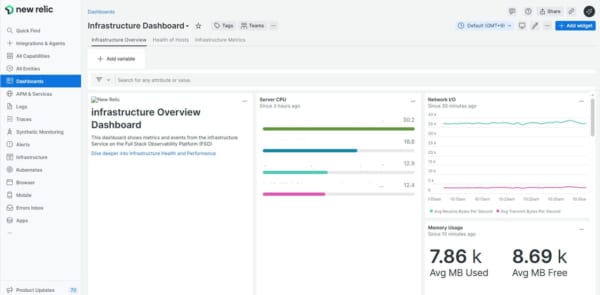

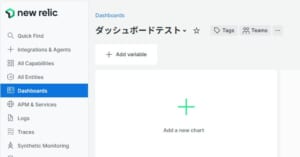

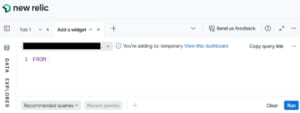

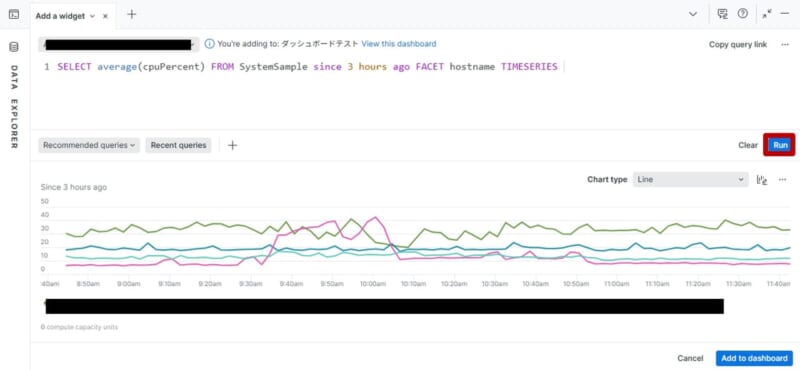

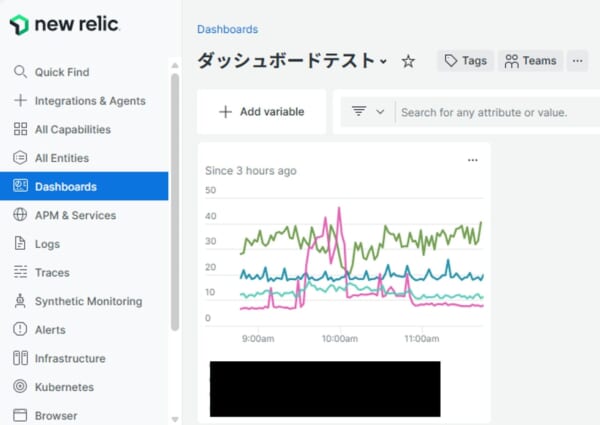

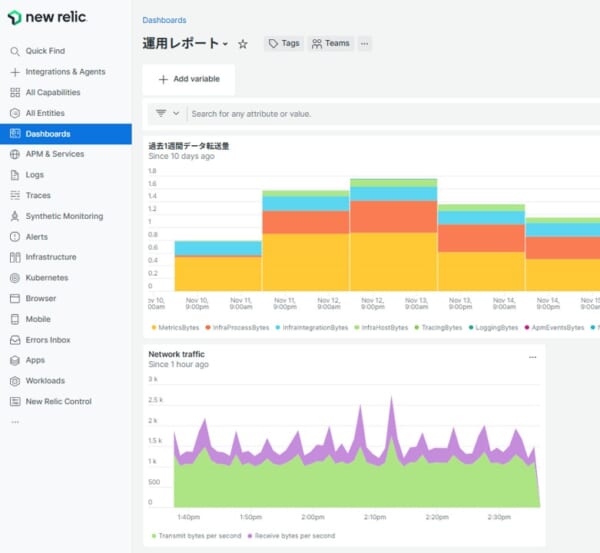

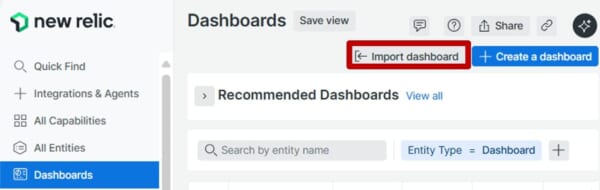

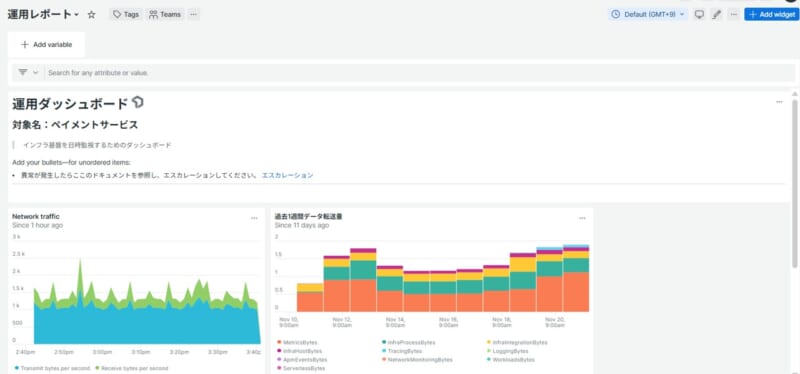

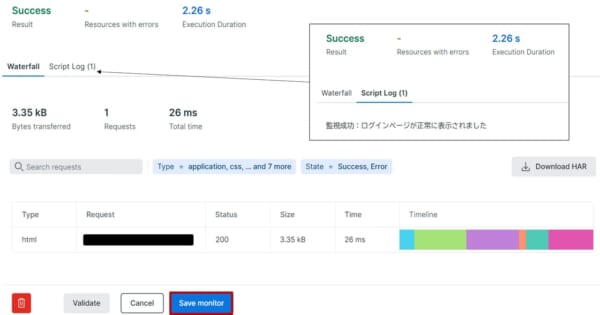

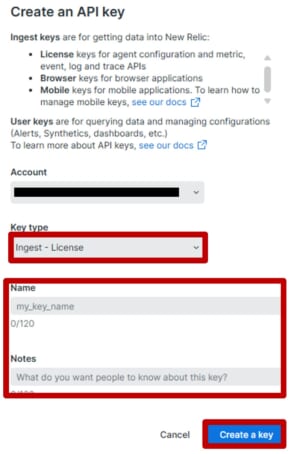

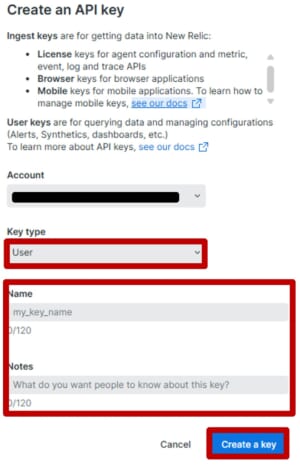

運用効率化を実現するためには、収集したデータを適切に可視化し、現状を一目で把握できる仕組みが重要です。New Relicでは、テンプレートを使って簡単にダッシュボードを構築できます。この記事で、New Relicで収集したデータの可視化方法を習得し、運用効率化につながる一助になれば幸いです。

はじめに

ダッシュボード機能を活用し、CPU使用率やメモリ、レスポンスタイム、エラー率などの指標をグラフ化し、折れ線グラフで時系列の変化を表示すれば、リアルタイム監視に役立ちます。また、しきい値を設定し、異常値を色分けすることで、問題の早期発見が可能です。NRQL(New Relic Query Language)を用いることで、柔軟なカスタムチャートも作成できます。収集したデータを関連付けてオブザーバビリティを実現するためにも、ダッシュボードを使って可視化することが運用効率化の鍵になってきます。どんな作り方があるのか、どのように活用していけばよいかを解説してきます。

ダッシュボードを作る目的

目的が曖昧なまま作成されたダッシュボードは、利用されずに陳腐化してしまいます。そのため、ダッシュボードを作成する際には、「誰が」「何を判断するためのものか」を明確にすることが不可欠です。たとえば、運用担当者であれば障害検知やリソース使用率の監視、マネージャー層であればコスト管理やSLA遵守、経営層であればビジネスインパクトの確認といったように、利用者ごとに必要な指標は異なります。

| 利用者 | 判断すること | 指標例 |

| 運用担当者 | サーバ・アプリが正常稼働しているか 障害や異常の有無 |

CPU・メモリ使用率 レスポンスタイム エラーレート アラート件数 |

| マネージャー層 | SLA遵守状況 コストが予算内か |

稼働率 クラウド利用料 リソース消費量 |

| 経営層 | 技術的問題のビジネス影響 売上やUXへのインパクト |

トランザクション数 国別、曜日ごとのアクセス数 |

| 開発チーム | 新機能リリース後のパフォーマンス ボトルネック特定 |

APIレスポンスタイム DBクエリ遅延 エラーログ |

ダッシュボード(チャート)の種類

エリアチャートやラインチャートのような時系列可視化、バーやパイチャートによるカテゴリー比較、ビルボードやブレットによる重要KPIの強調表示など、New Relicのダッシュボードではデータの性質に応じて最適な視覚化手法を選ぶことができます。

| チャートタイプ | 用途 | 具体例 |

| Area | 単一属性の時系列推移を可視化 | ・トラフィック量の増減 ・レスポンス量の変化 |

| Bar | カテゴリ間の合計値を比較 | ・API別リクエスト数比較 ・エラー種別件数の比較 |

| Billboard | 単一の重要指標(KPI)を強調表示 | ・エラー率のモニタリング ・レスポンスタイムの重要KPI表示 |

| Bullet | 実績値と目標値(Limit)の比較 | ・SLA達成状況の表示 ・KPIが目標にどれほど近いか確認 |

| Funnel | 連続するプロセスの減少を表示 | ・ユーザー遷移(訪問→購入) ・処理ステップの離脱分析 |

| Heatmap | 値の分布・密度を色で可視化 | ・遅延の集中箇所の特定 ・ログ頻度やデータ密度の確認 |

| Histogram | データの分布(どの範囲が多いか)を把握 | ・レスポンス時間の偏り分析 ・負荷データの分布確認 |

| JSON | クエリ結果を JSON のまま表示 | ・開発者向けの詳細ビュー |

| Line | 複数系列の時系列推移の比較 | ・CPU/メモリの変動確認 ・エラー件数の推移分析 |

| Pie | 全体に対する割合を表示 | ・エラー種別割合 ・ユーザーOS/デバイス割合 |

| Stacked Bar | 合計値と内訳を同時に表示 | ・サービス別トラフィック内訳 ・エラー構成比+総量 |

| Table | データを一覧形式で表示 | ・FACET結果のランキング ・詳細データ比較、ログ確認 |

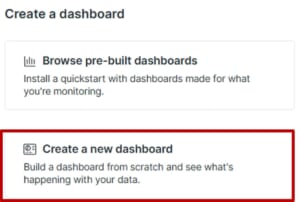

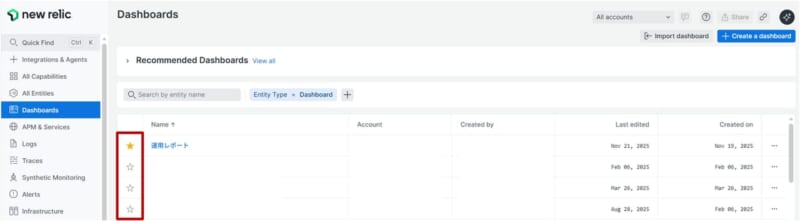

ダッシュボードの作り方

ダッシュボードは主に次の3つの方法で作成できます。それぞれの方法について解説します。New Relicを使い始めた場合は、テンプレートから作成するか、既存のメトリクスデータを参考にNRQLの構成を理解した上で、カスタムダッシュボードを作成すると理解を深められます。

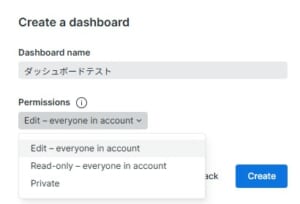

ダッシュボードを作り始める前に、ダッシュボードの編集や公開操作の権限の種類について確認します。以下、3つの種類が用意されています。編集は自分自身だけに限定したい、ダッシュボードが作成途中のため、完成してから公開したいなどの場合に、適切に選択することができます。

| Permissions設定 | 説明 |

| Edit – everyone in account | アカウント内のすべてのユーザーがダッシュボードを編集できます。 |

| Read-only – everyone in account | アカウント内のすべてのユーザーがダッシュボードを閲覧のみできます。編集や削除は作成した自身のみに制限されます。 |

| Private | ダッシュボードは作成者のみが閲覧・編集可能です。完全に非公開の状態です。 |

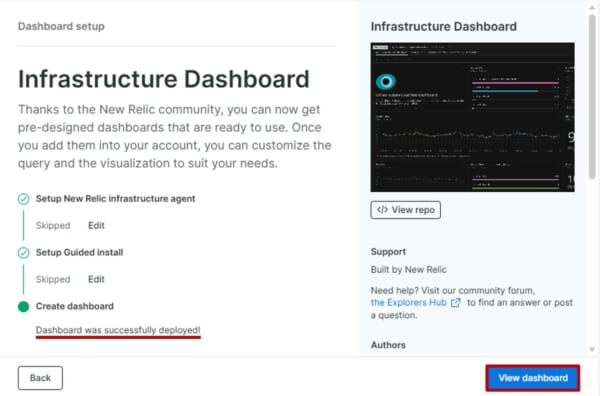

テンプレートから作成

既存テンプレート100種類以上から目的に合ったダッシュボードを簡単に作成できます。ダッシュボードを作成する際は、New Relicでデータ収集ができている状態から作成することを推奨します。ここでは、すでにInfrastructureエージェントが導入済の状態で手順を進めます。

カスタムダッシュボードから作成

既存テンプレートから作成したダッシュボードでは、不要なチャートが含まれたり、NRQLの修正箇所が分からずメンテナンスが難しい場合があります。一から作成すれば、必要な情報だけを表示でき、メンテナンス性も向上します。

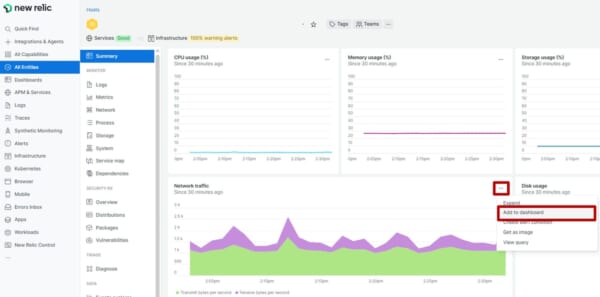

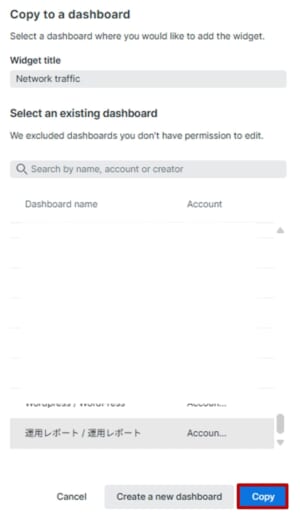

表示されているチャートからダッシュボードを作成

既にホスト単位やサービス単位で表示されているチャートを個別に追加することで、必要なチャートだけを選択してダッシュボードに組み込むことができます。ダッシュボードを軽量に保ちながら段階的に構築でき、構成を確認しながら進められるため、完成イメージを把握しやすくなります。

ダッシュボードの編集

ダッシュボードを作成した後、運用効率化のために構成を変更することがあります。ここでは、どのような編集方法があるのか、一例を解説します。ダッシュボードの一覧の横にある★をクリックするとリストのトップに表示されます。よく使うダッシュボードがある場合は、実施を推奨します。お気に入り機能はユーザー個人の設定のため、他のユーザには反映されません。

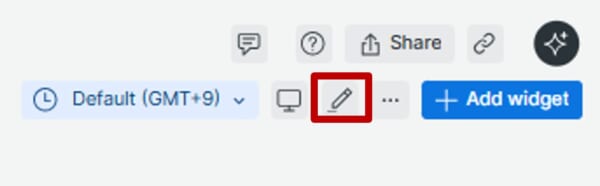

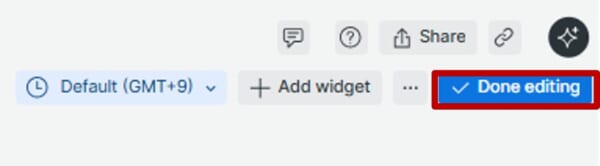

ダッシュボードの編集方法

ダッシュボードの編集は編集したいダッシュボード画面の右上のアイコンから実施します。鉛筆マーク中は編集モードとなり、表示するチャートの幅の変更や表示順の変更などができます。

| ダッシュボードの編集開始は「鉛筆マーク」 | ダッシュボードの編集完了は「Done editing」 |

|

|

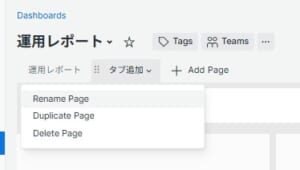

タブの構成

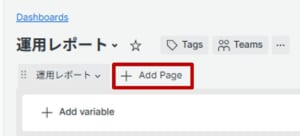

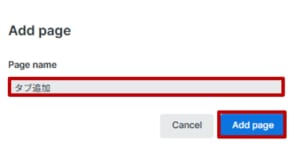

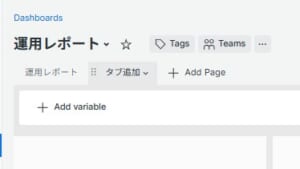

タブを使ってチャートを分けることで、表示するデータ量を調整でき、読み込み速度とともに見やすさが向上します。また、「サービス別」「環境別」「機能別」など、目的に応じてタブを構成することで、必要な情報へ簡単にアクセスできるようになります。

| 1.編集したいダッシュボードの右上の「鉛筆マーク」をクリックします。 | 2.鉛筆マークをクリック後、「Add Page」をクリックします。 | 3.タブの名前を入力し、「Add page」をクリックします。 |

|

|

|

| 4.タブが追加されます。 | 5.タブの名前や複製、削除はタブをクリックして行います。 | 【補足】編集終了後は、「Done editing」をクリックします。 |

|

|

|

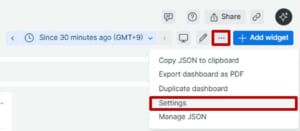

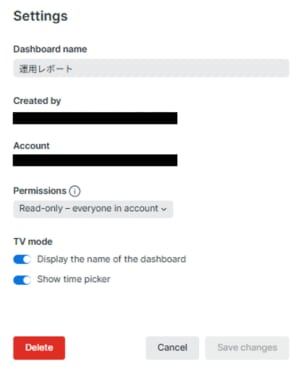

ダッシュボードの名前変更と編集権限

ダッシュボードの名前を変更したい場合や、完成してからダッシュボードをチーム内に公開したい、作成者以外ダッシュボードの編集をさせたくないなどの運用が発生した場合は、以下の手順にて変更ができます。

| 1.対象のダッシュボードを開き、右上「・・・」から「Settings」をクリックします。 | 2.名前の変更やダッシュボードの編集公開の変更ができます。 |

|

|

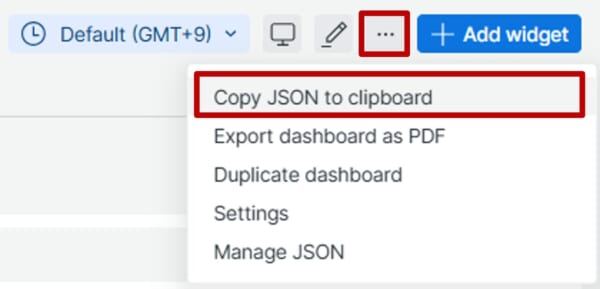

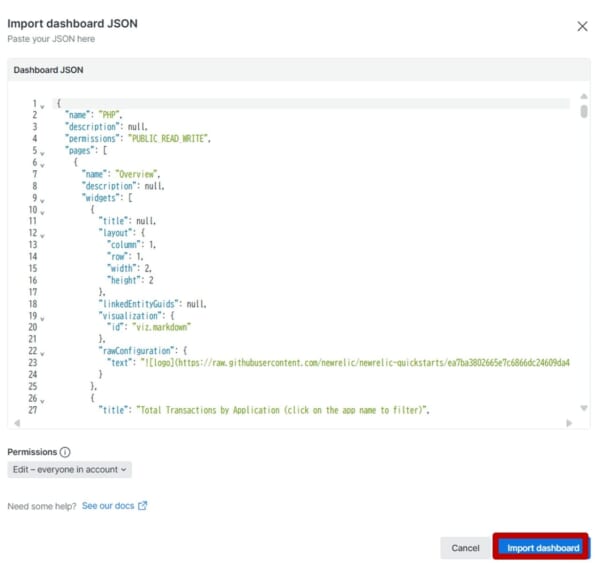

ダッシュボードのエクスポート・インポート

ダッシュボードをエクスポートして保存し、後で復元したり、よく使うメトリクスやウィジェット構成をJSON化してテンプレートとして他のプロジェクトに展開できます。JSONの他に、運用レポートとしてダッシュボードをPDFで出力したり、テーブル形式であればCSVとしても出力できます。ここではJSONのエクスポートとインポートを例に解説します。

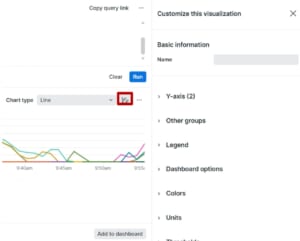

ダッシュボードのビジュアルを促進させるオプション

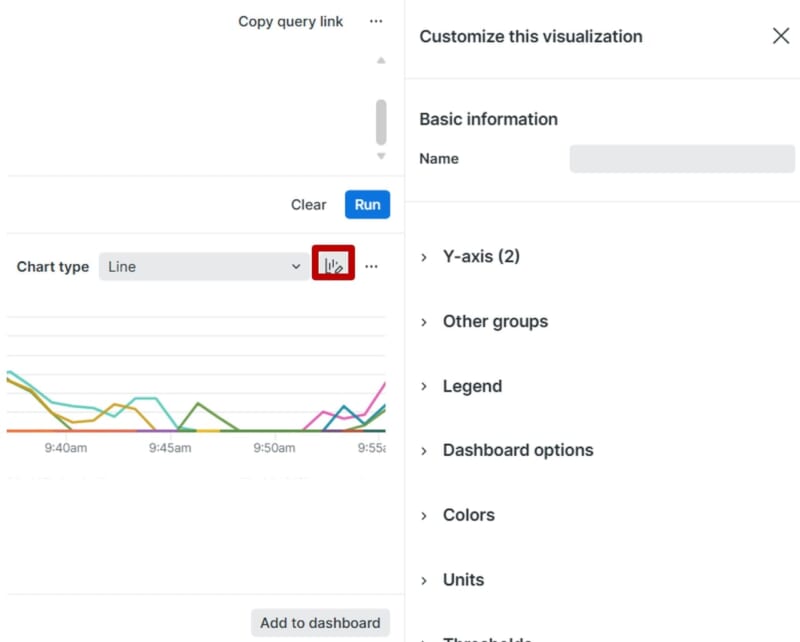

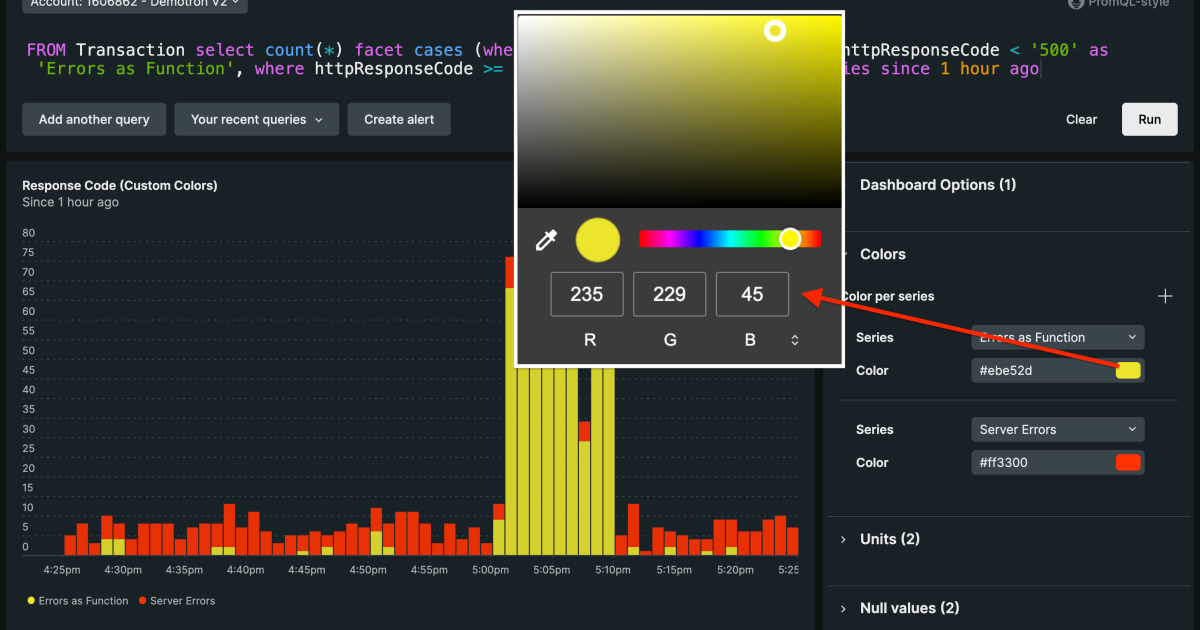

New Relicではダッシュボードを視覚的にわかりやすく表示させるためのいくつかのオプション(Customize this visualization)が用意されています。これらのオプションを使って、運用効率化につながるダッシュボードをカスタマイズすることができます。Chart typeでグラフの種類も変更することができます。デフォルトで表示されたグラフが見づらい場合は、他のグラフの種類も表示することもできます。グラフの種類によって使えるオプションは異なります。

| 項目名 | 説明 | 実際の画面例・使用例 |

| Y-axis (2) | 異なる単位のデータ比較を同じチャートに表示 | 相関分析をする際に利用。負荷とパフォーマンス、エラーとトラフィックなど。 |

| Other groups | 表示しきれないグループをまとめる | サーバー別にレスポンスタイムをグループ化し、色分け表示。 |

| Legend | 凡例の表示・非表示 | チャート右下に「正常」「警告」「エラー」などの色ラベルが表示される。 |

| Dashboard options | 時間の固定 | ダッシュボード上部にあるタイムピッカーで選択された時間範囲を無視し、チャートごとに固定の時間範囲を設定。 |

| Colors | チャートの色をカスタマイズ | エラー率が高いと赤、正常なら緑など、しきい値に応じて色が変化。 |

| Units | 数値の単位を設定 | レスポンスタイムを「ms」、データ転送量を「MB」で表示。 |

| Thresholds | しきい値を設定して色やアラートを変更 | エラー率が5%を超えるとチャートが赤くなる設定等。 |

| Markers | 特定のイベントを示す縦線などを追加 | デプロイ日時に縦線を追加し、パフォーマンス変化を視覚的に確認。 |

| Null values | nullデータの表示方法を設定 | データがない時間帯をグレーで表示、またはゼロとして扱う設定。 |

| Tooltip | カーソルを合わせたときの詳細表示 | 「2025/12/01 14:00 – CPU使用率:75%」などのポップアップが表示される。 |

| Initial sorting | テーブルがどの列を基準に、どんな順番で並ぶか を指定する設定 | テーブルを開いた瞬間に、確認したい順序で見たい場合。 |

| Billboard settings | 数値を大きく強調する | KPI や重要なメトリクスに使う場合など。 |

Y-axis (2):異なるスケールのデータを同じチャートに表示

Y-axis(2)で単位が違うデータを一つのグラフでそれぞれ軸の単位を変更することでわかりやすく表示します。

|

Other groups:表示しきれないグループをまとめる

Other groupsで表示しきれない下位グループをまとめて1つのグループとして表示します。

|

Legend:凡例の表示・非表示

Legendで凡例の表示非表示を設定することができます。

|

Dashboard options:時間の固定

Dashboard options(Ignore time picker)で NRQLで指定した期間 または ダッシュボードのデフォルト期間のみに固定します。TVモード(画面右上の鉛筆マークの横)で常時表示させる際に組み合わせて使用するケースを想定しています。

|

Colors:チャートの色をカスタマイズ

Colorsで指定した色に変えることができます。Consistentは常に色は固定、Dynamicは値の変化(傾向)によって色が変わる設定になります。

|

Units:数値の単位を設定

Unitsで軸の単位を表示することができます。

|

Thresholds:しきい値を設定して色やアラートを変更

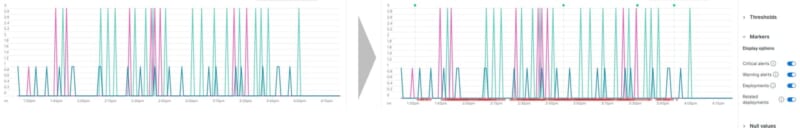

Thresholdsを用いることで、閾値設定したWarningやCriticalがどのラインに達した場合かを視覚的にわかるようになります。

|

Markers:特定のイベントを示す縦線などを追加

Markersでデプロイや変更箇所のイベントがあった時間帯を示すことができます。

Null values:nullデータの表示方法を設定

Null valuesでデータが欠損している場合のグラフの表示の仕方を調整することができます。

|

| オプション | 意味 | 使用シーン(活用例) |

| Leave as null (default) | データが存在しない部分は空白のままにする(初期設定) | 一時的なデータ欠損を視覚的に確認したいとき。例:ネットワーク障害の影響を見たい場合。 |

| Remove | Null値のデータポイントを完全に除外する | 欠損データが分析に不要な場合。例:平均値計算に影響を与えたくないとき。 |

| Preserve the last value | 最後の有効な値を保持し、Null部分に適用する | データが途切れても継続的な傾向を見たいとき。例:CPU使用率が安定しているかを確認したい場合。 |

| Transform into 0 | Null値を「0」として扱う | 欠損をゼロとして扱うことで、チャートの連続性を保ちたいとき。例:トラフィックが完全に停止したことを示したい場合。 |

Tooltip:カーソルを合わせたときの詳細表示

グラフ内のエンティティが多い際に、どのエンティティを指しているのかをカーソルを合わせることでわかるようになります。

Initial sorting:テーブル表示の順序設定

初めから並び順を固定したい場合は、このオプションを使います。テーブルのカラム名をクリックすることで都度順序の並び替えも可能です。

|

Billboard settings:数字の見せ方の設定

数字を強調させるために配置や大きさなどを設定することができます。URLを記載することで、チャートをクリック後に、該当のURLへアクセスすることも可能です。

|

| 項目 | 意味 |

| Display mode | 値やラベルの表示方式を選ぶ(Auto, Value only, Label only 等) |

| Alignment | テキストの配置 |

| Value size | 数値の文字サイズ |

| Label size | ラベルの文字サイズ |

| Columns amount | ビルボード表示の横幅(並べる列数の調整) |

| Title | リンクの表示名 |

| Url | リンク先 URL |

| Open in a new tab | 新しいタブで開くかどうか |

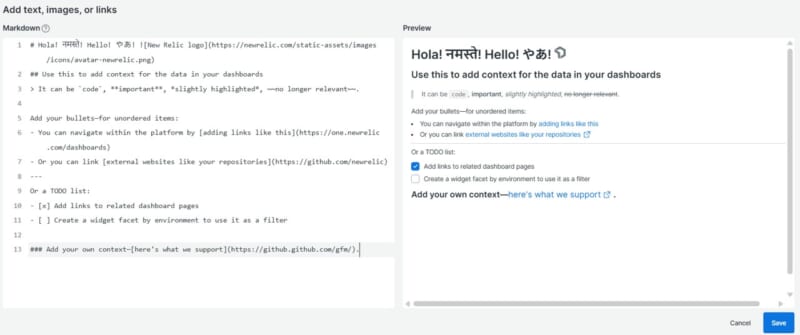

Markdownを使った運用効率化

作成したダッシュボードの見方や問題が発生した際のエスカレーション手順リンクなどの情報をダッシュボード内に表示することができます。必要な判断材料や対応手順を一元的に確認でき、トラブル発生時の対応スピード向上に貢献できます。また、ダッシュボードに簡単な操作ガイドやFAQを表示することで、新しいメンバーでも迷わずダッシュボードを確認することができます。作成して形骸化させないためにも、本機能を使って運用効率化を促進していきたいですね。

ダッシュボードの設計ステップ

ダッシュボードを作成する際の基本の考え方が整理されています。扱う指標を選定し目的に沿った情報配置を計画し、次に内容を一目で状況が理解できるようにレイアウトへ落とし込みます。そして、適切なチャート選択や文脈づけ(ラベル・単位・比較軸の明確化)を行い、情報の流れが変化 → 理由 → 行動として読み解けるように仕上げるプロセスが示されています。

| Step | 内容 | 目的 / 要点 |

| 1. 目的と質問の明確化 | ダッシュボードで答えるべきビジネス質問を定義する | 何を判断するための画面か?を明確にすることで、情報過多を防ぐ |

| 2. KPIと必要データの選定 | 目的に直結する少数の指標を選ぶ | データは収集→整形→モデリング→変換→可視化で準備する |

| 3. ストーリーライン設計 | 現状 → 変化 → 要因 → アクションの流れを組む | 何が起きたかを短いストーリーとして理解させる |

| 4. 図表(チャート)選定 | トレンド、比較、構成比など目的に合う可視化を選ぶ | 折れ線=トレンド、棒=比較、円/ドーナツ=構成比など |

| 5. レイアウト設計 | 視線の動きに合わせて情報を配置する | 上:要点、中央:変化、下:詳細/原因。1画面で把握できる構成にする |

| 6. ラベル・単位・文脈の明確化 | タイトル・単位・比較軸を明確にする | 誤解を防ぎ、意図を瞬時に伝えるために重要 |

| 7. ユーザーテストと改善 | 実際の利用者に見てもらい改善する(プロトタイピング) | ユーザー理解と反復改善が成功の鍵。多くの失敗は会話不足が原因 |

| 8. 継続的メンテナンス | KPI見直し、データ更新、自動化などの運用改善 | ダッシュボードは作って終わりではなく継続的に最適化する |

ダッシュボードの活用例

ダッシュボードを作成し、チーム間で共通の指標を共有することで、意思決定のスピードが向上します。ダッシュボードを確認して、実際にどうしなければらないのか、行動につながる設計を行い、継続的に改善することで、運用効率に貢献することができます。たとえばダッシュボードを作成を作成することで以下のような活用ができます。

- リアルタイム監視 :フロントエンド、バックエンドの状態をリアルタイムで確認

- 異常検知とアラート :しきい値を設定し、異常が発生した際に通知や問題の早期発見とダウンタイムの防止

- トレンド分析 :過去のデータを基にパフォーマンスの傾向、キャパシティの改善検討

- チーム間の情報共有 :カスタムダッシュボードを作成し、開発・運用・ビジネスチームで共有

- ビジネスインパクトの把握 :システムパフォーマンスが売上やユーザー体験にどう影響するかを可視化

様々な視点からダッシュボードを作成できますが、ここでは以下の視点に基づいて目的と指標を整理しました。

| 視点 | 目的 | 主な指標 |

| インフラ | サーバ・クラウドリソースの監視 | CPU使用率、メモリ使用率、ディスクI/O、ネットワーク帯域、ホスト稼働率 |

| アプリ | ユーザー体験可視化、ボトルネック特定 | Apdexスコア、平均レスポンスタイム、エラー率、外部サービス呼び出し時間(API) |

| コスト | クラウド利用料やリソース消費の最適化 | クラウドサービス別コスト、データ転送量、New Relic有償アカウント数 |

| セキュリティ | 不正アクセス検知や脆弱性管理 | ログイン失敗回数、異常IP、セキュリティ関連アラート件数、CVE件数、 |

| ビジネス | 意思決定支援 | トランザクション数、ユーザーセッション数、曜日ごとのページ訪問数 |

さいごに

2025年最後の記事は、New Relicに送信したデータをダッシュボードでどのように可視化し、運用に活かすか、設計の考え方も含めて紹介しました。ダッシュボードとNRQLを使いこなすことで、監視だけでなく、トレンド分析や異常検知、ビジネス指標の把握など、データ活用の幅が大きく広がります。この記事が、効率的な運用や意思決定のスピード向上に向けた第一歩となり、今後の改善や最適化に役立つ一助になれば幸いです。

SCSKはNew Relicのライセンス販売だけではなく、導入から導入後のサポートまで伴走的に導入支援を実施しています。くわしくは以下をご参照のほどよろしくお願いいたします。

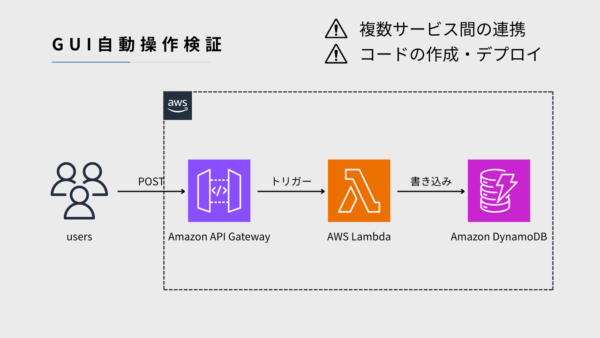

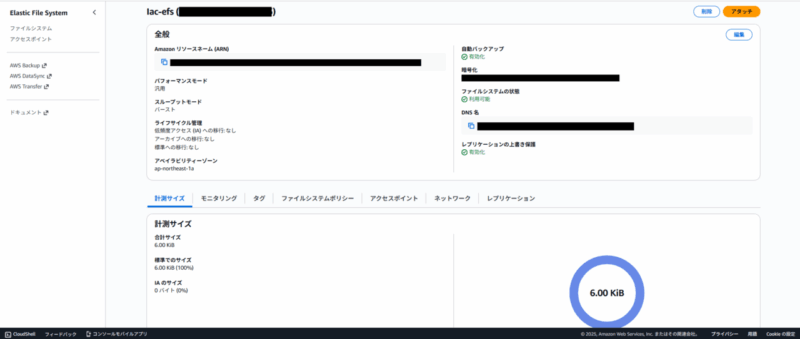

]]>前回の記事では、取り組みの背景や概要をご紹介しました。今回は、ツールを開発するにあたり検討した要件定義についてお話しします。

業務要件(システム要件)

今回のツールは、AWS環境の設計・構築に関わるメンバーが、構築フェーズ完了後にパラメータシートを効率的に作成することを目的としています。従来は、AWSコンソールを開き、設定値を目視で確認しながらExcelに転記するという作業が必要でしたが、この工程は非常に時間がかかり、ヒューマンエラーのリスクも高いものでした。

そこで、要件定義では「誰が」「どのような場面で」「どのような目的で」このツールを使うのかを明確化しました。

- Who(だれが)

主な利用者は、当部に所属するインフラエンジニアやクラウド構築担当者です。特に、AWSの設計・構築を担当するメンバーが中心となりますが、専門的なスキルを持たないメンバーでも簡単に操作できることを重視しました。将来的には、運用担当者や品質管理チームなど、幅広い部門での利用も想定しています。 - When(いつ)

ツールの利用タイミングは、AWS環境の構築フェーズが完了した後です。構築手法は問いません。CloudFormationやCDKなどのIaCを使った場合でも、コンソールから手動で構築した場合でも、同じように利用できることを目指しました。これにより、プロジェクトの規模や構築方法に依存せず、標準化されたパラメータシートを作成できます。 - Where(どこで)

基本的には社内ネットワークやローカルPCで利用します。セキュリティを考慮し、外部環境への依存を避ける設計としました。将来的には、社内ポータルやクラウド上での利用も検討しています。 - What(なにを)

ツールを使って、AWSリソースの詳細情報を収集し、Excel形式のパラメータシートを自動生成します。これにより、従来の手作業による転記やフォーマット調整を不要にし、成果物の標準化を実現します。 - Why(なぜ)

ドキュメント作成工程を省略化し、業務の生産性を向上させることが最大の目的です。さらに、ツールによって情報の正確性を担保し、ヒューマンエラーを防止することで品質向上にもつなげます。 - How(どのように)

技術的なバックグラウンドを問わず、誰でも簡単に操作できるUIを提供します。AWS CLIの知識がなくても、GUIベースでリソースを選択し、Excel出力まで完結できる仕組みを目指しました。

機能要件

業務要件で明確化した利用目的をもとに、ツールに必要な機能を整理しました。ここでは、どのような入力を受け取り、どのような出力を行うのか、さらに抽出する情報の方針について検討した内容を詳しく説明します。

まず、どのような入力を受け取るか検討しました。

機能要件 — インプット(入力)比較表

| 案 | 方式 | メリット | デメリット | |

| 案① | AWS CLI describe の結果JSON(構築後取得) |

|

|

〇採用 (正確性・汎用性重視) |

| 案② | CloudFormationテンプレート(構築時の宣言) |

|

|

×不採用 (実環境との差異リスク) |

次にどのような出力を行うのか検討しました。

機能要件 — アウトプット(出力)比較表

| 案 | 方式 | メリット | デメリット | |

| 案① | Excel(.xlsx) |

|

|

〇採用(納品適合性) |

| 案② | CSV |

|

|

×不採用 |

| 案③ | Markdown |

|

|

×不採用 |

AWSリソースのパラメータをどの範囲で抽出するかについても検討しました。

抽出するデータ

| 案 | 方式 | メリット | デメリット | |

| 案① | 必要な情報のみ抽出 |

|

|

×不採用 |

| 案② | すべてのパラメータを出力 |

|

|

〇採用 (正確性・汎用性重視) |

機能の全体像

最終的に、ツールは以下の機能を備えることを目指しました。

- AWS CLIのdescribeコマンド結果を取り込み、JSONを解析

- 必要な情報を抽出し、Excel形式で整形して出力

- 複数リソースの選択・一括出力に対応

- 誰でも簡単に操作できるGUIを提供

まとめ

今回の取り組みを通じて、業務改善の重要性を改めて実感しました。パラメータシート作成の自動化は、単なる効率化にとどまらず、品質の一貫性やヒューマンエラー防止にも大きく貢献できることがわかりました。一方で、アプリケーション開発の知見不足から、設計や要件定義で試行錯誤を重ねる場面もありましたが、その経験自体がチームの成長につながったと感じています。

このツールにはまだ改善の余地がありますので、今後も継続的に改良を重ね、より使いやすく、業務に役立つものにしていきたいと思います。

というわけで、私の投稿はここまでです!

次回は齋藤さんにバトンタッチしますので、ぜひお楽しみに!

みなさん、こんにちは。SCSKの津田です。

LifeKeeper は、オンプレミスの物理サーバから仮想基盤、各種クラウドサービスまで、幅広い環境で導入・運用できる高可用性クラスタソフトウェアです。

SIOSによると、近年ではクラウド環境への導入が全体の約半数を占めるまでに拡大しており、当チームでも設計・構築案件の多くがクラウド基盤上で展開されています。

とはいえ、多くの企業システムでは今なおオンプレミス環境が主軸として稼働しており、物理サーバや仮想基盤で LifeKeeper を利用したいというニーズも依然として高い状況です。

そこで本記事では、仮想環境においてLifeKeeperを導入する上で押さえておきたいポイントをご紹介します。

仮想環境での冗長化をご検討中の方は、ぜひご確認ください!

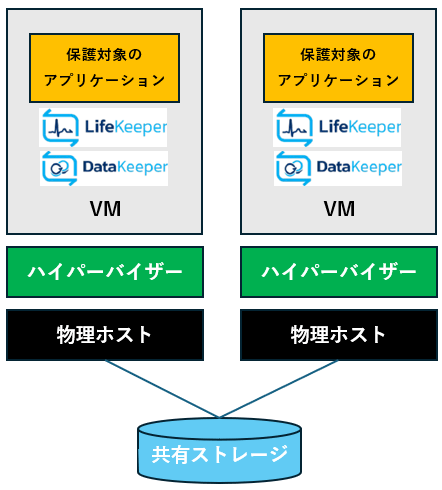

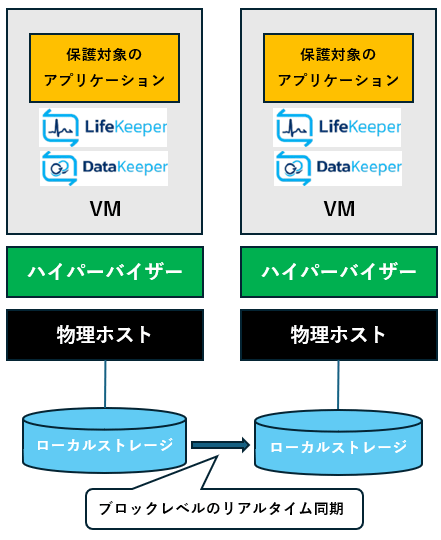

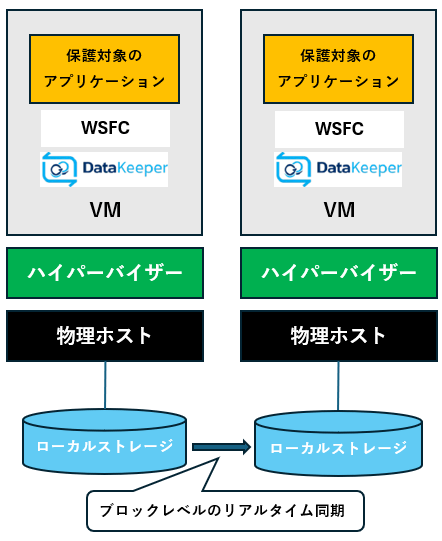

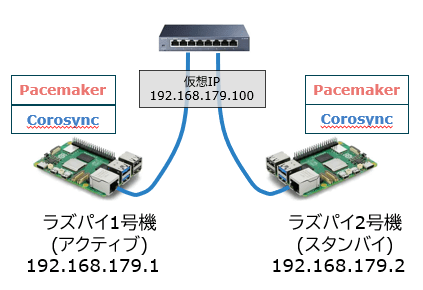

仮想環境のHAクラスター構成パターン

仮想環境で構成できるHAクラスター構成の基本パターンは以下となります。

共有ストレージが使えない環境では、データレプリケーション構成にすることが可能です。

| 構成①:共有ストレージ構成 | 構成②:データレプリケーション構成 | 構成③:データレプリケーション構成 (WSFCとの組み合わせ) |

|

|

|

※HAクラスター構成の他にSSP(Single Server Protection)構成も可能。

仮想環境におけるLifeKeeper障害対応

LifeKeeperを導入することで、以下のような幅広い障害を検知し、自動復旧(フェールオーバー)によるサービス継続が可能となります。

・アプリケーション障害

・ゲストOS障害

・仮想マシン障害

・仮想化ソフトウェア(ハイパーバイザ)障害

・物理ホスト障害

・ネットワーク障害(物理ホスト間のすべての通信経路断絶時)

※ゲストOS障害~ネットワーク障害までの範囲については、コミュニケーションパスが全て断たれた場合にノード障害として検知します。

上記の通り、物理ホストの障害にはもちろん、仮想マシンやアプリケーション単位の障害にも柔軟に対応できるため、仮想環境ならではの冗長性を最大限に活かすことができます。

特にVMwareの「vSphere HA」と比較した場合、ESXiホスト障害時にはLifeKeeperの方が障害検知から復旧までの時間が短いというメリットがあります。(LifeKeeperでは、待機系ESXiホストがあらかじめ起動状態で待機しているため、再起動が必要となるvSphere HAよりも迅速なフェールオーバーが可能。)

なお、リソースの監視や障害検知の方法については、仮想環境特有のものではなく、クラウド環境や物理環境と同様の仕組みを採用しています。

【OS別】サポート内容・留意事項

昨今Broadcom社によるVMwareの買収を受けて、VMware以外の仮想環境(ハイパーバイザ)を選択されるケースも増加傾向にあります。LifeKeeperでは、VMware以外の仮想環境にも対応していますので、お客様のニーズに合わせた仮想環境で高可用性構成を実現できる点も強みとなります。

本項ではLinux/Windows毎の最新サポート状況(Ver10)や留意事項をご紹介します。

LifeKeeper for Linux

サポート対象の仮想環境一覧(LifeKeeper for Linux version10.0)

LifeKeeper for Linuxでサポートされる仮想環境(ハイパーバイザ)は下記の通りとなります。

| 仮想環境 | バージョン |

| VMware vSphere | 7.0, 8.0, 8.0U1, 8.0U2, 8.0U3 |

| VMware Cloud on AWS | SDDC 1.19以降 |

| KVM | RHEL 8.10以降およびRHEL 9.0以降、ならびにOracle Linux(RHCK/UEK)8.10以降およびOracle Linux 9.0以降のバージョンのみをサポートし、その他のディストリビューションは対象外です。 |

| Nutanix Acropolis Hypervisor (AOS) | 6.10, 7.0, 7.3 |

| Hyper-V | Windows Server 2022 |

| Red Hat OpenShift Virtualization | 4.17以降 |

※仮想マシン上で使用できるOSついては下記をご確認ください。

オペレーティングシステム – LifeKeeper for Linux LIVE – 10.0

留意事項

サポート対象の各仮想環境に依存した制限や詳細な留意事項については、下記リンクの 「使用環境に関する制限・留意事項」 セクションをご確認ください。

仮想化環境 – LifeKeeper for Linux LIVE – 10.0

また、仮想環境として採用されることの多い VMware vSphere や Hyper‑V については、サイオステクノロジー社より個別の構成ガイドが提供されています。各ハイパーバイザでの構成例や特有の注意点が詳細にまとめられていますので、設計時には必ず確認することを推奨します。

▼ VMware vSphere

LifeKeeper for Linux 仮想環境構成ガイド (VMware vSphere編) – SIOS LifeKeeper/DataKeeper User Portal

[Linux][Windows]VMware vSphere環境でRDM使用時のLifeKeeperサポート構成について – SIOS LifeKeeper/DataKeeper User Portal

▼ Hyper‑V(Linux / Windows 共通)

LifeKeeper 仮想環境構成ガイド (Hyper-V編) – SIOS LifeKeeper/DataKeeper User Portal

共有ストレージ利用時の留意事項

LifeKeeper for Linuxでクラスタの共有データ領域を利用する際の構成については、以下をご参照ください。

[Linux]クラスターの共有データ領域として利用できる構成 – SIOS LifeKeeper/DataKeeper User Portal

なお、LifeKeeper for Linuxでは、共有ストレージの認定が行われています。複数ノードで同一データを参照する共有ストレージ(SCSI / FC / iSCSI / SASなど)は、SCSI-2/3 ReservationによるI/Oフェンシングを前提としており、認定されたストレージを使用する必要があります。認定ストレージの一覧は、以下のリンクにある表を展開してご確認ください。

共有ストレージ – LifeKeeper for Linux LIVE – 10.0

一方、以下の構成についてはストレージ認定が不要です。

・NASストレージ(Recovery Kit for NASが必要)

・DataKeeperによるデータレプリケーションに利用する全てのディスク装置(内蔵/外付けを問いません)

・vSphere上でVMDK ARKにより保護される共有ストレージ上の仮想ディスク

・以下の条件をすべて満たす環境で利用するストレージ(Any Storage)

① OS・ハードウェア・プラットフォームでサポートされているストレージであること

② LifeKeeperのSCSI Reservation機能をオフにすること

③ LifeKeeperのQuorum/Witnessによるフェンシング機能を利用すること

LifeKeeper for Windows

サポート対象の仮想環境一覧(LifeKeeper for Windows version10.0)

LifeKeeper for Windowsでサポートされる仮想環境(ハイパーバイザ)は下記の通りとなります。

| 仮想環境 | バージョン |

| VMware vSphere | 7.0, 8.0, 8.0U1, 8.0U2, 8.0U3 |

| Red Hat OpenShift Virtualization | 4.17以降 |

| KVM | RHEL 8.10以降およびRHEL 9.0以降、ならびにOracle Linux(RHCK/UEK)8.10以降およびOracle Linux 9.0以降のバージョンのみをサポートし、その他のディストリビューションは対象外です。 |

| Microsoft Hyper-V Server | 2016, 2019, 2022 |

| Nutanix Acropolis Hypervisor (AOS) | 6.10,7.0,7.3 |

※仮想マシン上で使用できるOSついては下記をご確認ください。

オペレーティングシステム – LifeKeeper for Windows LIVE – 10.0

留意事項

サポート対象の各仮想環境に依存した制限や詳細な留意事項については、下記リンクの 「使用環境に関する制限・留意事項」 セクションをご確認ください。

仮想化環境 – LifeKeeper for Windows LIVE – 10.0

また、仮想環境として採用されることの多い VMware vSphere や Hyper‑V については、サイオステクノロジー社より個別の構成ガイドが提供されています。各ハイパーバイザでの構成例や特有の注意点が詳細にまとめられていますので、設計時には必ず確認することを推奨します。

▼ VMware vSphere

LifeKeeper for Windows / DataKeeper Cluster Edition 仮想環境構成ガイド (VMware vSphere編) – SIOS LifeKeeper/DataKeeper User Portal

[Linux][Windows]VMware vSphere環境でRDM使用時のLifeKeeperサポート構成について – SIOS LifeKeeper/DataKeeper User Portal

▼ Hyper‑V(Linux / Windows 共通)

LifeKeeper 仮想環境構成ガイド (Hyper-V編) – SIOS LifeKeeper/DataKeeper User Portal

共有ストレージ利用時の留意事項

LifeKeeper for Windowsには、Linuxのようなサイオステクノロジー社による認定ストレージリストは公開されていませんが、標準的なSCSI、FC、iSCSI等の共有ディスクが利用可能です(参考:https://www.windowsservercatalog.com/hardware)。

詳細や制約については、事前にサポートへのお問い合わせを推奨いたします。

また、LifeKeeper for WindowsではAny Storageポリシーは提供されていませんが、Quorum/Witness機能を利用することでスプリットブレインの回避に役立ち、より堅牢な運用が可能となります。

【OS共通】その他設計・運用上のポイント

仮想環境専用ライセンスの使用ルール・制限事項

仮想環境では、以下のような仮想環境特有のライセンス利用ルールが設定されていますのでご注意ください。

・一つのライセンスは、一つの占有された物理ホスト上でのみ使用可能。

・異なる物理ホスト間でのみ、クラスター環境を構成可能。

・一つのライセンスで異なるバージョンのLifeKeeperを使用することは不可。

・一つのライセンスには一つのサポートレベルのみ適用可能。

・最低販売数量は2つ(Core 4、2クラスター環境)からとする。

LifeKeeper 設定上の考慮点

LifeKeeperのインストールおよびクラスター設定は、物理環境と同様の手順で行うことができます。具体的な手順については、オンラインマニュアルをご参照ください。

※IPリソースの監視処理について

仮想環境では、物理的なネットワークスイッチだけでなく、仮想的なネットワークスイッチも存在するため、これらを含めたネットワーク構成全体を十分に考慮する必要があります。

さいごに

今回は仮想環境においてLifeKeeperを導入する上で押さえておきたいポイントをご紹介いたしました。

多様な選択肢と注意点が存在しますが、その分多様な要件に適した HA 構成を実現できる柔軟性を備えています。

仮想環境でLifeKeeper導入をご検討中の方にとって、少しでも参考となりましたら幸いです。

本記事は TechHarmony Advent Calendar 2025 12/24付の記事です。 本記事は TechHarmony Advent Calendar 2025 12/24付の記事です。 |

こんにちは、SCSKでAWSの内製化支援『テクニカルエスコートサービス』を担当している貝塚です。

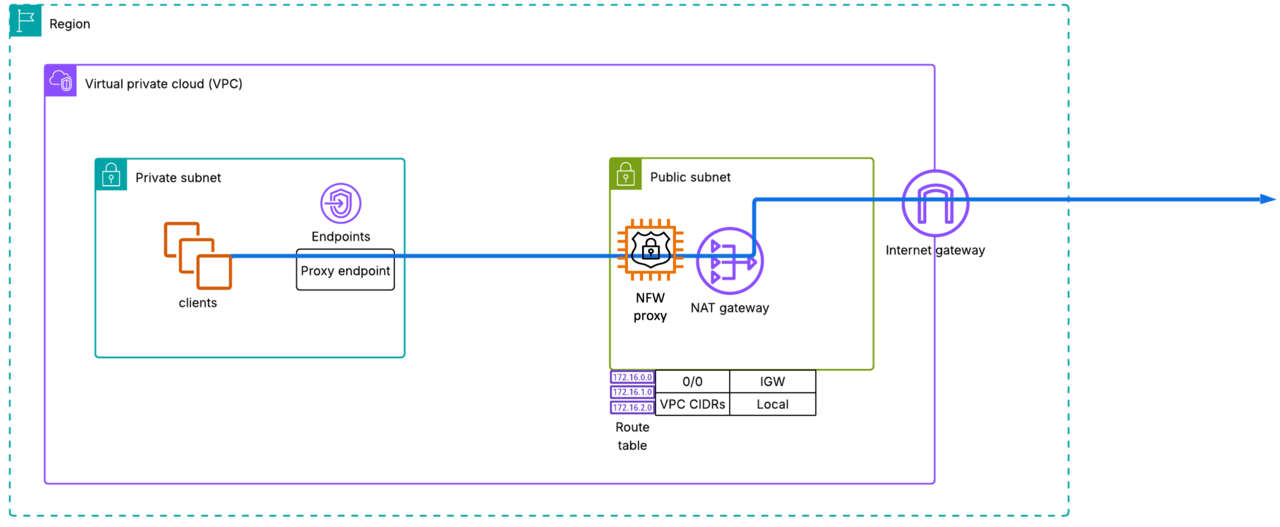

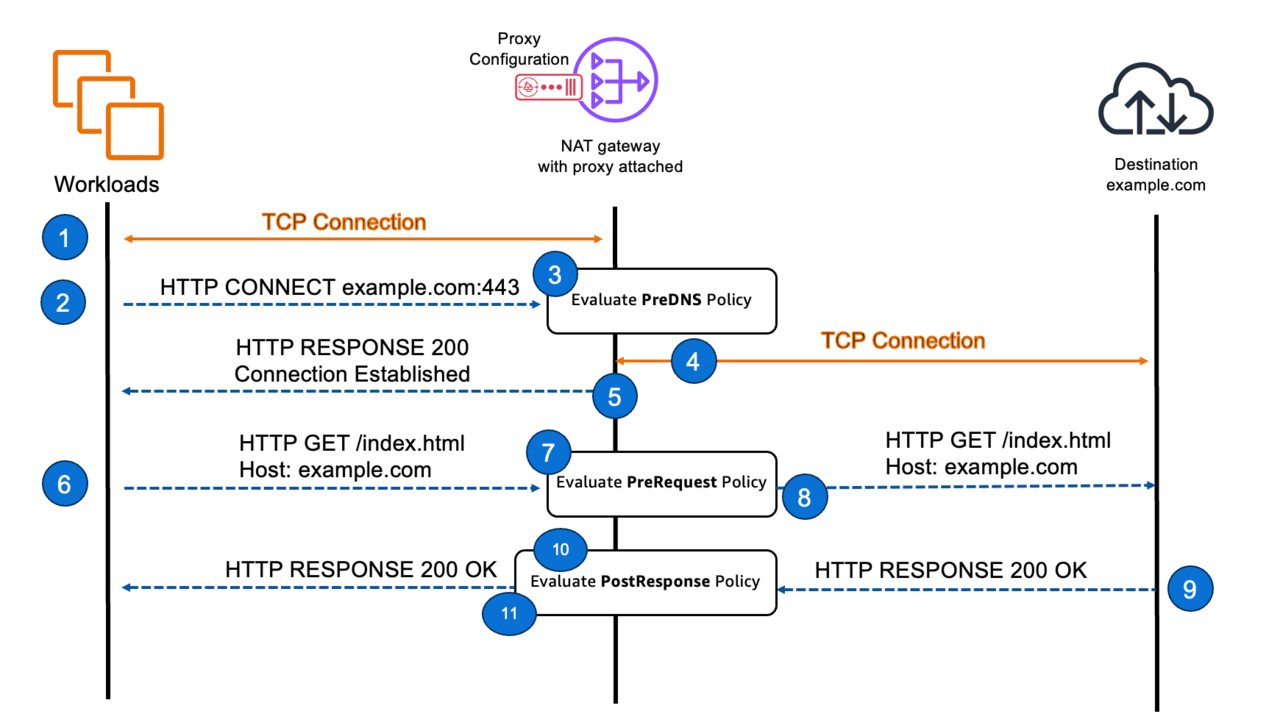

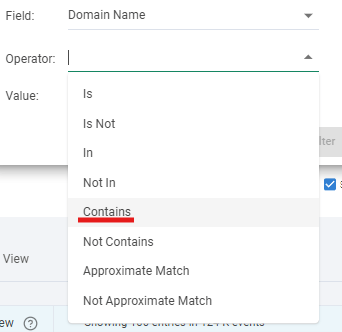

re:Invent2025の直前に、Network Firewall Proxyという機能のプレビューが開始されました。

リリース記事

ブログ記事

AWS Network Firewallで機能提供していた透過型プロキシではなく、クライアント側で明示的にプロキシサーバとして指定する必要のあるタイプのプロキシです。

私の担当するお客様でも金融業を中心に過去にプロキシサーバの導入を検討された結果EC2でプロキシを構築したり、Network FirewallでのTLS検査を検討されたりしていますので、それらのお客様への導入という視点からNetwork Firewall Proxyの機能を検討してみます。

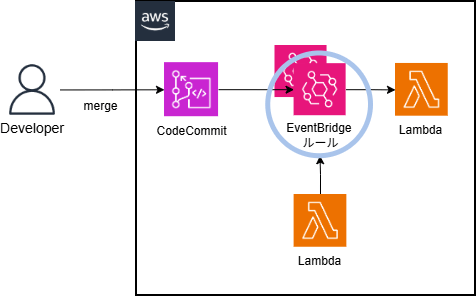

アーキテクチャ

名前にNetwork Firewallとついていますが、既存のAWS Network Firewallの一機能ではなく、独立したリソースになっているようです。NAT Gatewayとセットで動作し、クライアントは専用のVPCエンドポイント(Proxyエンドポイント)経由でプロキシを使用することになります。

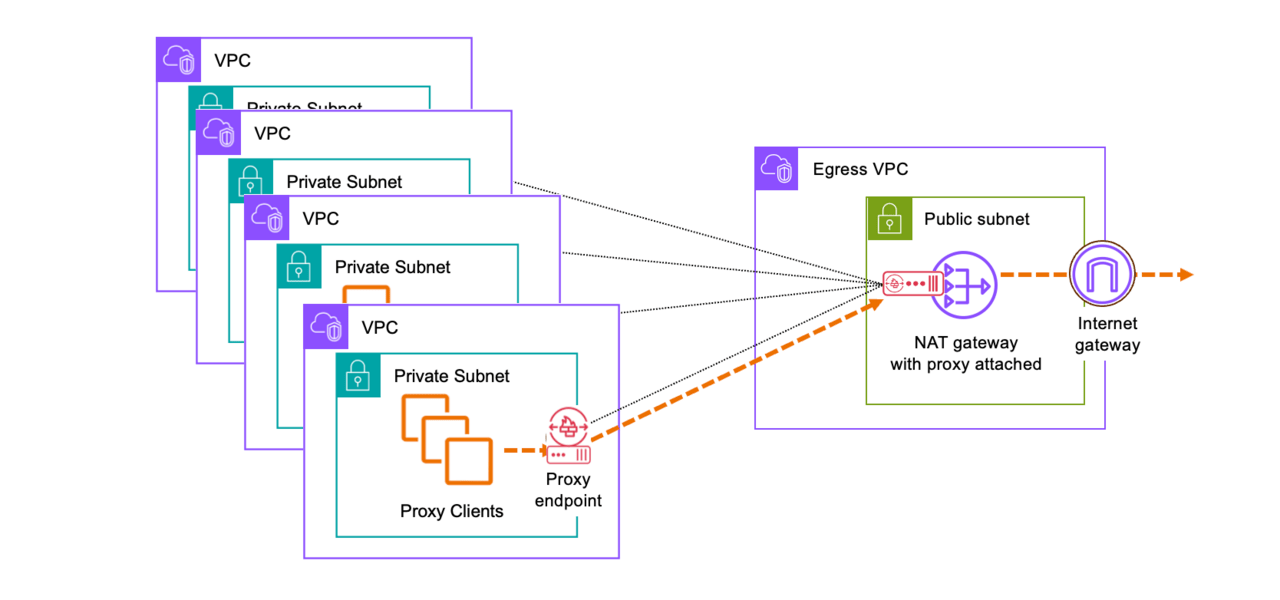

シンプル(単一VPC)構成

上の図がもっともシンプルな構成ですが、実際に設定してみるとNetwork Firewall Proxyと同じサブネット(パブリックサブネット)に自動的にProxyエンドポイントが作成されることが分かります。同VPC内に既にエンドポイントがあるのに別サブネットにエンドポイントを作る必要性はイマイチ理解できませんが、構成上はどちらでも動作しました。

少し調べてみたところ、こちらのblogではProxyと同じパブリックサブネットにエンドポイントが置かれていたので、そのあたりは好きに設計すればよさそうです。

中央集約構成

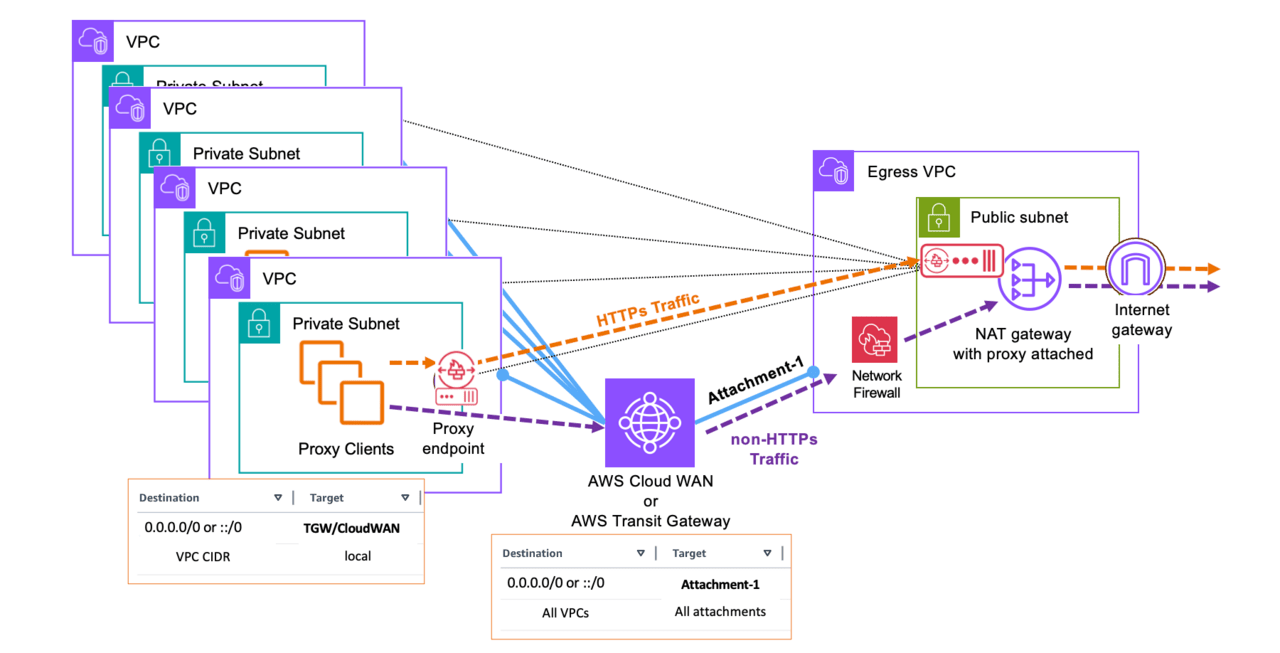

他のネットワークリソース(Internet GatewayやNetwork Firewallなど)と同様に、Network Firewall Proxyも、複数のVPCのProxy機能をひとつに集約した構成を取ることができます。

そしてここが素晴らしい点なのですが、Network Firewall Proxyの機能はVPCエンドポイントとして提供されているので、通信要件がHTTP/HTTPSのみであれば、Transit GatewayやVPC PeeringなどでVPC間を接続することなく、インターネットとの通信をセキュアに実現できてしまうのです。

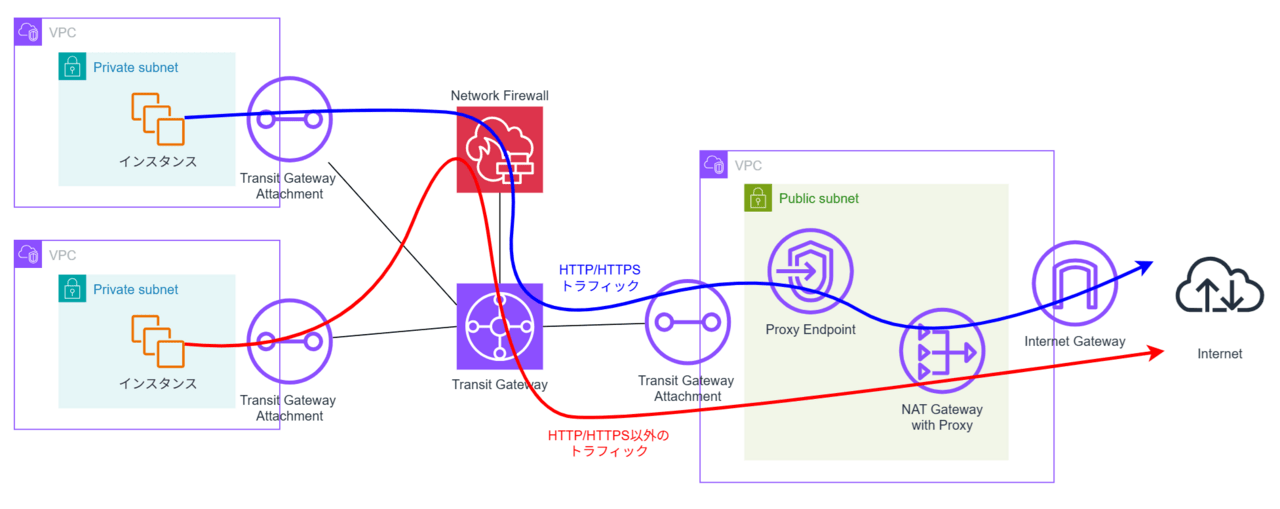

HTTP/HTTPS以外にも通信要件がある場合は、従来同様Transit GatewayでVPC間を接続し、HTTP/HTTPS通信はProxyエンドポイント経由、HTTP/HTTPS通信以外はTransit Gateway経由という方式が紹介されています。

上図構成だと、HTTP/HTTPSの検査・制御はNetwork Firewall Proxyで行う、HTTP/HTTPS以外の検査・制御はNetwork Firewallで行うことになります。ログの出力先もログのフォーマットも別になり、運用管理上の負荷が増えそうですが、これは現状仕方ありません。

一方で、Transit Gatewayで中央集約VPCとつながっているのであれば、Proxy エンドポイントは各VPCに持つのではなく、下図の通り中央集約VPCにひとつだけ置くというのも選択肢としてありえそうですが……HTTP/HTTPSトラフィックがNetwork FirewallとNetwork Firewall Proxy両方通ることになると無駄に高額なトラフィック料金を払わされることになり現実的ではないのかもしれません。まだNetwork Firewall Proxyの料金が発表されていないので、この部分は料金の発表を待たないとこれ以上議論できなさそうです。

プロキシのルールについて

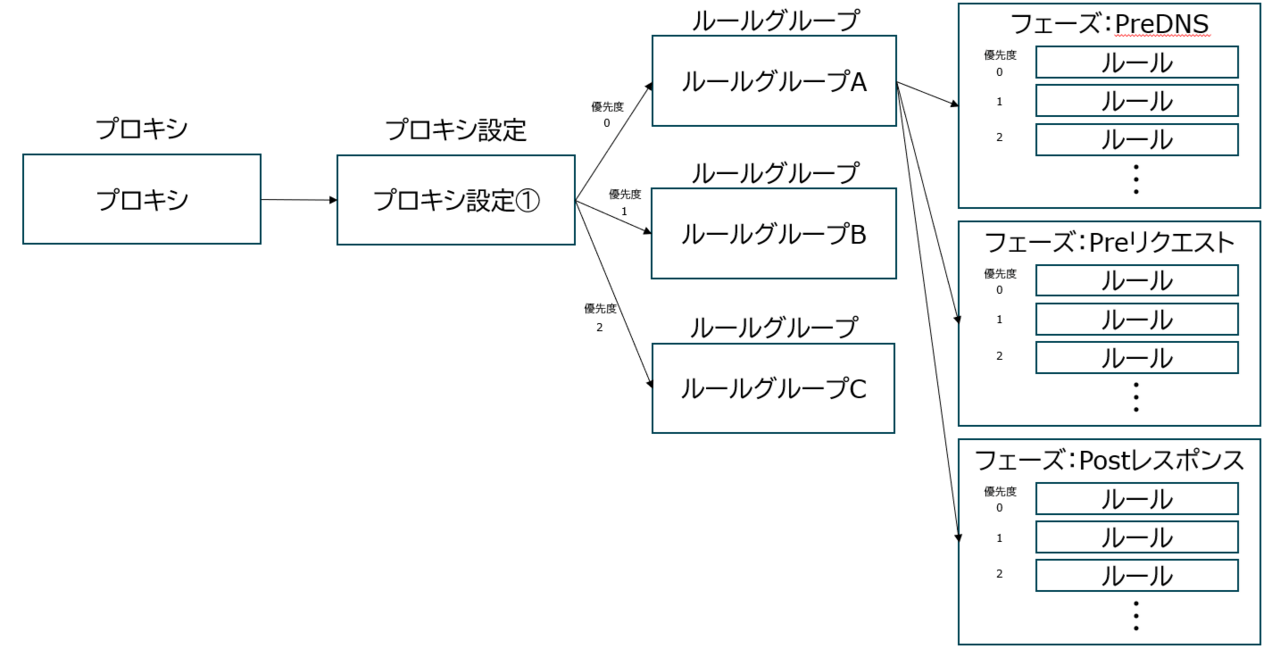

プロキシのルール構造は下図のようになっています。

プロキシは1つのプロキシ設定を持ちます。

プロキシ設定は複数のルールグループを持つことができます。プロキシ設定内で、複数のルールグループに0~の優先度をつけることができ、値が小さいグループから順に評価されるようになっています。また、どのルール(後述)にも合致しなかった場合のデフォルトのアクション(許可/拒否)をプロキシ設定で指定します。

ルールグループは複数のルールを持つことができます。ルールグループの設定のところで各ルールを記述して行きます。ルールは検査した通信に対するアクション(許可/拒否)と条件を記したもので、0~の優先度をつけることができ、値が小さいルールから順に評価されるようになっています。

以上をまとめると、ルールはフェーズ(後述)ごとに、以下の順番で評価されていき、どのルールにも合致しなかった場合、デフォルトのアクションが実行されるということになります。

優先度0のルールグループ:優先度0のルール → 優先度0のルールグループ:優先度1のルール → 優先度0のルールグループ:優先度2のルール → … → 優先度1のルールグループ:優先度0のルール → 優先度1のルールグループ:優先度1のルール → … → 優先度2のルールグループ:優先度0のルール → … → デフォルトのアクション

フェーズ

プロキシのルールは、HTTP/HTTPSの通信の段階に応じて、PreDNS、PreREQUEST、PostRESPONSEの3つのフェーズに分けて適用されます。

- クライアントがHTTP CONNECTを出し、ProxyがDNS名前解決を行う前にルールを適用するのがPreDNSです。

- クライアントがHTTP REQUESTを出し、Proxyがあて先にHTTP REQUESTを行う前にルールを適用するのがPreRequestです。

- あて先からProxyに返ってきたHTTP RESPONSEをクライアントに返す前にルールを適用するのがPostResponseです。

アクション

アクションは、許可(allow)、アラート(alert)、拒否(deny)の3つがあります。

許可(allow)、拒否(deny)はそのままの意味ですが、アラート(alert)はアラートログに出力した上で次以降のルールの評価を継続します。許可した場合でもログを出力することができますので、許可(allow)ログは証跡としての保存用、アラート(alert)ログはCloudWatch等で捕捉してSNS連携等のアクションにつなげるという使い方が想定されているのだと考えられます。

条件

アクションの発生条件を、リクエストやレスポンスに関わる各種値を使用して指定します。現在対応しているのは以下の通りです。

- request:SourceAccount – リクエスト送信元のAWSアカウントID

- request:SourceVpc – リクエスト送信元のVPC ID

- request:SourceVpce – リクエスト送信元のVPCエンドポイントID

- request:Time – リクエストが発生した日時

- request:SourceIp – 送信元のIPアドレス

- request:DestinationIp – 送信先のIPアドレス

- request:SourcePort – 送信元のポート番号

- request:DestinationPort – 送信先のポート番号

- request:Protocol – 通信プロトコル(TCPなど)

- request:DestinationDomain – 送信先のドメイン名

- request:Http:Uri – HTTPリクエストのURI(パス)

- request:Http:Method – HTTPリクエストメソッド(GET, POSTなど)

- request:Http:UserAgent – HTTPリクエストのUser-Agentヘッダーの値

- request:Http:ContentType – HTTPリクエストのContent-Typeヘッダーの値

- request:Http:Header/CustomHeaderName – HTTPリクエスト内の指定したヘッダーの値(CustomHeaderNameを実際のヘッダー名に置き換えて使用)

- response:Http:StatusCode – HTTPレスポンスのステータスコード

- response:Http:ContentType – HTTPレスポンスのContent-Typeヘッダーの値

- response:Http:Header/CustomHeaderName – HTTPレスポンス内の指定したヘッダーの値(CustomHeaderNameを実際のヘッダー名に置き換えて使用)

設定手順

プロキシの作成は以下の手順で実施します。

- プロキシルールグループの作成

- ルールの作成

- プロキシ設定の作成 → ここで、プロキシルールグループを指定

- (まだ作成していないなら) NATゲートウェイの作成

- (TLS インターセプトモードを有効化するなら) プライベートCAの作成、Resource Access Manager共有設定

- プロキシの作成 → ここで、プロキシ設定、NATゲートウェイ、プライベートCAを指定

- Proxyエンドポイントの作成

本稿では、具体的な操作手順については説明を致しません。(公式ドキュメントなどをご参照ください)以下、注意すべき点のみを書いて行きます。

TLSインターセプトモードについて

TLS通信の中身を検査するには、プライベート証明書を発行できるプライベートCAが必要になります。公式ドキュメントの記述が不親切なのですが、プライベートCAを作成し、RAM (Resource Access Manager) で共有して、「下位CAは作成できず従属CA証明書の発行のみ許可する権限」(AWSRAMSubordinateCACertificatePathLen0IssuanceCertificateAuthority)を与えてあげてください。プライベートCAのことをよく知っている人には当然のことなのかもしれませんが、私はこれが理解できておらずハマりました。

TLS検査の仕組みや、クライアントPCでプライベート証明書を信頼する手順は、以下の記事もご参照ください。

TLSインターセプトモードが有効になると、条件 request:Http:* や response:Http:* を使用した検査が行えるようになります。

Proxyエンドポイントの作成

プロキシが作成されると、プロキシと同じサブネットにProxyエンドポイントが作成されます。Proxyエンドポイントは追加作成することができます。プロキシの詳細に「VPC エンドポイントサービス名」という項目が表示されるので、プロキシを使用したいVPCでVPCエンドポイントを作成し、タイプに「NLB と GWLB を使用するエンドポイントサービス」、サービス名に「VPC エンドポイントサービス名」の値を入れるようにしてください。なお、最初に作成されるProxyエンドポイントは不要であれば削除しても構いません。

クライアントでプロキシ設定して使用

プロキシの詳細に「プライベート DNS 名」が表示されるので、その値( xxxxxxxx.proxy.nfw.<リージョンID>.amazonaws.com )をクライアントのプロキシ設定箇所に設定して使用します。

さいごに

顧客企業への導入検討と銘打ちながら、検討らしきものはアーキテクチャ検討部分だけとなってしまいましたが、プレビューが進みGA段階になれば、プレビュー段階に存在する様々な制約も解消され、具体的に検討が進められるかなと考えています。

現段階では、インターネットアクセス要件がHTTP/HTTPSだけであればTransit GatewayやVPC Peeringを作ることなくVPCエンドポイントだけで接続できてしまう点がメリットとして大きいように感じます。

まずはプレビューで出来る範囲でいろいろ試してみたいと思います。

]]>だいぶご無沙汰しております。村上です。

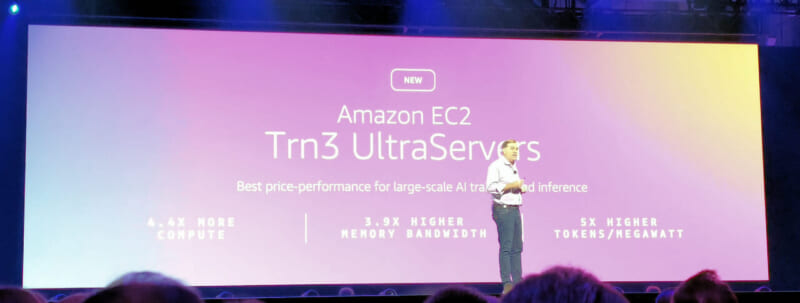

ラスベガスで開催された「AWS re:Invent 2025」に参加してきましたので、複数回にわたって参加レポートをお届けします。

では早速。今回は「Self-paced Traning」と「AWS Builder Center」についてです。

※ちなみにタイトルにもある通り、海外渡航は人生2回目の海外初心者です・・・

コミュニケーションや現地での過ごし方で苦戦したエピソードもどこかで紹介したいと思います。

(今回の記事の内容自体にはほとんど関係ありません)

「Self-pased Traning」に参加してみた

Self-pased Traningとは?

re:Inventの初日、気合を入れすぎて相当早く会場へ到着。

お目当てのセッションまで時間があったので、会場を歩き回っていたところ「Self-paced Traning」というエリアを発見しました。

これは、re:Inventの開催期間中、AWSサービスに関するのクイズやハンズオン、AWS認定試験の準備など、200以上の学習コンテンツが「無料で」受けられるというもの。

「AWS Skill Builder」にあるものと重複しているものもありそうでしたが、このようなイベントで初披露されるコンテンツもあるとのこと。

空き時間でサクッと参加するにはちょうどよいアクティビティかなと。

▼会場の雰囲気はこんな感じ。

PCとモニターが1台ずつ用意されていますので、自身のデバイスは不要です。

受付に一言を声かけて、好きな席に座るだけでOKです。

実際にやってみた

今回「AWS ESCAPE ROOM」というRPG風ゲーム形式の学習コンテンツに挑戦しました。

その中でも「Exam Prep for AWS Certified AI Practitioner」というAI Practitioner認定向けコンテンツを選びました。

▼スタート画面。

ネタバレになるので詳細は割愛しますが、

AI Practitionerで求められる知識を問うクイズと「Amazon Bedrock」を使った生成AIアプリケーション構築のハンズオンが含まれていました。

クイズはAWS初学者向けで、英語ですが難しいものはありません。

途中BGMが流れたり、動画視聴なんかもあったりするので、有線イヤホンがあると便利です。

(持っていてよかったものについては「会場の歩き方編」なんかでまとめたいと思っています)

▼ハンズオンで利用したアーキテクチャ。

操作はガイド通りにポチポチやっていけば簡単に作成できます。初学者がイメージを掴むのにはよいかもしれません。

本当は「岩に乗ったペンギン」の画像を出力させるというお題でしたが、「ラーメンを食べる日本人女性」にしてみました。

▼こんな感じの画像が出力されました。

このように、気軽に学習できるだけでなく、海外からの参加者と同じ空間でで手を動かすのもよい刺激になりました。

空き時間を有効活用できるアクティビティとしておすすめです。

「AWS Builder Center」を利用しよう

「Self-paced Traning」を利用するには、「Builder ID」が必要になります。

これは「AWS Builder Center」を利用するための個人に紐づくアカウント。Amazon Q DeveloperやAWS Skill Builder、AWS re:Postなど、学習コンテンツや学習ツールを利用できるようになります。

(ちなみに私もほとんど活用したことがなかったので、これから触ってみる予定です)

「AWS Builder Center」に関しては、AWSも非常に力を入れている印象でした。

メンバー向けのイベントや休憩可能な専用ブースもあり、会場スタッフも「是非寄ってみて!」と積極的に声をかけていました。

▼立ち寄った専用ブース。

▼SWAGもたくさん。

ということで、第一回はこのくらいで終わります。

re:Inventに参加した際は是非「Self-paced Traning」への参加を、

また、日々の学習の際は「AWS Builder Center」を、というお話でした、

また次回作も見てくれたらうれしいです。

]]> 本記事は TechHarmony Advent Calendar 2025 12/23付の記事です。 本記事は TechHarmony Advent Calendar 2025 12/23付の記事です。 |

どうも。四国の高知県に来ている寺内です。このブログを書くために、わざわざHHKBを出張に持ってきました。

さて。どこにいても、PCが変わっても、自分の慣れ親しんだ環境を使いたいものですよね。それが作業効率のみならず心地よさに大きく影響するからです。

VSCode周りやブラウザは長い時間を育ててきている設定ファイルを複数PC間で同期できるのでよいですが、OS周りの設定同期や共有は面倒なものがあります。ブラウザで環境が完結していたCloud 9は重宝する面が多々ありました。残念ながらサ終に向かっていることもあり、代替を検討するチームも多いでしょう。

当社のAWS Ambassadors 広野さんが2025年9月に投稿した以下のブログ記事では、Ubuntuが稼働するEC2のデスクトップコンソールをブラウザで操作するサーバを構築できます。

大変優れた記事ですが、こちらのCFnテンプレートでは、素のUbuntu稼働のEC2インスタンスを作成し、その後デスクトップ環境の構築を行います。これはEC2インスタンスを作成するタイミングの違いで、インストールされるツール・ライブラリのバージョンが異なることになります。チーム開発をしているケースで、ある程度の環境の統制を効かせたい場合、メンバー毎にバージョンの違いが生じるのは塩梅がよくありません。

そこで本記事では、このCFnテンプレートを個人利用スコープからチーム開発スコープに拡張します。広野さんのCloudFormationテンプレートを参考にしつつ、新たに開発サーバ構築ツール「vsimage」として再構成します。

vsimageツールのアーキテクチャの考え方はCloud 9 のアーキテクチャを踏襲します。つまり、チームとしてのAMIを一つ作っておき、メンバーはそのAMIからマイ環境のEC2インスタンスを起動するという使い方です。環境をビルドしAMIを作成するフェーズと、EC2インスタンス化するフェーズを分離することで、EC2作成時にデスクトップソフトウェアのインストール時間を待つ必要がなくなります。

登場人物の役割と利用方法概略

vsimageは、以下の二種類の役割の人間を想定しています。

- AMI管理者: Ubuntu OSおよび導入ツールの管理を行い、AMIをチームメンバーへ提供する責任を持つ役割です。

- 開発者: AMI管理者によって提供されるAMIを用いて、自分専用のUbuntu EC2インスタンスを作成し、VSCodeを利用する役割です。

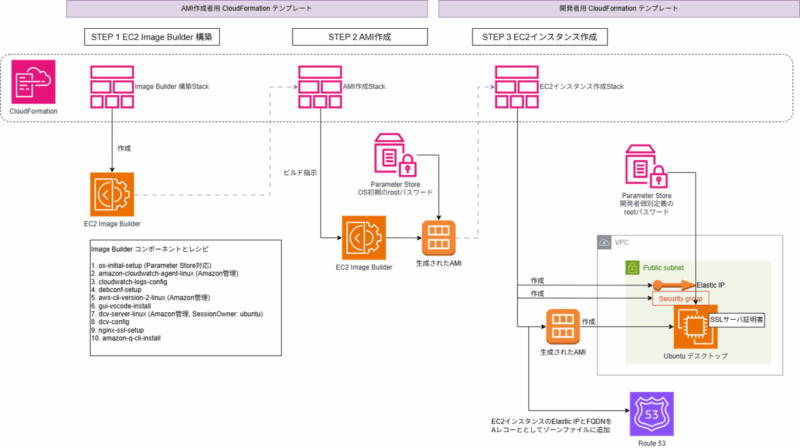

vsimageは、以下3つのCFnテンプレートからなります。

- Image Builder構築テンプレート:

imagebuilder-pipeline.yaml - AMI作成テンプレート:

ami-creation-execution.yaml - EC2インスタンス構築テンプレート:

ec2-launch-from-ami.yaml

1と2のCFnテンプレートは、AMI管理者が使用します。3は開発者が使用します。

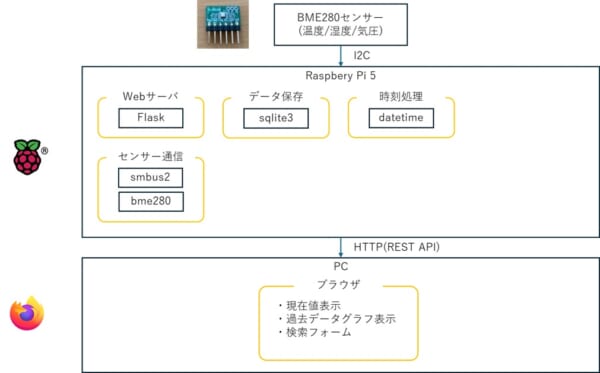

アーキテクチャ概要

Ubuntu ServerにGUI環境をインストールしUbuntu Desktopにします。その後、DCVやVSCodeなどの必要なツール群をインストールします。これらの一連の作業は、EC2 Image Builderを使用します。

AMI管理者は、Image Builderのコンポーネント定義とレシピ定義を行いUbuntuにインストールするソフトウェアを定義します。その設定をパイプラインとして定義します。

パイプラインを実行し、Image Builderで作成されたAMIをチームに公開します。

開発者はそのAMIを使用して、自らのVPC環境にEC2インスタンスを起動します。

ブラウザからスムーズにアクセスできるように、EC2起動と同時にRoute 53へFQDNと新規取得したElastic IPの組み合わせをAレコードで登録します。またSSL接続を行うためのオレオレサーバ証明書を内部で作り出します。

Ubuntuサーバは、安価なGravitonインスタンスタイプで動作します。そのため、AMI作成プロセスにおけるインスタンスタイプも同じくGravitonを指定しています。 AMI作成段階で作るインスタンスタイプは、t4g.large。EC2作成段階ではパラメータで指定可能ですが、デフォルトはt4g.largeです。

パスワード管理の仕組み

vsimageでは、Ubuntuのrootパスワードは以下の二段階で設定します。

AMI作成段階(アーキテクチャ図でいうSTEP 2)で、 ami-creation-execution.yaml にCloudFormationパラメータとして、AMI管理者が設定したパラメータストアキーを与えます。AMI作成中にパラメータストアからパスワード文字列を読み出し、Ubuntu ルートパスワードを設定します。生成された直後のAMIには、AMI管理者が定義した文字列がルートパスワードとなります。

EC2インスタンス作成段階(アーキテクチャ図でいうSTEP 3)では、開発者が実行する ec2-launch-from-ami.yaml にCloudFormationパラメータとして、開発者が設定したパラメータストアキーを与えます。EC2インスタンス作成中にパラメータストアからパスワード文字列を読み出し、Ubuntu ルートパスワードを設定します。もしパラメータストアキーが未設定であったり、パラメータストアの読み出しが失敗した場合は、AMI管理者の設定したルートパスワードのままとなります。

どちらの段階でのルートパスワード設定方法は、 /home/ubuntu/set-password-from-parameter.sh というスクリプトがOS起動時にsystemctrl により実行されることで設定されます。

作成されるAMIの概略

作成されるAMIは以下の内容となります。

- ベースとなるOSは、ubuntu-24-lts-arm64の最新版

- EBSボリュームはルート領域の1つで20GBのサイズ

- ubuntu-desktopパッケージ一式とX windowサーバパッケージを導入

- 日本語パックパッケージとibus-mozcパッケージを導入

- nginxパッケージを導入

- certbotパッケージを導入

- VSCodeパッケージを導入

- Amazon管理コンポーネントのDCVサーバを導入

- Amazon管理コンポーネントのCloudWatchエージェントを導入

- Amazon管理コンポーネントのAWS CLIを導入

独自にAMI内部に作られるシェルスクリプトは以下3つがあります。いずれもubuntuユーザのホームディレクトリ /home/ubuntu に作られます。ルートパスワード設定とSSLサーバ証明症作成はsystemctlのサービスとして追加され、OS起動直後に一度だけ自動実行されます。

- 前述したルートパスワード設定ファイル:

set-password-from-parameter.sh - SSLサーバ証明書作成スクリプト:

setup-ssl.sh - SSLサーバ証明書更新スクリプト:

renew-cert.sh

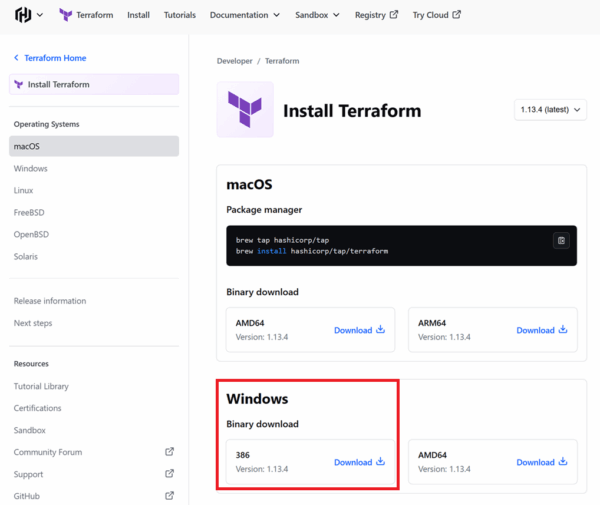

vsimageツール利用手順

以下では、CloudFormationテンプレートからCloudFormationスタックを作成する手順を示します。この手順に従い、パラメータを適切に設定すれば、Ubuntuサーバが完成します。

CFnテンプレートのダウンロード

ダウンロードリンク

vsimageは、以下3つのCFnテンプレートから成り、zip圧縮してあります。

- Image Builder構築テンプレート:

imagebuilder-pipeline.yaml - AMI作成テンプレート:

ami-creation-execution.yaml - EC2インスタンス構築テンプレート:

ec2-launch-from-ami.yaml

こちらのリンクからzipファイルをダウンロードしてください。

前提条件

vsimageを使用する前提は以下です。

- AMI管理者は、EC2インスタンスを起動後のUbuntu ルートパスワードをパラメータストアに保存しておく必要があります。このパスワードは、実質的には開発者のルートパスワードで上書きされますが、開発者によるパスワード定義がされていない場合にこのルートパスワードが有効になるように設計してあります。

- 開発者は、DNSルートから検索可能な正規のドメインを持ち、Route 53でホストゾーンを定義している必要があります。これは、最終的にブラウザからアクセスするためのURLとして使うことと、SSLサーバ証明書の署名にも利用します。

- 開発者は、UbuntuのEC2インスタンスを起動するためのVPCおよびパブリックサブネットを用意しておく必要があります。

- 開発者は、EC2インスタンスを起動後のUbuntu ルートパスワードをパラメータストアに保存しておく必要があります。

コードを使用する上での注意点

- このサンプルコードではツール名称を「ytera-vsimage」と仮称します。ファイル名やパイプライン名などの随所で使用されているので、実際に使用されるときは

grepなどで検索して置き換えてください。 - このツールが作成するリソースは、Costタグが付与するようにハードコーディングされています。

Key: CostValue: y.terauchiの部分も適宜置き換えてください。

ImageBuilderの構築手順

まずImage Builder構築テンプレート imagebuilder-pipeline.yaml を用いて、Image Builderのパイプライン構築を行います。このスタック実行にはおおよそ5分ほどかかります。

パラメータ一覧

CloudFormationへ与えるパラメータは以下のとおりです。

PasswordParameterName |

AMI作成段階で指定するUbuntuルートパスワードを収納しているパラメータストアキー名を指定します。 |

LoggingBucket |

Image Builderの動作ログを保管するS3バケットを新規作成ときのバケット名を指定します。このパラメータが有効になるのは、 CreateNewBucketをtrueとしたときです。 |

CreateNewBucket |

上記名前で新規作成するときにtrueを指定します。二回目以降のスタック実行の場合はS3バケットは存在しているのでfalseを指定します。 |

ExistingBucketName |

S3バケットを新規作成しない場合に既存バケット名を指定します。新規作成する場合はパラメータ指定をしません。 |

コマンド例

AWS CLIで実行するときのコマンド例を以下に示します。

【一回目の実行であり、S3バケットを新規作成する場合】

aws cloudformation create-stack \

--stack-name ytera-vsimage-pipeline \

--template-body file://imagebuilder-pipeline.yaml \

--parameters \

ParameterKey=PasswordParameterName,ParameterValue=/ytera-vsimage/ubuntu-password \

ParameterKey=CreateNewBucket,ParameterValue=true \

ParameterKey=LoggingBucket,ParameterValue=ytera-vsimage-imagebuilder-logs-ap-northeast-1 \

--capabilities CAPABILITY_NAMED_IAM \

--region ap-northeast-1【二回目以降の実行であり、既存のS3バケットを使用する場合】

aws cloudformation create-stack \

--stack-name ytera-vsimage-pipeline \

--template-body file://imagebuilder-pipeline.yaml \

--parameters \

ParameterKey=PasswordParameterName,ParameterValue=/ytera-vsimage/ubuntu-password \

ParameterKey=CreateNewBucket,ParameterValue=false \

ParameterKey=ExistingBucketName,ParameterValue=ytera-vsimage-imagebuilder-logs-ap-northeast-1 \

--capabilities CAPABILITY_NAMED_IAM \

--region ap-northeast-1AMI作成手順

AMI作成テンプレート ami-creation-execution.yaml を実行し、AMI作成を行います。このスタック実行にはおおよそ40分ほどかかります。

パラメータ一覧

PipelineStackName |

前工程でパイプラインを作成したスタック名を入力します。 |

ImageName |

作成するAMIの名前を指定します。 |

EnableImageTests |

Image Builderは作成したAMIが正常に稼働するかをテストする機能があります。その自動テストを実施するかしないかを選択します。パイプラインではテスト定義をしていないため、falseを指定します。 |

コマンド例

aws cloudformation create-stack \

--stack-name ytera-vsimage-ami-creation \

--template-body file://ami-creation-execution.yaml \

--parameters \

ParameterKey=PipelineStackName,ParameterValue=ytera-vsimage-pipeline \

ParameterKey=ImageName,ParameterValue=ytera-vsimage-ami \

ParameterKey=EnableImageTests,ParameterValue=false \

--region ap-northeast-1EC2インスタンスの作成手順

AMIが正常に作成できたら、EC2インスタンス構築テンプレート ec2-launch-from-ami.yaml を開発者として実行します。これにより個人の環境にEC2インスタンスを起動します。このスタック実行にはおおよそ10分ほどかかります。

パラメータ一覧

AmiCreationStackName |

前工程でAMIを作成したスタック名を入力します。 |

InstanceType |

Ubuntuを稼働させるインスタンスタイプを指定します。Gravitonである必要があります。初期値はt4g.large。 |

VpcId |

Ubuntuを稼働させるVPC IDを指定します。 |

SubnetId |

Ubuntuを稼働させるサブネットIDを指定します。パブリックサブネットである必要あります。 |

AllowedSubnet |

Ubuntuへ接続可能なPCのCIDRを指定します。ここで指定したCIDRからUbuntuのTCP 8443ポート、443ポートが許可されます。 |

DomainName |

Ubuntuのホスト名を含むFQDNを指定します。これがブラウザからアクセスするときのURLとなります。 |

Route53HostZoneId |

FQDNで指定したドメインを定義しているRoute 53のゾーンIDを指定します。このゾーンIDに対してAレコードを追加します。 |

PasswordParameterName |

EC2インスタンスのUbuntuルートパスワードとして設定する文字列を収納しているパラメータストアキー名を指定します。 |

EMAIL |

SSLサーバ証明書に埋め込むメールアドレスを指定します。何でもかまいません。 |

コマンド例

aws cloudformation create-stack \

--stack-name ytera-vsimage-user1-instance \

--template-body file://ec2-launch-from-ami.yaml \

--parameters \

ParameterKey=AmiCreationStackName,ParameterValue=ytera-vsimage-ami-creation \

ParameterKey=InstanceType,ParameterValue=t4g.large \

ParameterKey=SubnetId,ParameterValue=subnet-0d29XXXXXXXXXXXXXXd \

ParameterKey=VpcId,ParameterValue=vpc-0e98dXXXXXXXXXXXXXX \

ParameterKey=AllowedSubnet,ParameterValue=2XX.2XX.XX.XX/32 \

ParameterKey=DomainName,ParameterValue=ytera-vsimage-user1-instance.example.com \

ParameterKey=Route53HostZoneId,ParameterValue=Z09XXXXXXXXXXXXXXXXXXXX \

ParameterKey=PasswordParameterName,ParameterValue=/ytera-vsimage/user1-password \

ParameterKey=EMAIL,[email protected] \

--capabilities CAPABILITY_NAMED_IAM \

--region ap-northeast-1Ubuntuへアクセス

EC2インスタンス構築テンプレート ec2-launch-from-ami.yaml が正常終了すると、EC2へアクセスするURLが指定したFQDNを下に出力されます。スタックのOutputページを見ていただき、そのURLにDCVでアクセスしてください。

DCVの認証は、Ubuntuの一般ユーザ(ubuntu)とCFnテンプレートで指定したパラメータストアのパスワードでログイン可能です。その後、Ubuntuのログイン画面が出ますが、同じIDとパスワードでログインします。

本ツールのユースケースと今後の課題

本ツールでは、開発環境となるAMI作成と、実際のインスタンス化の工程を分離しているのが特徴です。常に開発環境のバージョンをセキュアに最新に保ち開発者に提供することが比較的簡単にできます。

毎晩AMI作成を自動で実行するようにスケジュールを組んでおき、開発者は毎朝EC2を作成する運用とすることで実現可能です。EC2作成のスタックでは、AMI作成スタックが出力するAMI IDを参照しているので、開発者はどのAMIが最新であるかを意識する必要がありません。

ただ開発者の個人設定などのホームディレクトリを、インスタンス外に自動退避し、EC2作成時に自動で戻す仕組みがまだできていませんが。

ライトなユースケースでは、Ubuntuの開発者のホームディレクトリをS3マウントしておくだけでもよいかもしれません。

最後に。本記事は、広野さんの秀逸なCloudFormationがあったからこそ実現できました。ありがとうございました。

]]> 本記事は TechHarmony Advent Calendar 2025 12/23付の記事です。 本記事は TechHarmony Advent Calendar 2025 12/23付の記事です。 |

こんにちは。SCSK渡辺(大)です。

肩こりが酷すぎたのでYouTubeで首回りのストレッチ動画を参考にやってみたらスッキリしました。

首剥がしとストレートネック治しの動画はお勧めです。

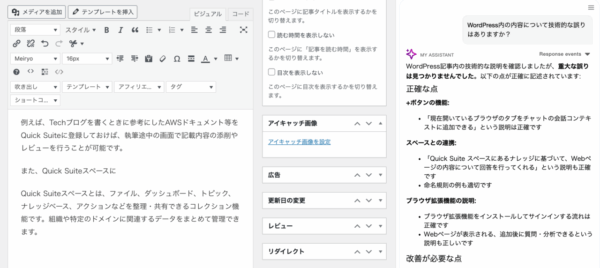

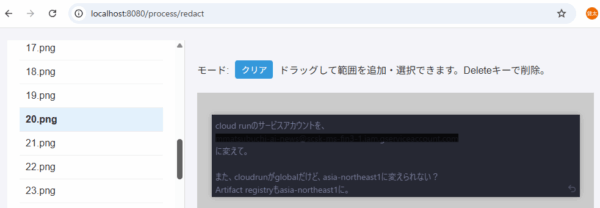

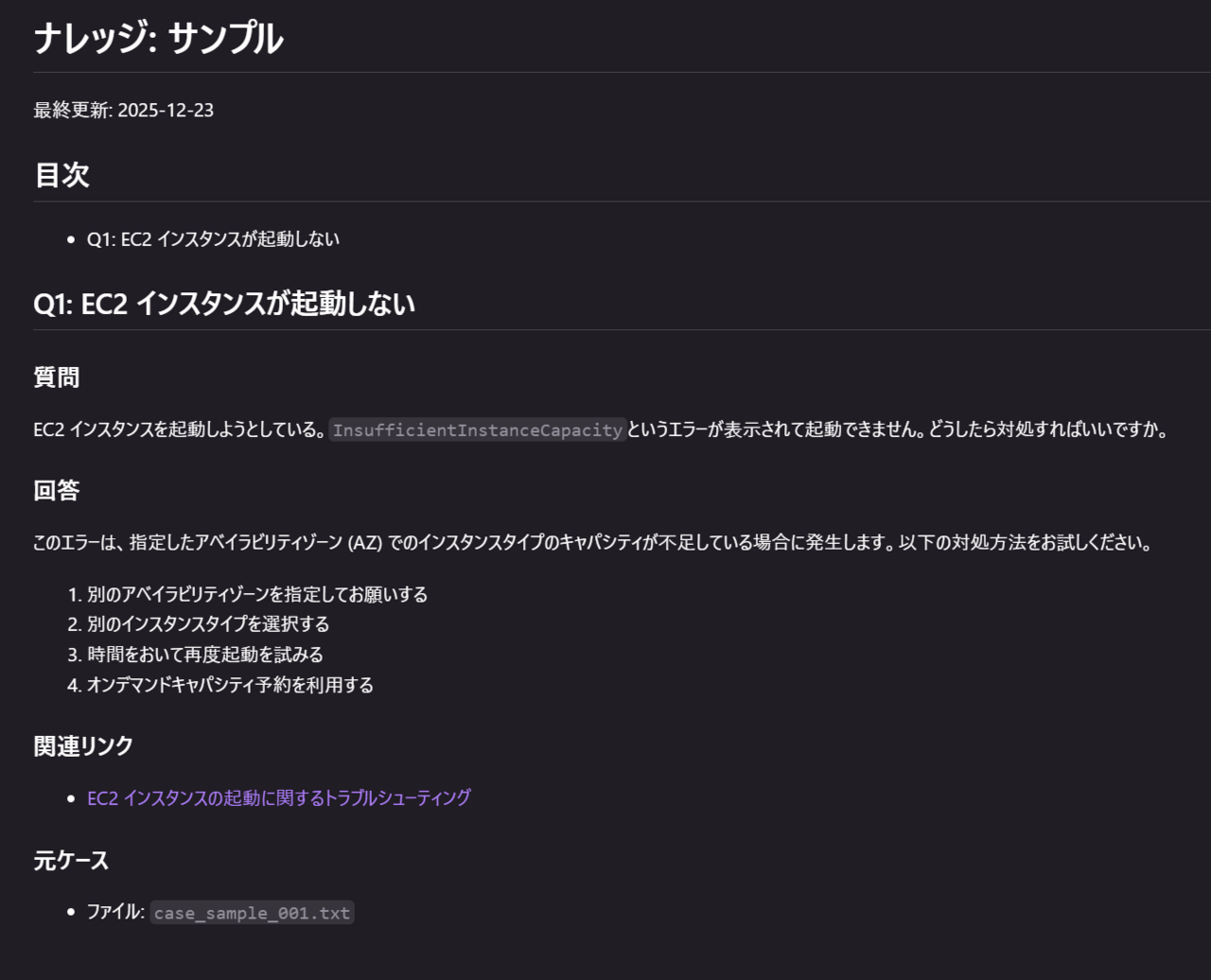

サンプルのナレッジ

以下のようなナレッジを作ることが出来ました。

背景

楽してナレッジを作りたかったのです。

AIの進化のおかげで重たい腰が上がった

※あくまで一個人の見解です。

恐らく1年前だったら1つのケースをナレッジ化するのに1分掛かるか、トークンが多すぎて1度の指示で全てのケースをナレッジ化することは出来なかったかと思います。

それが今では、スクリプトの作成から始め、スクリプトの実行、ケースをカテゴリ別に仕分け、すべてのケースのナレッジ化までを丸っとAIにお任せすることが出来ます。

※Kiroに実行許可をしていない場合には、スクリプトの実行など必要なタイミングでは人間の介在が必要です

最早、AIが「AWS Support のケースをナレッジ化するために進化してきました!」と言っているようなものです。

なので有難く使わせてもらいました。

思い立ったが吉日

ということで早速取り掛かってみようと、AWSマネジメントコンソールの AWS Support の画面を眺めていたところ、約2年前のケースまでしか残っていませんでした。

調べてみたところ、AWS Supportのケース履歴は、AWSマネジメントコンソール上では直近24か月間(2年間)までしか残っていません。[1]

また、Boto3のリファレンス[2]では直近12か月(1年間)までとなっていますが、実際にはAWSマネジメントコンソールと同様に、直近24か月間(2年間)まで取得できます。(実際に試しました)

つまり、ナレッジ化したいと感じたらすぐに取り掛かったほうが良いということです。

理由は、直近24か月を超過したケースは見れなくなってしまうためです。

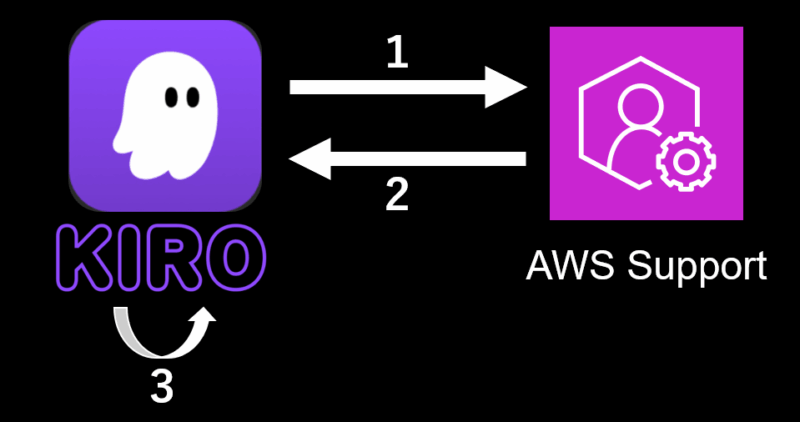

概要

AWS Support でクローズ済のケースをKiroにナレッジ化してもらいました。

大まかな流れ

- AWS Support ケース情報の取得(リクエスト)

- AWS Support ケース情報の取得(レスポンス)

- カテゴリ分類した後、カテゴリ単位でナレッジを作成

もう少し細かい流れ

Kiroに実行許可をしていない場合には、スクリプトの実行など必要なタイミングでは人間の介在が必要ですが、殆どKiroにお任せできます。

- ユーザーがKiroに指示文(後述)を伝える

- KiroがPython スクリプトを実行してケース情報を取得

- Kiroが進捗管理表を確認

- 存在する → 続きから処理(5 へ)

- 存在しない → 新規作成

- Kiroが未分類のケースを読み込み、進捗管理表に記録

- Kiroがカテゴリ単位で ナレッジ を作成し、進捗管理表を更新

- Kiroが未処理のケースがあるか確認

- ある → 3 へ戻る

- ない → 完了

- Kiroのセッションが中断した場合 → 新しいセッションで 2 へ戻る

必要なもの

- ローカル

- Kiro(他のエージェント型IDEでも良いと思いますが私は試してません)

- Pythonスクリプト(AWS Support ケース情報を取得する処理)

- boto3(Pythonスクリプトで使うため必要)

- Python 3.10 以上(boto3を使うために必要[3])

- AWS 認証情報(boto3を使うために必要)

- AWS CLI 2.32以上(aws loginでAWS認証する場合には必要)

- AWS

- AWS Support プラン(Developer/Business/Enterprise)

- AWS Support ケース(解決済み)

- IAM権限(以下)

-

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "sts:GetCallerIdentity", "support:DescribeCases", "support:DescribeCommunications" ], "Resource": "*" } ] }

-

Pythonスクリプト(AWS Support ケース情報を取得する処理)

畳んでいます。

Pythonスクリプト

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

AWS Support ケースダウンローダー

サポートケースをダウンロードし、

各ケースをテキストファイルとして保存する。

"""

import json

import logging

import os

import sys

from datetime import datetime

from pathlib import Path

import boto3

from botocore.exceptions import NoCredentialsError, ClientError, BotoCoreError

OUTPUT_DIR = 'support_cases'

EXCLUDED_KEYWORDS = [

"[除外したいケース名に含むキーワード1]",

"[除外したいケース名に含むキーワード2]"

]

def setup_logging() -> logging.Logger:

"""ロギング設定"""

os.makedirs(OUTPUT_DIR, exist_ok=True)

timestamp = datetime.now().strftime('%Y%m%d_%H%M%S')

log_file = f"{OUTPUT_DIR}/download_{timestamp}.log"

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(levelname)s - %(message)s',

handlers=[

logging.FileHandler(log_file, encoding='utf-8'),

logging.StreamHandler(sys.stdout)

]

)

return logging.getLogger(__name__)

def get_aws_credentials():

"""認証情報を取得"""

# ~/.aws/credentials があればboto3デフォルトに任せる

creds_file = Path.home() / '.aws' / 'credentials'

if creds_file.exists():

return 'default'

# aws login キャッシュから取得

cache_dir = Path.home() / '.aws' / 'login' / 'cache'

if not cache_dir.exists():

return None

cache_files = list(cache_dir.glob('*.json'))

if not cache_files:

return None

latest_file = max(cache_files, key=lambda f: f.stat().st_mtime)

with open(latest_file, 'r', encoding='utf-8') as f:

data = json.load(f)

token = data.get('accessToken', {})

return {

'aws_access_key_id': token.get('accessKeyId'),

'aws_secret_access_key': token.get('secretAccessKey'),

'aws_session_token': token.get('sessionToken'),

}

def create_session(logger):

"""boto3 セッション作成"""

creds = get_aws_credentials()

if creds == 'default':

logger.info("Using ~/.aws/credentials")

return boto3.Session(region_name='us-east-1')

if not creds or not creds.get('aws_access_key_id'):

raise NoCredentialsError()

logger.info("Using aws login cache")

return boto3.Session(

aws_access_key_id=creds['aws_access_key_id'],

aws_secret_access_key=creds['aws_secret_access_key'],

aws_session_token=creds['aws_session_token'],

region_name='us-east-1'

)

def validate_credentials(session, logger):

"""認証情報の有効性をテスト"""

try:

sts = session.client('sts')

identity = sts.get_caller_identity()

logger.info(f"認証成功: {identity.get('Arn', 'Unknown ARN')}")

return True

except ClientError as e:

error_code = e.response['Error']['Code']

if error_code in ['InvalidUserID.NotFound', 'AccessDenied', 'TokenRefreshRequired', 'ExpiredToken', 'ExpiredTokenException']:

logger.error("AWS認証情報が無効または期限切れです。認証情報を確認してください。")

else:

logger.error(f"AWS API エラー: {error_code} - {e.response['Error']['Message']}")

return False

except BotoCoreError as e:

logger.error(f"AWS接続エラー: {e}")

logger.error("ネットワーク接続またはAWS認証情報を確認してください。")

return False

except Exception as e:

logger.error(f"認証テスト中の予期しないエラー: {e}")

import traceback

logger.error(traceback.format_exc())

return False

def download_cases(session, logger):

"""全サポートケースをダウンロードして保存"""

try:

client = session.client('support', region_name='us-east-1')

except Exception as e:

logger.error(f"Supportクライアント作成エラー: {e}")

raise

logger.info("Fetching cases...")

cases = []

next_token = None

try:

while True:

params = {'maxResults': 100, 'includeResolvedCases': True}

if next_token:

params['nextToken'] = next_token

response = client.describe_cases(**params)

cases.extend(response.get('cases', []))

next_token = response.get('nextToken')

if not next_token:

break

except ClientError as e:

error_code = e.response['Error']['Code']

if error_code == 'SubscriptionRequiredException':

logger.error("AWS Supportプランが必要です。Basic以上のサポートプランに加入してください。")

return 0

else:

logger.error(f"ケース取得エラー: {error_code} - {e.response['Error']['Message']}")

return 0

except Exception as e:

logger.error(f"ケース取得中の予期しないエラー: {e}")

return 0

logger.info(f"Found {len(cases)} cases")

saved_count = 0

for idx, case in enumerate(cases, 1):

case_id = case['caseId']

subject = case.get('subject', '')

logger.info(f"[{idx}/{len(cases)}] Processing: {case_id}")

# 除外キーワードのチェック

if any(kw in subject for kw in EXCLUDED_KEYWORDS):

logger.info(f" -> Excluded (keyword): {subject[:50]}")

continue

# 進行中のケース(クローズしていないケース)を除外

status = case.get('status', '').lower()

if status != 'resolved':

logger.info(f" -> Excluded (not resolved): {subject[:50]} (status: {status})")

continue

try:

comms = []

comm_token = None

while True:

params = {'caseId': case_id}

if comm_token:

params['nextToken'] = comm_token

resp = client.describe_communications(**params)

comms.extend(resp.get('communications', []))

comm_token = resp.get('nextToken')

if not comm_token:

break

filename = f"{OUTPUT_DIR}/case_{case_id}.txt"

with open(filename, 'w', encoding='utf-8') as f:

f.write(f"ケースID: {case_id}\n")

f.write(f"件名: {subject}\n")

f.write(f"ステータス: {case.get('status', '')}\n")

f.write(f"作成日時: {case.get('timeCreated', '')}\n")

f.write(f"サービス: {case.get('serviceCode', '')}\n")

f.write(f"カテゴリ: {case.get('categoryCode', '')}\n")

f.write(f"重要度: {case.get('severityCode', '')}\n")

f.write("=" * 60 + "\n\n")

for i, comm in enumerate(comms, 1):

f.write(f"--- メッセージ {i} ---\n")

f.write(f"送信者: {comm.get('submittedBy', '')}\n")

f.write(f"日時: {comm.get('timeCreated', '')}\n")

f.write(f"内容:\n{comm.get('body', '')}\n\n")

saved_count += 1

logger.info(f" -> Saved: {filename}")

except Exception as e:

logger.error(f" -> Error: {e}")

logger.info(f"Completed: {saved_count} cases saved to {OUTPUT_DIR}/")

return saved_count

def main():

logger = setup_logging()

logger.info("Starting download...")

try:

session = create_session(logger)

# 認証情報の有効性をテスト